智联招聘作为中国领先的招聘平台,拥有海量的企业招聘信息和求职者简历数据,这些数据对于企业招聘、市场分析、行业研究等具有重要价值,开发针对智联招聘的爬虫成为许多开发者和数据分析师的需求,但同时也伴随着技术挑战和法律风险,本文将详细探讨智联招聘招聘网爬虫的开发方法、技术实现、注意事项及合规问题。

智联招聘爬虫的开发通常涉及以下几个核心步骤:目标分析、请求模拟、数据解析、存储与反爬应对,目标分析阶段需要明确爬取的数据类型,如职位名称、薪资范围、工作地点、公司信息、岗位职责、任职要求等,通过对智联招聘的网页结构进行分析,发现这些数据主要分布在职位列表页、职位详情页以及公司页面,职位列表页通过HTML表格或div列表展示多个职位的基本信息,而详情页则包含更完整的职位描述和公司背景。

在技术实现层面,Python是开发爬虫的首选语言,结合Requests库发送HTTP请求,BeautifulSoup或lxml库解析HTML,以及Pandas库进行数据整理,由于智联招聘对爬虫有较强的反爬机制,直接请求可能会被拦截,因此需要模拟真实用户行为,具体措施包括:设置合理的请求头(如User-Agent、Referer),控制请求频率(使用time.sleep随机延迟),使用代理IP池避免单一IP被封禁,智联招聘可能通过JavaScript动态加载数据,此时需借助Selenium或Playwright等自动化工具模拟浏览器操作,等待异步数据加载完成后提取内容,通过Selenium的WebDriver控制Chrome浏览器,定位元素并获取职位详情,再结合XPath或CSS选择器解析数据。

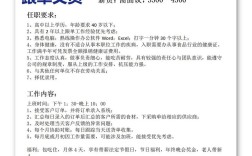

数据存储方面,根据数据量和用途可选择不同的存储方式,小规模数据可直接保存为CSV或Excel文件,使用Pandas的DataFrame结构化存储;大规模数据则需使用数据库,如MySQL(关系型)存储结构化数据,MongoDB(非关系型)存储半结构化数据,将职位信息存储为表格形式,包含字段:职位ID、名称、公司、薪资、地点、发布时间等,便于后续分析。

开发智联招聘爬虫必须严格遵守法律法规和平台规则,根据《中华人民共和国网络安全法》和《个人信息保护法》,爬取公开数据时不得侵犯用户隐私或企业商业秘密,且需遵守Robots协议,智联招聘的Robots协议明确限制了爬虫的访问范围,例如禁止爬取简历信息和部分动态加载内容,违规爬取可能导致IP被封禁、法律诉讼甚至承担赔偿责任,建议在开发前仔细阅读平台条款,优先使用官方API(如有)获取数据,或仅爬取公开的职位信息(不含个人联系方式),并设置合理的爬取频率,避免对服务器造成过大压力。

技术难点还包括验证码处理、登录状态维持和动态参数加密,智联招聘在频繁请求时可能弹出图形验证码或滑块验证,可通过第三方平台(如打码兔)识别,或降低请求频率减少触发,登录状态需通过Cookies或Session维持,可使用Requests-Session对象保持会话,对于动态参数(如token、sign),需通过分析网络请求包,逆向生成加密逻辑,但这通常需要较高的技术能力。

智联招聘爬虫的开发需要结合技术手段与合规意识,从目标分析到技术实现,再到反爬应对和数据存储,每个环节都需精心设计,开发者应平衡数据需求与法律风险,避免因小失大,以下为相关FAQs:

FAQs

-

问:开发智联招聘爬虫是否违法?如何规避法律风险?

答:开发爬虫本身不违法,但需遵守法律法规和平台规则,若爬取公开数据(如职位信息)且未用于商业用途,风险较低;若爬取用户隐私数据(如简历联系方式)或违反Robots协议,则可能构成侵权或违法,规避风险的方法包括:仅爬取公开数据、设置合理爬取频率、尊重平台条款、避免数据滥用,优先使用官方API。 (图片来源网络,侵删)

(图片来源网络,侵删) -

问:智联招聘的反爬机制有哪些?如何应对?

答:智联招聘的反爬机制主要包括:IP封禁、验证码(图形/滑块)、请求频率限制、动态参数加密、登录状态校验等,应对措施包括:使用代理IP池轮换IP、通过第三方打码平台识别验证码、控制请求间隔(如5-10秒)、模拟浏览器行为(Selenium/Playwright)、分析加密逻辑生成动态参数,以及通过Cookies维持登录状态,需定期更新爬虫策略以适应平台反爬升级。