在Linux系统中,查看文件编码是处理文本文件时常见的操作,尤其是当文件可能包含非UTF-8编码(如GBK、ISO-8859-1等)时,正确的编码识别能避免乱码问题,以下是几种常用的Linux查看文件编码命令及其详细用法。

file命令:最基础的编码检测工具

file命令是Linux系统中最基础的文件类型检测工具,通过分析文件的魔数(magic number)或内容特征来判断文件类型和编码,其基本语法为:

file -i filename

检测一个名为test.txt的文件编码:

file -i test.txt

输出可能为:

test.txt: text/plain; charset=utf-8其中charset=utf-8直接指明了文件编码,若文件编码为GBK,输出可能为charset=gbk。file命令对大多数常见编码(如UTF-8、GBK、ISO-8859-1等)有较好的识别能力,但可能无法区分某些相似编码(如UTF-16和UTF-32)。

enca命令:更强大的编码检测工具

enca是一个专门用于检测和转换文件编码的工具,支持更多编码类型和语言环境,安装方法(以Debian/Ubuntu为例):

sudo apt-get install enca

基本语法:

enca filename

enca test.txt

输出可能为:

Universal transformation format 8 bits; UTF-8若需指定语言环境以提高检测准确性,可使用:

enca -L zh_CN filename

enca的优势在于对中文编码(如GBK、Big5)的识别更精准,且能直接输出编码名称。

iconv命令:编码转换与验证

iconv主要用于编码转换,但结合-f参数可间接验证文件编码,尝试将文件从GBK转换为UTF-8:

iconv -f gbk -t utf-8 -o output.txt input.txt

若转换成功且输出无乱码,则文件可能为GBK编码,若报错(如iconv: illegal input sequence at position 10),则说明编码假设错误,此方法适合已知可能的编码范围时进行验证。

hexdump或xxd命令:十六进制分析

对于无法通过工具自动识别的文件,可通过查看十六进制内容手动判断编码,UTF-8文件以EF BB BF开头(BOM头),GBK文件无固定BOM但可通过特定字节模式识别:

xxd -l 20 filename # 查看文件前20字节的十六进制

通过对比编码表(如UTF-8、GBK的编码规则)可手动判断编码。

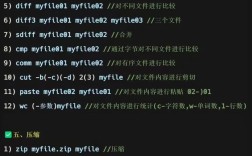

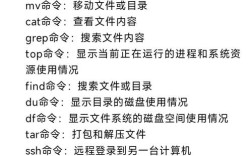

其他工具

- od命令:以八进制或十六进制显示文件内容,与

xxd类似。 - vim/nano编辑器:打开文件时,若编码不匹配会显示乱码,可通过编辑器的编码设置(如

set encoding=utf-8)尝试调整。

不同工具的对比

| 工具 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|

| file | 系统自带,简单快速 | 对复杂编码识别有限 | 快速检测常见编码 |

| enca | 支持多语言,识别精准 | 需额外安装,部分系统默认无 | 中文文件编码检测 |

| iconv | 可直接转换,验证编码 | 需预先假设编码,可能误判 | 已知编码范围时的验证与转换 |

| xxd | 手动分析,灵活 | 需专业知识,效率低 | 疑难杂症编码分析 |

相关问答FAQs

Q1: 为什么file命令有时无法正确识别文件编码?

A: file命令依赖文件的特征字节或BOM头,对于无BOM的UTF-8文件或某些编码(如UTF-16),可能误判为其他编码,文件内容较短或编码混合时也会影响识别准确性,此时可结合enca或手动十六进制分析。

Q2: 如何批量检测目录下所有文件的编码?

A: 可结合find和xargs命令实现批量检测,检测当前目录下所有.txt文件的编码:

find . -type f -name "*.txt" -exec file -i {} \; | grep charset

或使用enca:

find . -type f -name "*.txt" -exec enca {} \;

此方法可快速定位目录中可能存在编码问题的文件。