PHP获取网页内容终极指南:从入门到精通,5种实用方法助你高效抓取数据

** 在Web开发的世界里,使用PHP获取其他网页的内容是一项非常常见且强大的技能,无论是实现数据抓取、内容聚合、API调用,还是简单的页面信息读取,掌握PHP获取网页内容的方法都至关重要,本文将作为你的终极指南,从最基础的file_get_contents()到更专业的cURL库,详细讲解5种实用方法,并提供代码示例、优缺点分析及最佳实践,助你从新手成长为高手,轻松应对各种开发场景。

引言:为什么你需要用PHP获取网页内容?

在开始之前,我们先思考一个问题:为什么开发者需要用PHP去“抓取”或“获取”一个网页的内容?

想象一下这些场景:

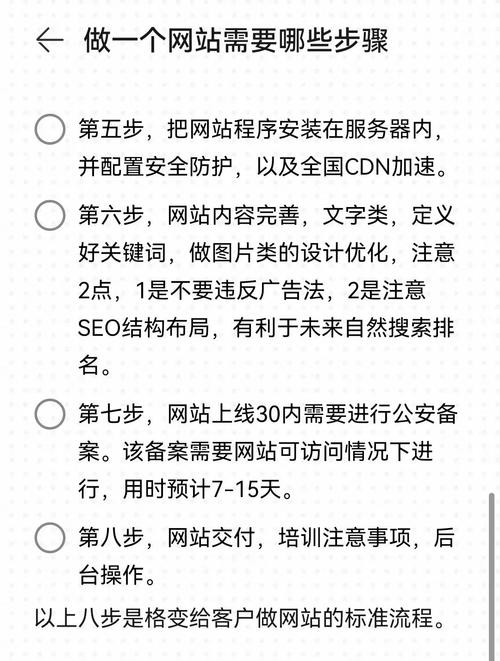

- 内容聚合: 创建一个新闻聚合网站,自动抓取各大头条新闻,展示在你的平台上。

- 数据监控: 定期检查竞争对手的网站价格或动态,及时调整自己的策略。

- API集成: 调用第三方服务(如天气API、汇率API)的数据,并将其展示给你的用户。

- SEO分析: 自动获取页面的标题、关键词、描述等信息,进行网站诊断。

- 简单信息读取: 只需要从某个页面提取一小段文本或一个链接。

无论你是做企业官网、电商平台还是个人博客,这项技能都能为你打开一扇新的大门,PHP究竟如何实现呢?让我们从最简单的方法开始,一步步深入。

使用 file_get_contents() — 最简单快捷的方式

file_get_contents() 是PHP内置的一个函数,用于将整个文件读入一个字符串,如果文件是URL,它还会尝试获取远程文件的内容,这是最直观、最入门的方法。

代码示例:

<?php

// 目标网页URL

$url = 'https://www.example.com';

// 尝试获取网页内容

$html = @file_get_contents($url); // 使用@抑制可能抛出的警告

// 判断是否获取成功

if ($html !== false) {

echo "成功获取网页内容!内容长度:" . strlen($html) . " 字符";

// 如果你想打印内容,请注意HTML源码可能非常长

// echo $html;

} else {

echo "获取网页内容失败,请检查URL或网络连接。";

}

?>

优点:

- 极其简单: 代码量最少,一行代码即可搞定。

- 无需扩展: 作为PHP核心函数,无需额外安装任何扩展。

缺点:

- 功能有限: 不支持POST请求、无法自定义HTTP头(如User-Agent)、无法处理重定向、无法设置超时时间。

- 性能依赖: 在

php.ini中,allow_url_fopen选项必须开启(默认是开启的),否则无法工作。 - 安全性: 容易被网站的反爬虫机制识别和屏蔽,因为它发送的HTTP头非常“标准”且容易被识别为脚本。

适用场景:

快速抓取简单的、无反爬虫机制的静态网页,或者进行一些简单的API GET请求。

使用 file() — 按行获取内容

file() 函数与 file_get_contents() 类似,但它会将网页的每一行内容作为一个数组的元素返回。

代码示例:

<?php

$url = 'https://www.example.com';

$lines = @file($url, FILE_IGNORE_NEW_LINES | FILE_SKIP_EMPTY_LINES);

if ($lines !== false) {

echo "成功获取网页内容,共 " . count($lines) . " 行,\n";

// 打印前5行内容

for ($i = 0; $i < 5 && $i < count($lines); $i++) {

echo "第 " . ($i + 1) . " 行: " . $lines[$i] . "\n";

}

} else {

echo "获取网页内容失败。";

}

?>

优点:

- 适用于需要逐行处理HTML源码的场景。

- 同样简单易用。

缺点:

- 与

file_get_contents()共享几乎所有的缺点,功能更弱,灵活性更低。

适用场景:

当你确实需要按行处理远程文件内容时,否则优先使用 file_get_contents()。

使用 cURL — 专业级、功能强大的选择

cURL (Client URL Library) 是一个利用URL语法在命令行下传输文件的工具,PHP也支持它。cURL 是专业开发者获取网页内容的首选,因为它提供了无与伦比的灵活性和控制力。

代码示例:

<?php

$url = 'https://www.example.com';

// 1. 初始化cURL会话

$ch = curl_init();

// 2. 设置cURL选项

curl_setopt($ch, CURLOPT_URL, $url); // 设置请求的URL

curl_setopt($ch, CURLOPT_RETURNTRANSFER, true); // 将curl_exec()获取的信息以字符串返回,而不是直接输出

curl_setopt($ch, CURLOPT_HEADER, false); // 不响应头

curl_setopt($ch, CURLOPT_USERAGENT, 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'); // 模拟浏览器UA

curl_setopt($ch, CURLOPT_FOLLOWLOCATION, true); // 跟随重定向

curl_setopt($ch, CURLOPT_CONNECTTIMEOUT, 10); // 连接超时时间(秒)

curl_setopt($ch, CURLOPT_TIMEOUT, 30); // 总执行超时时间(秒)

// 3. 执行cURL会话

$html = curl_exec($ch);

// 4. 检查是否有错误发生

if (curl_errno($ch)) {

echo 'cURL错误: ' . curl_error($ch);

} else {

// 获取HTTP状态码

$httpCode = curl_getinfo($ch, CURLINFO_HTTP_CODE);

if ($httpCode == 200) {

echo "成功获取网页内容!内容长度:" . strlen($html) . " 字符";

// echo $html;

} else {

echo "请求失败,HTTP状态码: " . $httpCode;

}

}

// 5. 关闭cURL会话

curl_close($ch);

?>

优点:

- 功能强大: 支持几乎所有HTTP协议,包括GET、POST、PUT、DELETE等。

- 高度可控: 可自定义HTTP头、Cookie、User-Agent、认证信息、超时时间等。

- 稳定可靠: 支持SSL/TLS加密,可以处理HTTPS网站。

- 处理重定向: 可以轻松跟随页面跳转。

- 性能更好: 相比

file_get_contents,在处理复杂请求时更稳定。

缺点:

- 稍显复杂: 代码量比前两种方法多,需要理解

curl_setopt()的各种选项。 - 需要扩展: PHP服务器必须安装并启用

cURL扩展(绝大多数环境都已默认安装)。

适用场景:

几乎所有需要获取网页内容的正式项目,特别是需要发送POST请求、设置请求头、处理登录、绕过简单反爬虫等场景。

使用 fsockopen() — 底层socket操作

这是一种更底层的方法,直接通过Socket连接到服务器并发送HTTP请求,它非常灵活,但实现起来也最复杂,通常不推荐在日常开发中使用,除非你需要处理一些非常特殊的网络协议。

代码示例:

<?php

$url = 'www.example.com'; // 注意:这里只需要主机名

$port = 80;

$path = '/';

// 创建socket连接

$fp = @fsockopen($url, $port, $errno, $errstr, 10);

if (!$fp) {

echo "错误: $errstr ($errno)\n";

} else {

// 发送HTTP请求

$out = "GET $path HTTP/1.1\r\n";

$out .= "Host: $url\r\n";

$out .= "Connection: Close\r\n\r\n";

fwrite($fp, $out);

// 读取响应

$response = '';

while (!feof($fp)) {

$response .= fgets($fp, 128);

}

fclose($fp);

// 通常响应包含头部和正文,需要分割

list($header, $body) = explode("\r\n\r\n", $response, 2);

echo "成功获取网页正文!\n";

// echo $body;

}

?>

优点:

- 极致灵活: 可以构建完全自定义的HTTP请求。

- 不依赖特定扩展: 只需要基本的socket支持。

缺点:

- 极其复杂: 需要手动处理HTTP协议细节,包括请求头、响应头、状态码、编码等。

- 开发效率低: 代码量大,容易出错。

适用场景:

学习HTTP协议底层原理,或者有特殊需求无法使用cURL时。

使用第三方库 — 如Guzzle

对于大型项目或追求代码优雅、可维护性的开发者来说,使用第三方HTTP客户端库是最佳选择,Guzzle是目前PHP社区最流行、功能最强大的HTTP客户端之一。

准备工作:

首先需要通过Composer安装Guzzle:

composer require guzzlehttp/guzzle

代码示例:

<?php

// 引入Composer自动加载器

require 'vendor/autoload.php';

use GuzzleHttp\Client;

use GuzzleHttp\Exception\RequestException;

$url = 'https://www.example.com';

// 创建一个Guzzle客户端

$client = new Client();

try {

// 发送一个GET请求

$response = $client->request('GET', $url, [

'timeout' => 10.0, // 设置超时

'headers' => [

'User-Agent' => 'My-Cool-Scraper/1.0',

]

]);

// 获取响应体内容

$html = $response->getBody()->getContents();

echo "成功获取网页内容!状态码: " . $response->getStatusCode() . "\n";

// echo $html;

} catch (RequestException $e) {

// 处理请求异常(如超时、404、500等)

echo "请求失败: " . $e->getMessage();

if ($e->hasResponse()) {

echo ",状态码: " . $e->getResponse()->getStatusCode();

}

}

?>

优点:

- 面向对象: 代码结构清晰,易于理解和维护。

- 功能丰富: 支持异步请求、Promise、中间件、插件等高级特性。

- 异常处理: 提供了完善的异常处理机制。

- 社区活跃: 文档齐全,遇到问题容易找到解决方案。

缺点:

- 需要引入依赖: 需要通过Composer管理,不适合追求极简的脚本。

适用场景:

中大型项目、API服务、任何需要健壮、可维护HTTP通信的PHP应用。

对比总结与最佳实践

| 方法 | 易用性 | 功能性 | 灵活性 | 推荐指数 |

|---|---|---|---|---|

file_get_contents() |

⭐⭐⭐⭐⭐ | ⭐ | ⭐ | ⭐⭐ (仅限简单场景) |

file() |

⭐⭐⭐⭐ | ⭐ | ⭐ | ⭐ (场景极少) |

cURL |

⭐⭐⭐ | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ (首选) |

fsockopen() |

⭐ | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | ⭐ (仅限学习/特殊需求) |

| Guzzle | ⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ (专业项目首选) |

最佳实践建议:

- 新手入门: 从

file_get_contents()开始,理解基本原理。 - 日常开发: 立即转向

cURL,它足够强大,能满足你90%以上的需求,并且是PHP内置的,无需额外依赖。 - 专业项目: 强烈推荐使用Guzzle,它能极大提升代码质量和开发效率,特别是在处理复杂API交互时。

- 尊重网站规则: 在抓取任何网站前,请务必阅读其

robots.txt文件(https://www.example.com/robots.txt)和《服务条款》,遵守爬虫规则,设置合理的请求间隔(如使用sleep()函数),避免对目标服务器造成过大压力。 - 处理编码问题: 获取到的内容可能是UTF-8、GBK等编码,使用

mb_detect_encoding()和mb_convert_encoding()函数确保内容在你的应用中正确显示。 - 错误处理是关键: 永远不要假设请求会100%成功,务必使用

try...catch或if判断来处理网络错误、404、500等各种异常情况。

“PHP如何获得网页内容”是PHP开发者绕不开的一个课题,从简单的file_get_contents()到专业的Guzzle库,每种方法都有其独特的价值和适用场景,希望这篇终极指南能帮助你找到最适合你的工具和方法。

技术是为解决问题服务的,选择正确的工具,结合良好的编码习惯和道德规范,你就能在Web开发的海洋中自由驰骋,高效地获取你所需的数据。就打开你的编辑器,动手实践一下吧!