在计算机系统中,字符编码是信息存储和传输的基础,不同的编码方式会导致文本数据的解析差异,尤其在命令行环境下,由于历史原因和系统多样性,编码问题时常引发困扰,命令行编码转换是指通过命令行工具对文本文件的编码格式进行识别、转换或处理的技术,其核心目的是解决因编码不一致导致的乱码、解析失败等问题,确保文本数据在不同平台、程序或场景下的正确显示与交互。

命令行编码转换的背景与必要性

早期计算机系统如ASCII编码仅支持128个字符,无法满足多语言需求,随后出现了ISO-8859系列、GBK、Big5等编码,分别针对不同语言或地区,Windows系统默认使用GBK(中文版)或UTF-16,而Linux/macOS默认使用UTF-8,这种差异导致跨平台文件传输时常出现乱码,在Windows中编辑的中文文本文件,若直接通过命令行传输到Linux系统,可能因GBK与UTF-8编码不匹配显示为乱码,某些老旧程序或特定协议(如邮件系统)仍依赖非UTF-8编码,因此通过命令行工具进行编码转换成为解决兼容性问题的关键手段。

常见编码格式及其特点

| 编码名称 | 特点 | 适用场景 |

|---|---|---|

| ASCII | 7位编码,支持128个英文字符,无扩展性 | 英文文本基础存储 |

| GBK | 双字节编码,包含20902个汉字,兼容ASCII,是中国大陆早期常用编码 | Windows中文系统、旧版软件 |

| UTF-8 | 变长编码(1-4字节),兼容ASCII,支持全球所有字符,Linux/macOS默认编码 | 现代跨平台文本、Web开发 |

| UTF-16 | 定长2字节或4字节,Windows内部默认编码,对部分语言处理效率较高 | Windows程序内部文本处理 |

| ISO-8859-1 | 单字节编码,支持西欧语言,无中文支持 | 早期欧洲系统、HTTP默认编码 |

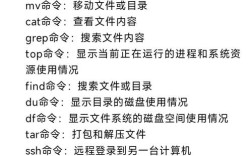

命令行编码转换工具及使用方法

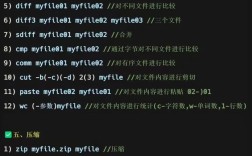

iconv工具:通用编码转换

iconv是Linux/macOS系统中广泛使用的编码转换工具,支持数百种编码格式之间的转换,基本语法为:

iconv -f 源编码 -t 目标编码 源文件 -o 输出文件

将GBK编码的input.txt转换为UTF-8编码并保存为output.txt:

iconv -f gbk -t utf-8 input.txt -o output.txt

若不确定源文件编码,可结合file命令预判:

file -i input.txt # 输出类似"input.txt: text/plain; charset=gbk"

enca工具:智能编码检测与转换

enca比iconv更智能,能自动检测文件编码并支持批量转换,安装后使用:

enca 源文件 # 检测文件编码 enca -x utf-8 源文件 # 转换为UTF-8编码

对于批量文件,可结合find命令:

find . -name "*.txt" -exec enca -x utf-8 {} \;

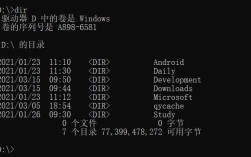

Windows命令行工具:chcp与certutil

Windows中可通过chcp切换当前控制台编码(如936代表GBK,65001代表UTF-8):

chcp 65001 # 切换为UTF-8编码 type input.txt # 显示UTF-8编码文件

certutil可用于文件编码转换,例如将UTF-8转为GBK:

certutil -encodehex -f input.txt output.txt

recode工具:高级编码处理

recode支持更复杂的编码转换规则,如将HTML实体转换为字符:

recode html..utf-8 input.html # 将HTML文件转为UTF-8

编码转换的常见问题与解决方案

-

问题1:转换后仍出现乱码

原因可能是源文件实际编码与指定编码不符,或文件包含BOM(字节顺序标记),可通过hexdump -C 文件名查看文件头是否含BOM(UTF-8的BOM为EF BB BF),使用sed命令删除BOM:sed -i '1s/^\xEF\xBB\xBF//' 文件名

-

问题2:批量转换效率低

对于大量文件,可编写脚本结合find和xargs并行处理:find . -type f -name "*.log" | xargs -P 4 -I {} sh -c 'iconv -f gbk -t utf-8 "{}" -o "{}.utf8" && mv "{}.utf8" "{}"'其中

-P 4表示并行4个进程,提升转换速度。

编码转换的最佳实践

- 优先使用UTF-8:UTF-8作为互联网标准编码,兼容性强,应作为跨平台文本的首选编码。

- 保留原始编码信息:转换前备份原文件,并记录原始编码,避免转换链过长导致信息丢失。

- 处理BOM标记:UTF-8文件是否添加BOM需根据场景选择,Web开发通常建议去除BOM,而某些Windows程序可能依赖BOM。

- 自动化脚本:通过Shell或Python脚本封装转换逻辑,例如使用Python的

chardet模块检测编码:import chardet with open('input.txt', 'rb') as f: result = chardet.detect(f.read()) print(f"检测到编码: {result['encoding']}")

相关问答FAQs

Q1:如何判断一个文本文件的具体编码?

A:可通过以下方法综合判断:

- 使用

file -i 文件名(Linux/macOS)或chcp命令(Windows)初步检查; - 用

hexdump -C 文件名查看文件头是否有BOM标记; - 通过文本编辑器(如VS Code)打开文件,状态栏通常会显示当前编码;

- 使用

chardet(Python库)或enca工具进行智能检测,例如chardet.detect(open('file', 'rb').read())。

Q2:命令行转换编码时如何处理特殊字符(如emoji)?

A:特殊字符(如emoji)通常需要UTF-8、UTF-16或UTF-32编码支持,转换时需确保目标编码包含这些字符,

- 使用

iconv -f utf-8 -t utf-16 input.txt -o output_utf16.txt将emoji转为UTF-16; - 若目标编码不支持(如GBK),需替换或删除特殊字符,可通过

sed命令过滤:sed -i 's/[^\x00-\x7F]//g' input.txt # 删除非ASCII字符

建议优先使用UTF-8编码,避免特殊字符丢失。