HDFS balance命令是Hadoop分布式文件系统中用于均衡各个DataNode存储使用情况的重要工具,在大规模Hadoop集群运行过程中,由于数据块分布不均、节点扩容、节点退役或数据删除等操作,可能导致不同DataNode的磁盘使用率存在较大差异,这种不平衡会影响数据的读写性能、负载均衡以及集群的整体可靠性,HDFS balance命令通过在DataNode之间迁移数据块,使得集群中所有DataNode的磁盘使用率趋于一致,从而优化集群的资源利用率。

HDFS balance命令的基本语法为hdfs balancer [-threshold <threshold>],其中-threshold参数用于指定均衡的阈值,该阈值表示均衡后每个DataNode的磁盘使用率与集群整体平均使用率的最大允许偏差,默认值为10%,当设置阈值为5%时,均衡完成后任何DataNode的磁盘使用率与集群平均使用率的差值不能超过5%,阈值的设置需要根据实际业务需求权衡,阈值过小可能导致均衡时间过长,阈值过大则可能无法达到理想的均衡效果。

执行HDFS balance命令前,需要确保集群处于稳定状态,避免在数据写入高峰期或节点故障期间进行均衡操作,以免影响业务性能,建议先通过hdfs dfsadmin -report命令查看各DataNode的磁盘使用情况,确定是否存在明显的不平衡现象,并记录当前的磁盘使用率作为后续对比的基准,如果集群中存在大量小文件,均衡过程可能会因为文件数量过多而延长执行时间,此时可以考虑结合HDFS的合并小文件工具(如CombineFileInputFormat)进行预处理。

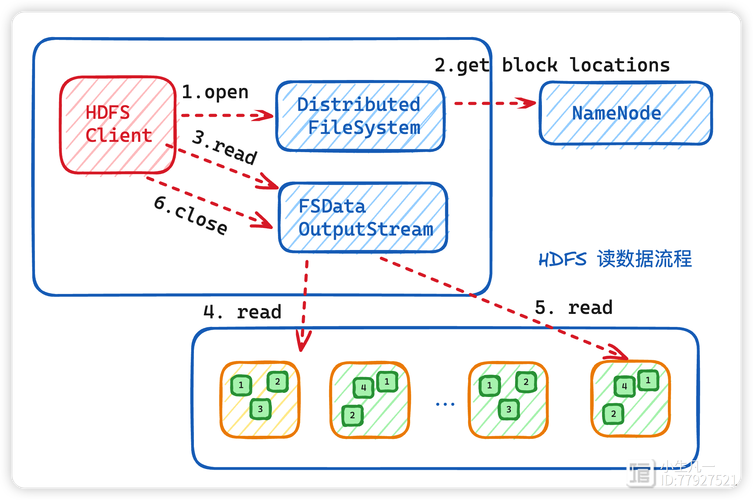

在执行均衡过程中,HDFS会根据各DataNode的磁盘使用率动态计算数据块的迁移策略,磁盘使用率较高的DataNode会作为数据源,将数据块迁移到磁盘使用率较低的DataNode上,迁移过程中,HDFS会保证数据的安全性,采用边复制边删除的方式,即在目标DataNode完成数据块复制后,才会从源DataNode上删除该数据块,确保数据不会丢失,均衡过程会控制数据迁移的带宽占用,避免对正常业务造成过大影响,默认情况下,HDFS会限制均衡使用的带宽为1MB/s,可以通过修改hdfs-site.xml配置文件中的dfs.balance.bandwidthPerSec参数来调整。

HDFS balance命令的执行状态可以通过日志或命令行界面进行监控,在命令行中,均衡过程中会实时显示已迁移的数据量、剩余数据量以及各DataNode的磁盘使用率变化情况,如果需要停止均衡过程,可以使用hdfs balancer -cancel命令,需要注意的是,停止操作不会立即中断正在执行的数据块迁移,而是会完成当前正在迁移的数据块后,不再启动新的迁移任务,因此停止后可能需要一定时间才能完全终止均衡过程。

为了更直观地展示均衡前后的效果,可以通过以下表格对比某集群在均衡前后的磁盘使用率情况:

| DataNode ID | 均衡前磁盘使用率 | 均衡后磁盘使用率 | 变化量 |

|---|---|---|---|

| datanode1 | 85% | 72% | -13% |

| datanode2 | 45% | 68% | +23% |

| datanode3 | 78% | 71% | -7% |

| datanode4 | 52% | 69% | +17% |

| datanode5 | 82% | 70% | -12% |

| 平均值 | 4% | 70% | +1.6% |

从表格中可以看出,均衡前各DataNode的磁盘使用率差异较大,最高为85%,最低为45%,相差40个百分点;均衡后最高为72%,最低为68%,相差仅4个百分点,集群的磁盘使用率趋于均衡,有效避免了部分节点因磁盘过载而影响整体性能的情况。

在实际应用中,HDFS balance命令的执行时间取决于集群规模、数据量、磁盘性能以及设置的阈值等因素,对于大规模集群,可能需要数小时甚至数天才能完成均衡操作,因此建议在业务低峰期执行,并结合集群的监控工具(如Ganglia、Prometheus等)实时观察集群的资源使用情况,确保均衡过程不会对业务造成负面影响,如果集群中存在多个机架或数据中心,HDFS的机架感知功能会影响数据块的迁移策略,均衡过程中会优先在同一机架内迁移数据,以减少跨机架的网络传输,提高迁移效率。

除了手动执行HDFS balance命令外,还可以结合Hadoop的调度工具(如Oozie、Azkaban)实现定时均衡任务,例如在每天凌晨业务低峰期自动执行均衡操作,以保持集群的长期稳定运行,在定时任务配置中,需要合理设置阈值和带宽限制,避免在均衡过程中占用过多网络资源或磁盘I/O,影响白天的正常业务。

需要注意的是,HDFS balance命令在执行期间会增加集群的网络和磁盘I/O负载,因此在资源紧张的集群中,建议适当降低迁移带宽或分阶段进行均衡,例如先对磁盘使用率差异较大的节点进行均衡,再逐步扩展到整个集群,均衡过程中应避免对HDFS进行其他大规模操作,如数据导入、集群扩容等,以免干扰均衡过程的正常进行。

在HDFS集群的日常运维中,除了定期执行均衡操作外,还应该结合数据存储策略、副本放置策略等进行综合优化,通过调整dfs.blocksize参数优化数据块大小,减少小文件对均衡性能的影响;通过设置dfs.replication参数合理控制数据副本数量,在保证数据可靠性的同时减少存储压力,及时清理不再使用的临时数据或过期数据,也能有效缓解磁盘使用率不均衡的问题。

相关问答FAQs:

-

问:执行HDFS balance命令时,如何判断集群是否已经达到均衡状态? 答:可以通过以下方式判断集群是否达到均衡状态:观察HDFS balance命令的输出界面,当显示“Balancing took XX seconds”且没有错误提示时,表示均衡过程已完成;使用

hdfs dfsadmin -report命令查看各DataNode的磁盘使用率,计算最大值与最小值的差值,如果差值小于设置的阈值(如默认的10%),则认为集群已达到均衡状态;也可以通过集群监控工具查看各节点的磁盘使用率趋势,确认使用率趋于稳定且差异在合理范围内。 -

问:HDFS balance命令执行过程中,如果遇到网络中断或节点故障,会导致数据丢失吗? 答:不会,HDFS balance命令在执行数据块迁移时,采用“先复制后删除”的机制,即只有在目标DataNode成功接收并验证数据块完整性后,才会从源DataNode上删除该数据块,如果在迁移过程中发生网络中断或节点故障,HDFS会自动记录未完成的迁移任务,并在网络恢复或节点修复后继续执行或重新调度,HDFS的副本机制保证了数据的多份存储,即使某个数据块迁移失败,其他副本仍然可用,不会导致数据丢失,需要注意的是,在故障恢复后,建议重新检查集群的均衡状态,必要时重新执行均衡命令。