数据抓取技术在招聘领域的应用日益广泛,成为企业优化招聘流程、提升招聘效率的重要工具,通过自动化程序从各大招聘网站、社交媒体、行业论坛等平台获取目标候选人信息,企业能够快速建立人才库,精准匹配岗位需求,同时降低传统招聘方式的时间成本和人力成本,数据抓取在招聘中的实践也涉及法律合规、技术实现和伦理边界等多重问题,需要企业在应用过程中审慎对待。

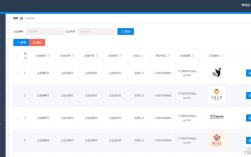

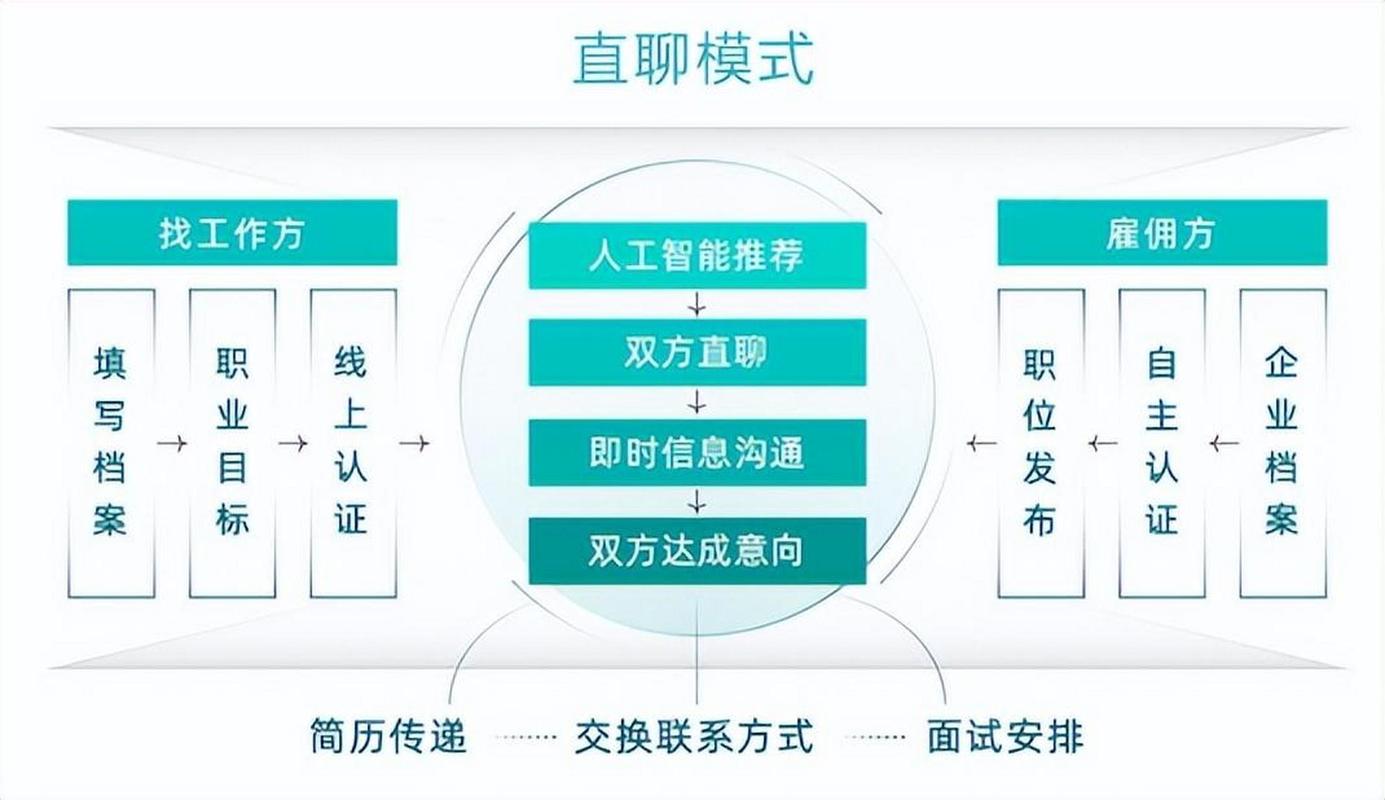

从技术实现角度看,招聘场景下的数据抓取通常分为三个核心环节:目标数据源确定、抓取策略设计和数据清洗与整合,目标数据源包括综合招聘平台(如智联招聘、前程无忧)、垂直领域招聘网站(如拉勾网、BOSS直聘)、职业社交平台(如LinkedIn、脉脉)以及企业官网的招聘页面,不同平台的数据结构和反爬机制存在差异,需制定针对性的抓取策略,对于动态加载的网页,需采用Selenium或Playwright等工具模拟浏览器行为;对于存在反爬机制的网站,需通过IP代理池、请求头随机化、验证码识别等技术规避限制,数据抓取的内容通常包括候选人的基本信息(姓名、年龄、学历)、职业经历(工作单位、职位、在职时间)、技能标签(编程语言、工具认证)以及联系方式(邮箱、电话)等,这些数据需通过正则表达式、XPath或CSS选择器进行结构化提取,再通过去重、格式标准化、缺失值填充等清洗步骤,确保入库数据的准确性和可用性。

数据抓取在招聘中的价值主要体现在三个方面:一是拓宽人才来源渠道,传统招聘依赖候选人主动投递,数据抓取可主动挖掘潜在候选人,尤其是那些未在求职状态但具备岗位匹配度的人才,如通过分析GitHub技术贡献发现优秀开发者,或通过行业论坛的专业发言识别领域专家,二是提升招聘效率,企业可通过抓取工具实时监测新发布的岗位信息,快速定位符合要求的候选人,减少人工筛选简历的时间成本,某互联网公司使用爬虫工具抓取拉勾网上的“Java开发工程师”岗位数据,按“3年以上经验”“熟悉Spring Boot”等条件筛选后,3天内获取200+份有效简历,而传统方式需1周完成,三是优化人才决策,通过抓取历史招聘数据,企业可分析不同渠道候选人的转化率、在职表现等指标,评估招聘渠道质量;结合市场薪酬数据抓取结果,制定更具竞争力的薪资方案,吸引核心人才。

尽管优势显著,招聘数据抓取也面临诸多挑战,法律合规性是首要问题,根据《个人信息保护法》,处理个人信息需取得个人同意,且不得过度收集,招聘数据抓取若涉及未公开的联系方式、身份证号等敏感信息,可能构成侵权,企业应优先选择公开数据源,或通过API接口获取授权数据,避免爬取用户隐私内容,技术实现方面,招聘平台的反爬措施不断升级,如IP封禁、行为验证(滑动拼图、点击验证)、动态Token验证等,要求爬虫程序具备更高的动态适应能力,数据质量直接影响招聘效果,部分候选人简历存在信息过时、夸大经历等问题,需通过交叉验证(如比对LinkedIn和脉脉信息)提升数据可信度,伦理层面,过度依赖数据抓取可能导致“简历轰炸”,候选人频繁收到无关招聘信息,影响用户体验,企业需控制抓取频率,避免对平台服务器造成过大压力。

为规范招聘数据抓取行为,企业可采取以下措施:建立合规审查机制,确保抓取数据来源合法、用途正当;采用分布式爬虫架构,降低单IP请求频率,减少对目标平台的干扰;部署数据脱敏模块,对抓取到的联系方式等敏感信息进行加密处理,仅向授权招聘人员开放查看权限,企业可结合自然语言处理(NLP)技术分析抓取到的文本数据,如从简历中提取技能关键词、量化工作成果,进一步优化人才画像与岗位的匹配精度。

相关问答FAQs:

-

招聘数据抓取是否合法?如何规避法律风险?

答:招聘数据抓取的合法性取决于数据来源和用途,若抓取公开信息(如岗位描述、公开简历)且用于企业自身招聘,通常不违法;但若抓取用户隐私信息(如未公开的联系方式、身份证号)或用于商业出售,则违反《个人信息保护法》,规避风险的方法包括:优先选择提供API接口的招聘平台获取数据;仅抓取公开可见的信息;对敏感数据进行脱敏处理;确保数据用途仅限于招聘且不超出必要范围。 -

如何提高招聘数据抓取的效率和质量?

答:提高效率可从三方面入手:一是优化爬虫架构,采用异步请求、分布式部署(如Scrapy-Redis)加快抓取速度;二是动态适配反爬机制,使用Selenium模拟浏览器操作、通过代理IP池轮换IP地址;三是设置智能重试机制,在遇到验证码或限流时自动切换策略,提升质量则需加强数据清洗环节,通过正则表达式统一格式、利用机器学习模型识别并过滤虚假信息(如夸大经历的简历),同时建立数据更新机制,定期验证候选人信息的时效性。