爬招聘数据是指通过网络爬虫技术从各大招聘网站、企业官网或行业垂直平台获取职位信息、薪资范围、任职要求等数据的过程,这一过程在职业规划、市场分析、企业招聘策略制定等领域具有广泛应用,但同时也涉及法律合规、数据伦理等问题,需要谨慎操作。

爬招聘数据的动机与应用场景

- 个人求职者:通过分析目标岗位的技能要求、薪资水平,优化简历内容,明确薪资谈判范围,或发现新兴职业方向,数据分析师岗位中Python、SQL的技能需求占比,或某城市互联网行业的平均薪资区间。

- 企业与HR:了解竞争对手的岗位设置、薪酬结构,调整自身招聘策略;或通过行业人才供给分析,判断招聘难度。

- 科研与咨询机构:收集劳动力市场数据,研究行业人才流动趋势、区域就业差异等课题,为政策制定或行业报告提供依据。

- 职业培训机构:根据热门岗位技能需求,设计课程体系,提升培训的针对性和就业率。

爬取数据的常见目标与字段

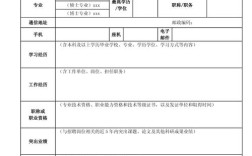

招聘数据通常包含结构化和非结构化信息,核心字段如下表所示:

| 数据类别 | 具体字段 |

|---|---|

| 职位基本信息 | 职位名称、公司名称、工作地点、发布时间、招聘人数、职位类型(全职/兼职/实习) |

| 薪资福利 | 薪资范围(如15-25K)、薪资构成(底薪+绩效+奖金)、福利(五险一金、年终奖等) |

| 任职要求 | 学历要求、工作经验年限、技能标签(如Python、数据分析)、语言能力 |

| 公司信息 | 公司规模、行业类型、融资阶段、企业简介 |

| 其他信息 | 职位描述、工作职责、简历投递方式、联系方式 |

爬取数据的实施步骤

- 明确目标与范围:确定爬取的网站(如智联招聘、BOSS直聘、猎聘等)、岗位关键词(如“数据分析师”“Java工程师”)、地域限制(如“北京”),避免数据冗余。

- 选择技术工具:

- 基础爬虫:使用Python的Requests库发送HTTP请求,BeautifulSoup或 lxml 解析HTML页面。

- 动态页面处理:针对JavaScript渲染的页面(如BOSS直聘),采用Selenium或Playwright模拟浏览器操作。

- 反反爬策略:设置User-Agent代理、随机IP池、请求间隔(如2-5秒),避免被网站封禁。

- 数据存储与清洗:将爬取的原始数据存储为CSV、Excel或数据库(如MySQL、MongoDB),通过Pandas进行去重、缺失值处理、格式标准化(如统一薪资单位为“元/月”)。

- 数据分析与应用:利用Matplotlib、Seaborn进行可视化(如薪资分布柱状图、技能词云),或通过机器学习模型预测岗位竞争力。

法律与伦理风险

- 平台协议与版权:多数招聘网站禁止未经授权的爬取行为,违反可能面临法律诉讼,LinkedIn曾起诉某公司爬取用户数据,最终赔偿赔偿1.2亿美元。

- 数据隐私保护:若爬取数据包含个人简历信息(如手机号、邮箱),需遵守《个人信息保护法》,确保数据脱敏或获得用户授权。

- 商业用途限制:企业将爬取数据用于商业竞争时,需避免不正当竞争行为,如恶意压低薪资或诋毁对手声誉。

替代方案与合规建议

- 官方API接口:部分平台提供开放API(如LinkedIn Talent Solutions),通过授权获取数据,合法且稳定。

- 第三方数据服务:采购专业机构(如艾瑞咨询、猎聘研究院)的行业报告,节省爬取成本。

- 公开数据集:利用政府发布的就业统计、高校就业质量报告等公开数据。

相关问答FAQs

Q1:爬取招聘数据是否违法?如何规避风险?

A1:爬取行为是否违法取决于数据用途和爬取方式,若仅用于个人研究且未违反平台协议,风险较低;若用于商业用途或爬取用户隐私数据,则可能触犯法律,规避方法包括:仔细阅读网站robots.txt协议、限制爬取频率、避免敏感字段(如个人联系方式)、优先选择官方API。

Q2:如何提高爬取效率并防止被封禁?

A2:可通过以下方式优化:①使用分布式爬虫框架(如Scrapy-Redis)并行爬取;②代理IP轮换(如购买商业代理服务);③设置随机延时和请求头伪装(如模拟不同浏览器);④针对反爬较强的网站,采用验证码识别工具(如Tesseract)或人工干预。