在数字化时代,数据已成为企业决策的核心资源,而爬虫技术作为高效获取数据的重要手段,在招聘领域也逐渐展现出独特价值,许多企业、招聘平台或第三方数据服务机构需要通过爬虫技术批量收集招聘信息,如岗位需求、薪资水平、任职要求等,以进行市场分析、竞品调研或人才匹配等工作,这种需求催生了“招聘爬虫兼职”这一灵活的就业形式,吸引了大量具备编程技能和时间自由的人群参与。

招聘爬虫兼职的工作内容与技能要求

招聘爬虫兼职的核心任务是根据需求方提供的目标网站(如企业官网、招聘平台、行业垂直社区等),编写或优化爬虫程序,自动化抓取指定数据,具体工作可能包括:分析目标网站结构,设计爬虫逻辑以绕过反爬机制(如验证码、IP限制、动态加载等);清洗和整理抓取到的数据,确保格式规范、信息完整;定期维护爬虫程序,应对网站更新导致的抓取失败问题;以及提交结构化数据(如Excel、CSV或数据库文件)并配合需求方进行结果验证。

这类兼职对技能的要求较为明确,首先需要熟练掌握至少一种编程语言,Python是主流选择,因其拥有Scrapy、BeautifulSoup、Selenium等丰富的爬虫库和框架;其次需熟悉HTTP协议、HTML/CSS/JavaScript基础,能够定位网页数据元素;了解反爬策略(如代理IP池、User-Agent轮换、验证码识别技术)和数据处理工具(如Pandas、MySQL)也是必备能力,对于涉及动态网页或复杂交互的场景,还需掌握浏览器自动化工具(如Selenium或Playwright)。

招聘爬虫兼职的优势与挑战

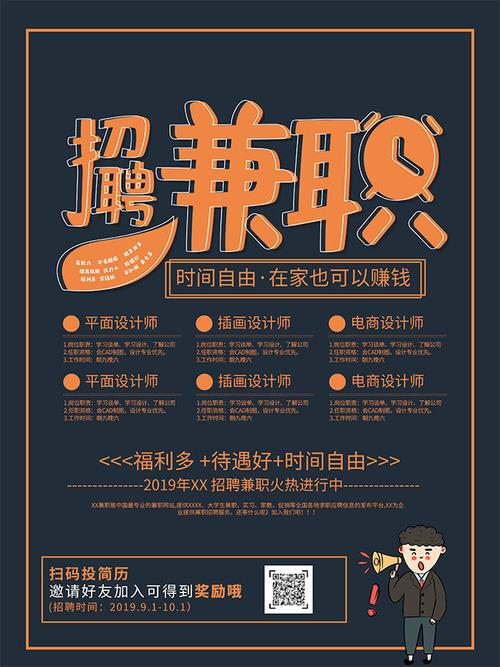

对于求职者而言,招聘爬虫兼职的优势在于时间灵活,可利用业余时间开展,适合学生、自由职业者或希望增加副业收入的全职工作者;技能门槛相对明确,具备编程基础的人群可快速上手;且市场需求稳定,随着企业对数据依赖度提升,兼职机会持续增多,这类工作能积累实际项目经验,提升数据处理和网络爬虫技术能力,为职业发展加分。

但挑战也不容忽视:一是法律与合规风险,部分网站明确禁止爬虫抓取,需严格遵守《网络安全法》及网站robots协议,避免侵犯数据隐私或违反平台规则;二是技术难度差异大,部分网站反爬机制严格,需不断优化算法甚至破解加密逻辑,对技术能力要求较高;三是收入稳定性受项目周期影响,短期项目较多,长期合作需依赖需求方的信任和持续需求。

如何高效开展招聘爬虫兼职

想要顺利承接此类兼职,需从以下几方面做好准备:明确自身技能定位,熟悉常用爬虫工具和框架,可通过GitHub开源项目或个人博客展示技术能力;关注兼职渠道,如程序员社区(如CSDN、掘金)、兼职平台(如猪八戒、程序员客栈)或企业直招信息,主动投递简历时需突出相关项目经验;注重沟通细节,与需求方明确抓取目标、数据字段、更新频率及交付时间,避免因需求理解偏差导致返工;建立合规意识,优先选择允许公开抓取的数据源,必要时与需求方签订协议,明确数据使用范围和责任划分。

以下为招聘爬虫兼职常见工具对比:

| 工具/框架 | 适用场景 | 优势 | 局限性 |

|---|---|---|---|

| Scrapy | 大规模数据抓取、分布式爬虫 | 高效异步、支持中间件和 pipelines | 学习曲线较陡,不适合简单静态页面 |

| BeautifulSoup | 简单静态页面解析 | 轻量级、易上手,语法简洁 | 不支持动态加载,需配合其他工具使用 |

| Selenium | 动态网页、JavaScript渲染页面 | 模拟浏览器操作,可处理复杂交互 | 速度较慢,资源消耗大 |

| Puppeteer | 无头浏览器爬虫、页面自动化测试 | 支持现代Web标准,调试方便 | 仅适用于Node.js,对环境配置要求较高 |

相关问答FAQs

Q1:招聘爬虫兼职是否合法?需要注意哪些法律风险?

A1:合法性取决于数据来源和抓取行为,若目标网站明确禁止爬虫(robots协议中禁止)或抓取的数据涉及个人隐私(如简历中的联系方式、身份证号等),则可能构成侵权或违法,合法操作需满足:仅抓取公开可访问的信息,不破坏网站正常运营(如避免高频请求导致服务器压力),且数据用途不违反法律法规,建议在爬虫中加入请求间隔、遵守robots协议,并与需求方确认数据使用范围,必要时签署书面协议规避风险。

Q2:没有爬虫项目经验,如何找到第一份招聘爬虫兼职?

A2:可通过以下方式积累经验并获取机会:从个人项目入手,选择公开的招聘网站(如智联招聘、前程无忧的公开职位信息)练习爬虫开发,将代码和结果上传至GitHub或个人博客,作为作品集展示;参与开源爬虫项目(如GitHub上的“招聘数据爬虫”项目),贡献代码或优化方案,提升实战能力;从小额兼职或短期任务切入,如在兼职平台承接简单的数据抓取需求,逐步建立口碑和客户信任,再逐步承接更复杂的项目。