Hadoop fs test 命令是 Hadoop 分布式文件系统(HDFS)中用于测试文件或目录状态的重要工具,它能够帮助用户快速验证文件的存在性、可读性、可写性等属性,从而简化文件系统操作中的状态检查流程,该命令属于 hadoop fs 命令集的一部分,通过不同的选项组合实现多样化的测试功能,常用于脚本自动化、数据校验及故障排查场景。

命令基本语法与核心功能

hadoop fs test 命令的基本语法结构为:

hadoop fs test -[选项] <路径>

其核心功能依赖于 -e、-z、-d、-f 等选项,具体如下:

| 选项 | 功能描述 | 返回值说明 |

|---|---|---|

-e |

测试路径是否存在 | 路径存在时返回 0,否则返回 1 |

-z |

测试路径是否为空文件 | 空文件返回 0,非空或不存在返回 1 |

-d |

测试路径是否为目录 | 是目录返回 0,否则返回 1 |

-f |

测试路径是否为文件 | 是文件返回 0,否则返回 1 |

hadoop fs test -e /user/data/test.txt 会检查 /user/data/test.txt 是否存在,若存在则命令执行成功(退出码为 0),否则失败(退出码为 1),这种基于退出码的机制使其易于在 Shell 脚本中通过 if 条件判断结果。

典型应用场景

-

文件存在性检查

在数据处理任务中,常需依赖前置文件是否存在,在执行数据导入前检查源文件是否存在:if hadoop fs test -e /input/source.csv; then hadoop fs -put local.csv /input/source.csv else echo "源文件不存在,任务终止" fi

通过

-e选项可避免因文件缺失导致的任务失败。 (图片来源网络,侵删)

(图片来源网络,侵删) -

空文件过滤

使用-z选项可跳过空文件处理,提升效率,在批量处理文件时过滤空文件:for file in $(hadoop fs -ls /input | awk '{print $8}'); do if hadoop fs test -z $file; then echo "跳过空文件: $file" else hadoop fs -cat $file | process_data fi done -

目录与文件区分

在动态路径处理中,需明确路径类型,若路径是目录则递归处理,否则直接操作:if hadoop fs test -d /path/to/dir; then hadoop fs -ls -R /path/to/dir | process_entries elif hadoop fs test -f /path/to/dir; then hadoop fs -cat /path/to/dir | process_single_file fi

注意事项与限制

-

权限依赖

hadoop fs test命令的执行权限取决于当前用户对目标路径的访问权限,若用户无读权限,即使路径存在,命令也可能返回失败(退出码为 1),需确保执行用户具备足够的权限或通过sudo提权。 -

符号链接处理

HDFS 中符号链接的支持有限,test命令不会自动解析符号链接,若路径为符号链接,需通过hadoop fs -test -L(需 Hadoop 2.8+ 版本支持)单独检查,或使用hadoop fs -stat获取实际路径。 -

性能考量

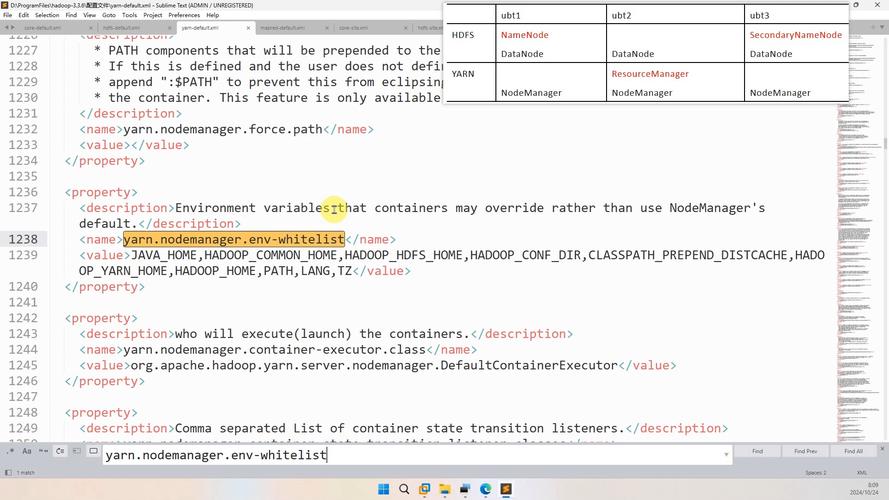

对大量文件进行批量测试时,频繁调用test命令可能增加 NameNode 负载,建议结合hadoop fs -ls一次性获取文件列表后,在本地进行状态判断,减少 RPC 调用。

相关问答FAQs

Q1: hadoop fs test 与 hadoop fs -test 有何区别?

A: 两者功能完全相同,仅是命令格式的两种写法。hadoop fs test 是早期版本的简化形式,而 hadoop fs -test 是更规范的语法,推荐使用后者以保持命令一致性。hadoop fs -test -e /path 和 hadoop fs test -e /path 效果等价。

Q2: 如何在 Python 脚本中调用 hadoop fs test 并获取退出码?

A: 可通过 subprocess 模块执行命令并捕获返回状态码,示例代码如下:

import subprocess

def check_hdfs_path(path, option):

cmd = ["hadoop", "fs", "-test", option, path]

result = subprocess.run(cmd, stderr=subprocess.PIPE)

return result.returncode == 0

# 检查文件是否存在

if check_hdfs_path("/user/data/test.txt", "-e"):

print("文件存在")

else:

print("文件不存在")

通过 result.returncode 可获取命令的退出码,便于逻辑判断。