数据库导入文件命令是数据库管理中常用的操作,主要用于将外部数据文件(如CSV、SQL脚本、Excel等)导入到数据库表中,实现数据的快速迁移或初始化,不同数据库系统(如MySQL、PostgreSQL、Oracle、SQL Server等)提供的导入命令和工具有所不同,但核心功能相似,以下将详细介绍常见数据库的导入命令及其使用方法、注意事项,并通过表格对比不同数据库的导入工具。

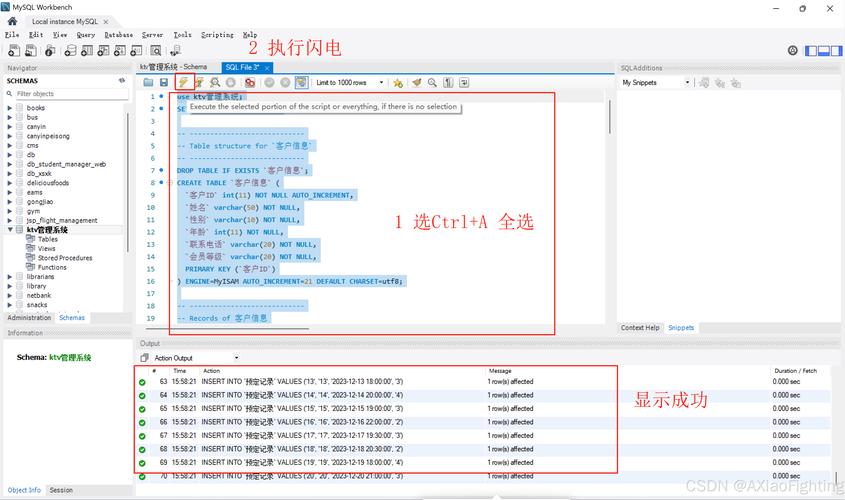

在MySQL中,导入数据主要使用mysqlimport命令行工具和LOAD DATA INFILE SQL语句。mysqlimport是客户端工具,直接操作文件,例如mysqlimport -u username -p database_name /path/to/file.csv,其中file.csv的文件名需与目标表名一致(不含扩展名),而LOAD DATA INFILE更灵活,支持指定文件路径、字段分隔符等,例如LOAD DATA INFILE '/path/to/file.csv' INTO TABLE table_name FIELDS TERMINATED BY ',' LINES TERMINATED BY '\n',使用时需确保数据库用户有FILE权限,且文件路径需在数据库服务器可访问的位置(或使用LOCAL关键字从客户端读取)。

PostgreSQL的导入工具主要有COPY命令和pgAdmin的导入功能。COPY是SQL命令,需在数据库中执行,例如COPY table_name FROM '/path/to/file.csv' WITH (FORMAT CSV, HEADER),支持CSV格式,HEADER表示第一行是列名,若从客户端导入,可使用\copy命令(以开头),例如\copy table_name FROM '/path/to/file.csv' WITH CSV HEADER,此命令会通过客户端读取文件,无需服务器文件权限。

Oracle数据库的导入通常使用SQL*Loader工具,通过控制文件(.ctl)定义数据格式,例如sqlldr username/password@db control=control_file.ctl,控制文件需指定数据文件路径、表名、字段映射等,例如LOAD DATA INFILE 'data.csv' INTO TABLE table_name FIELDS TERMINATED BY ',' (column1, column2),Oracle Data Pump(impdp)用于导入导出 dump 文件,适合大数据量迁移,例如impdp username/password DIRECTORY=dp_dir DUMPFILE=exp.dmp。

SQL Server的导入工具包括bcp命令和BULK INSERT SQL语句。bcp是命令行工具,例如bcp database_name..table_name in data.csv -c -t, -S server_name -U username -P password,-c表示字符数据,-t指定分隔符。BULK INSERT在SQL Server Management Studio (SSMS) 中执行,例如BULK INSERT table_name FROM 'data.csv' WITH (FIELDTERMINATOR=',', FIRSTROW=2),FIRSTROW=2表示从第二行开始导入(跳过标题行)。

不同数据库导入工具对比:

| 数据库系统 | 导入工具/命令 | 适用场景 | 关键参数/选项 |

|---|---|---|---|

| MySQL | mysqlimport | 简单CSV文件导入 | -u(用户), -p(密码), --local(客户端文件) |

| MySQL | LOAD DATA INFILE | 灵活格式导入,支持复杂映射 | FIELDS TERMINATED BY, LINES TERMINATED BY |

| PostgreSQL | COPY | 服务器端文件导入,高性能 | FORMAT CSV, HEADER, DELIMITER |

| PostgreSQL | \copy | 客户端文件导入,无需服务器权限 | CSV, HEADER, DELIMITER |

| Oracle | SQL*Loader | 固定格式文件导入,大数据量 | INFILE, FIELDS TERMINATED BY, BADFILE |

| Oracle | Data Pump (impdp) | dump文件导入,跨数据库迁移 | DIRECTORY, DUMPFILE, REMAP_DATA |

| SQL Server | bcp | 命令行批量导入,适合脚本自动化 | -c(字符), -t(分隔符), -F(首行) |

| SQL Server | BULK INSERT | T-SQL脚本内导入,事务支持 | FIELDTERMINATOR, ROWTERMINATOR, FIRSTROW |

使用导入命令时需注意以下几点:1. 文件格式与表结构匹配,包括字段顺序、数据类型、分隔符等;2. 确保数据库用户有足够权限(如INSERT、FILE等);3. 大文件导入前可测试小样本数据,避免格式错误导致导入失败;4. 考虑使用事务(如SQL Server的BULK INSERT)或分批导入,避免锁表时间过长;5. 特殊字符(如换行符、引号)需正确处理,避免数据截断或解析错误。

相关问答FAQs:

Q1: 导入CSV文件时,如何处理包含换行符或逗号的字段?

A: 不同数据库有不同解决方案,MySQL的LOAD DATA INFILE可通过ENCLOSED BY '"'将字段用引号包裹,例如LOAD DATA INFILE 'file.csv' INTO TABLE table_name FIELDS TERMINATED BY ',' ENCLOSED BY '"' LINES TERMINATED BY '\n',PostgreSQL的COPY命令默认支持CSV格式中的引号包裹字段,无需额外参数,SQL Server的BULK INSERT可通过ROWTERMINATOR指定行结束符,并用FIELDQUOTE定义引号字符,例如WITH (FIELDTERMINATOR=',', FIELDQUOTE='"', ROWTERMINATOR='\n'),确保CSV文件本身符合规范(如字段用引号包裹含特殊字符的内容)是关键。

Q2: 导入失败后如何定位错误原因?

A: 首先检查数据库错误日志,通常会记录导入失败的详细原因(如数据类型不匹配、字段数量不符、权限不足等),MySQL可通过SHOW WARNINGS;查看警告信息;PostgreSQL的COPY命令失败时会返回错误行号;Oracle的SQL*Loader会生成bad文件(记录失败行)和log文件(记录执行过程);SQL Server的BULK INSERT可通过ERRORFILE参数指定错误输出文件,例如BULK INSERT table_name FROM 'file.csv' WITH (ERRORFILE='error.log'),使用文本编辑器检查数据文件是否有异常行(如多余的分隔符、空行等),并确保目标表结构与数据文件结构一致。