HDFS(Hadoop Distributed File System)是Hadoop生态系统的核心组件之一,它为海量数据提供了高容错性、高吞吐量的分布式存储解决方案,而hdfs dfs命令则是与HDFS进行交互的主要工具,类似于Linux文件系统中的bash命令,用户可以通过它执行文件和目录的创建、删除、查看、移动、复制等多种操作。hdfs dfs命令的底层依赖于Hadoop的Java API,通过RPC(远程过程调用)与HDFS的NameNode和DataNode进行通信,实现对分布式文件的管理。

要使用hdfs dfs命令,首先需要确保Hadoop集群已经正确启动,并且Hadoop的环境变量(如HADOOP_HOME和PATH)已正确配置。hdfs dfs命令的基本语法格式为hdfs dfs [选项] <操作> <参数>,其中常见的选项包括-ls(列出目录内容)、-mkdir(创建目录)、-put(上传本地文件到HDFS)、-get(从HDFS下载文件到本地)、-rm(删除文件或目录)、-mv(移动或重命名文件)、-cp(复制文件)等,这些命令支持通配符操作,例如hdfs dfs -ls /user/*可以列出/user目录下的所有一级子目录。

文件和目录管理是hdfs dfs命令最基础的功能,使用hdfs dfs -mkdir /data可以在HDFS的根目录下创建一个名为data的目录;如果需要创建多级目录,可以使用-p选项,如hdfs dfs -mkdir -p /data/input/2023,该命令会自动创建不存在的父目录,列出目录内容时,hdfs dfs -ls /data会显示/data目录下所有文件和子目录的详细信息,包括权限、所有者、大小、修改时间等,这与Linux的ls -l命令类似,若需递归列出子目录内容,可使用-R选项,即hdfs dfs -ls -R /data,删除操作中,hdfs dfs -rm /data/test.txt会删除指定文件,而hdfs dfs -rm -r /data则会递归删除/data目录及其所有内容,需谨慎使用,移动和重命名文件可以通过hdfs dfs -mv /data/test.txt /data/new.txt实现,该命令会将test.txt重命名为new.txt,或将其移动到其他目录,复制操作则使用hdfs dfs -cp /data/test.txt /backup/,将文件从源路径复制到目标路径。

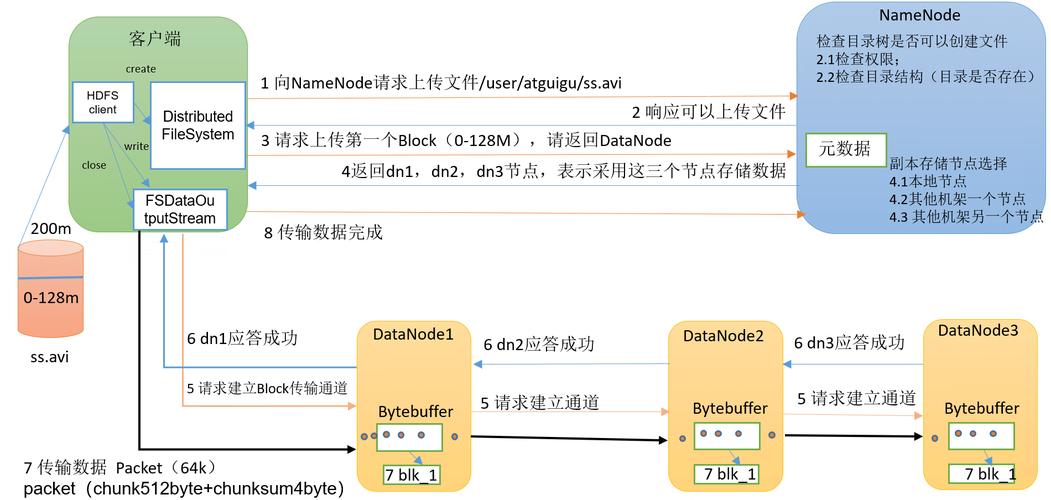

文件的上传与下载是hdfs dfs命令的另一个核心功能。hdfs dfs -put localfile.txt /data/会将本地文件系统中的localfile.txt上传到HDFS的/data目录下;如果上传的是目录,需加上-r选项,如hdfs dfs -put -r localdir /data/,与put命令类似的还有copyFromLocal,两者的功能基本一致,但copyFromLocal明确表示从本地复制,语义更清晰,下载文件时,hdfs dfs -get /data/test.txt ./会将HDFS中的test.txt下载到当前本地目录,并保留原文件名;若需下载到指定路径,可修改目标参数,如hdfs dfs -get /data/test.txt /tmp/localfile.txt,同样,get命令也有对应的copyToLocal,功能相同。hdfs dfs -cat /data/test.txt可以直接查看HDFS文件的内容,类似于Linux的cat命令,适用于小文件的查看;对于大文件,可以使用hdfs dfs -tail /data/largefile.txt查看文件末尾的内容,默认显示最后1024字节。

HDFS还提供了一些高级文件操作命令,以满足复杂场景的需求。hdfs dfs -du /data用于显示目录或文件所占用的空间大小,单位为字节,若需更易读的格式(如KB、MB),可使用-h选项,即hdfs dfs -du -h /data。hdfs dfs -count /data则会统计指定目录下的文件数量、目录数量以及总占用空间,类似于Linux的du -s和wc -l的组合,文件权限管理方面,HDFS支持Linux风格的权限控制,hdfs dfs -chmod 755 /data/test.txt可将文件权限设置为所有者可读写执行、组用户和其他用户可读执行;hdfs dfs -chown user:group /data/test.txt可修改文件的所有者和所属组。hdfs dfs -touchz /data/emptyfile.txt可以创建一个空文件,hdfs dfs -test -e /data/test.txt用于测试文件或目录是否存在,返回值为0表示存在,1表示不存在。

在实际使用中,hdfs dfs命令还支持一些实用选项来优化操作。-f选项可以强制执行某些操作,如hdfs dfs -put -f localfile.txt /data/test.txt,即使目标文件已存在也会覆盖;-D选项用于设置HDFS的属性,如hdfs dfs -D dfs.blocksize=128m -put largefile.txt /data/,可将上传文件的块大小设置为128MB;-skip-checksum选项在上传或下载时跳过校验和检查,适用于对数据完整性要求不高的场景。hdfs dfs -expunge命令会清空HDFS的垃圾回收站(Trash),删除的文件默认会被移动到.Trash/目录,通过expunge命令可彻底清理。

为了更直观地展示常用hdfs dfs命令的功能,以下是一个简单的命令对照表:

| 命令功能 | 示例命令 | 说明 |

|---|---|---|

| 列出目录内容 | hdfs dfs -ls /data |

显示/data目录下的文件和子目录信息 |

| 创建目录 | hdfs dfs -mkdir -p /data/input/2023 |

递归创建多级目录 |

| 上传文件 | hdfs dfs -put localfile.txt /data/ |

将本地文件上传到HDFS |

| 下载文件 | hdfs dfs -get /data/test.txt ./ |

将HDFS文件下载到本地当前目录 |

| 删除文件 | hdfs dfs -rm -r /data |

递归删除/data目录及其所有内容 |

| 移动/重命名文件 | hdfs dfs -mv /data/test.txt /backup/ |

将文件移动到/backup目录或重命名 |

| 复制文件 | hdfs dfs -cp /data/test.txt /backup/ |

将文件从源路径复制到目标路径 |

| 查看文件内容 | hdfs dfs -cat /data/test.txt |

显示文件内容,适用于小文件 |

| 统计目录大小 | hdfs dfs -du -h /data |

以易读格式显示目录或文件占用的空间 |

| 修改权限 | hdfs dfs -chmod 644 /data/test.txt |

设置文件权限为所有者读写,组用户和其他用户只读 |

| 创建空文件 | hdfs dfs -touchz /data/emptyfile.txt |

在HDFS中创建一个空文件 |

| 测试文件是否存在 | hdfs dfs -test -e /data/test.txt |

检查文件或目录是否存在,返回0或1 |

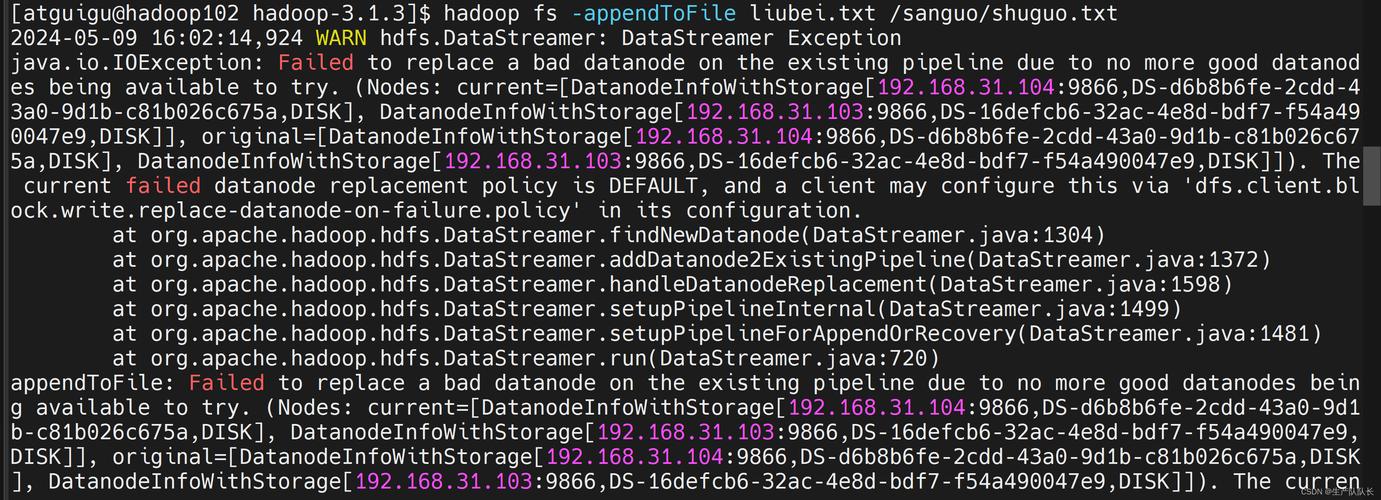

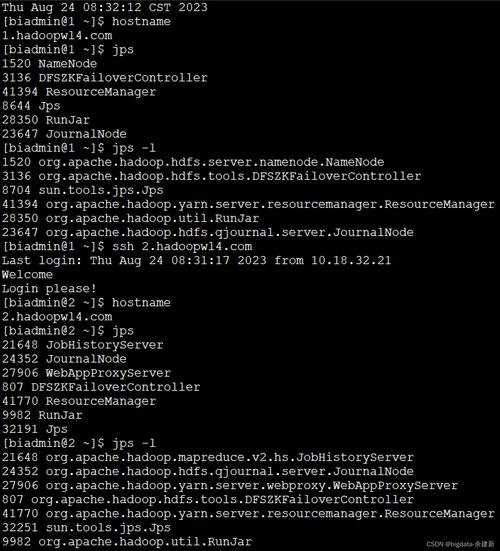

需要注意的是,hdfs dfs命令的执行依赖于Hadoop集群的运行状态,如果NameNode或DataNode进程未启动,命令可能会报错,对于大规模数据操作,建议在非高峰期执行,以避免对集群性能造成影响,由于HDFS是分布式文件系统,文件操作可能涉及网络传输,因此对于大文件,建议使用-D选项调整块大小,以提高读写效率。

相关问答FAQs

Q1: 为什么执行hdfs dfs -ls命令时提示“Permission denied”?

A1: 该错误通常是由于当前用户对目标目录或文件没有读取权限导致的,HDFS的权限模型类似于Linux,包括读(r)、写(w)、执行(x)权限,可以通过hdfs dfs -chmod命令修改权限,例如hdfs dfs -chmod 755 /data将/data目录权限设置为所有者可读写执行,其他用户可读执行;或者使用hdfs dfs -chown命令修改文件所有者,例如hdfs dfs -chown hadoop:hadoop /data将/data的所有者设置为hadoop用户(假设当前用户为管理员),还需确认HDFS集群是否启用了权限检查(默认启用),可通过core-site.xml中的dfs.permissions配置项调整。

Q2: 如何将HDFS中的大文件分割成多个小文件下载到本地?

A2: HDFS本身不直接提供文件分割下载功能,但可以通过以下方法实现:

- 使用

hdfs dfs -get结合split命令:先通过hdfs dfs -get将大文件下载到本地,然后使用Linux的split命令分割文件,例如split -l 10000 largefile.txt smallfile_,将largefile.txt按每行10000行分割为多个smallfile_aa、smallfile_ab等文件。 - 使用Hadoop的

DistCp工具:如果需要将文件分割后存储到其他HDFS集群或目录,可以使用hadoop distcp命令,结合-skipcrccheck和overwrite选项实现部分复制。 - 自定义程序:通过Hadoop Java API编写程序,读取HDFS文件时按指定大小(如100MB)分割并写入本地文件,这种方法灵活性最高,适合复杂场景。