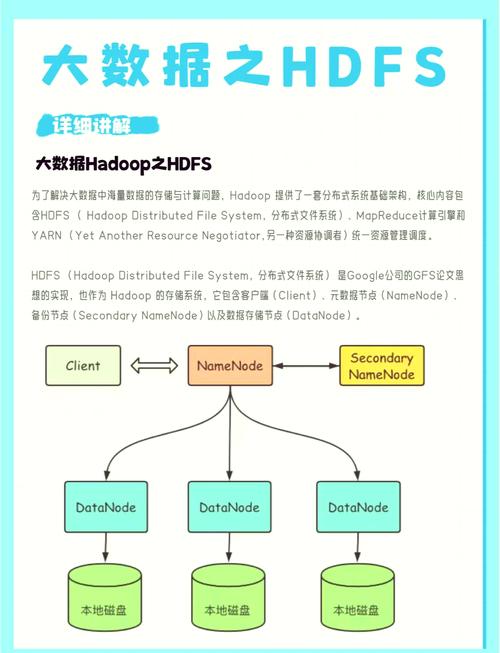

HDFS(Hadoop Distributed File System)作为Hadoop生态系统的核心组件,提供了分布式存储能力,其命令行接口(CLI)是用户与HDFS交互的重要方式,通过HDFS命令行,用户可以完成文件的上传、下载、删除、查看目录结构、修改文件权限等操作,这些命令基于Shell实现,格式通常为hadoop fs <command>或hdfs dfs <command>,两者功能基本一致,以下将详细介绍HDFS命令行的常用操作、参数及使用场景。

基本文件操作

HDFS命令行的核心功能围绕文件和目录管理展开,首先是目录操作,mkdir命令用于创建目录,支持多级目录创建,例如hadoop fs -mkdir /user/data会在根目录下创建user/data路径;ls命令用于列出目录内容,-R参数可递归显示子目录,如hadoop fs -ls -R /user会展示/user及其所有子目录的文件和文件夹,删除操作通过rm实现,-r或-R参数用于递归删除目录,需谨慎使用,例如hadoop fs -rm -r /user/temp会彻底删除temp目录及其内容。

文件上传与下载是高频操作,上传本地文件到HDFS使用put命令,如hadoop fs -put local.txt /user/data/remote.txt,若目标文件已存在,可通过-f参数强制覆盖;下载HDFS文件到本地则用get命令,hadoop fs -get /user/data/remote.txt ./local.txt会将HDFS上的文件保存到当前本地目录。copyFromLocal和copyToLocal分别是put和get的别名,功能完全相同,但语义更明确。

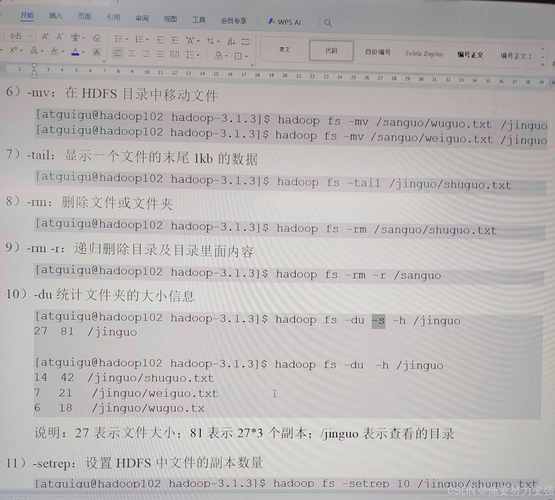

文件查看与权限管理时,cat命令可直接输出文本文件内容,例如hadoop fs -cat /user/data/log.txt;对于大文件,head和tail命令更实用,-n参数可指定显示行数,如hadoop fs -head -n 100 /user/data/bigfile.log显示文件前100行,tail -f还可实时追踪文件更新(需HDFS支持追加写)。text命令可将二进制文件(如SequenceFile)转换为文本格式输出,方便调试。

权限管理遵循Linux风格的rwx(读、写、执行)权限,chmod命令修改权限,如hadoop fs -chmod 755 /user/script.sh将文件权限设为所有者可读写执行、其他用户可读执行;chown和chgrp分别修改文件所有者和所属组,例如hadoop fs -chown hadoop:hadoop /user/data将文件所有者设为hadoop用户,所属组设为hadoop组,所有者信息需提前在HDFS集群中配置,否则可能报错。

高级操作与维护

HDFS支持文件移动和重命名,mv命令可在HDFS内部移动文件或目录,如hadoop fs -mv /user/data/old.txt /user/data/new.txt实现重命名;cp命令用于复制文件,-p参数可保留文件权限和时间戳,例如hadoop fs -cp -p /user/data/source.txt /user/backup/,统计文件大小使用du命令,-h参数以人类可读格式显示(如KB、MB),-s仅汇总总大小,如hadoop fs -du -sh /user/data显示该目录总大小。

对于归档需求,tar和zip命令可将多个文件打包为单个HDFS文件,例如hadoop fs -tar -cvf /user/archive.tar /user/data/*;解压则需结合-x参数。distcp(分布式复制)命令用于跨集群或跨目录的大规模数据迁移,语法为hadoop distcp hdfs://source-cluster/path hdfs://dest-cluster/path,支持并行复制,效率较高。

命令参数与错误处理

多数HDFS命令支持通用参数,如-f(强制操作)、-skipcrccheck(跳过校验和检查,适用于大文件快速传输)、-D(设置属性,如-Ddfs.blocksize=128m修改块大小),命令执行失败时,常见错误包括“Permission denied”(权限不足)、“No such file or directory”(路径错误)、“Connection refused”(NameNode节点未启动),需结合集群日志排查,若上传文件时提示“Disk quota exceeded”,可能是用户配额不足,需通过hdfs dfsadmin -setQuota调整配额。

操作效率优化

针对大文件操作,建议启用压缩(如-Dmapreduce.map.output.compress=true)减少网络传输;批量操作时,可编写Shell脚本循环执行命令,或使用hadoop fs -test判断文件是否存在(如-e测试存在性、-z测试是否为空文件),避免重复执行,对于频繁访问的文件,可通过hadoop fs -setrep调整副本数,如hadoop fs -setrep 3 /user/data/hotfile将热门文件副本数设为3,提高读取性能。

相关问答FAQs

Q1: HDFS命令行中put和copyFromLocal有什么区别?

A1: 两者功能完全相同,copyFromLocal是put的别名,语义更明确,强调从本地文件系统复制到HDFS,实际使用中可根据习惯选择,例如hadoop fs -copyFromLocal local.txt /remote.txt比put更易理解,但底层实现无差异。

Q2: 如何解决HDFS命令执行时“NameNode is not running”的错误?

A2: 该错误通常因Hadoop集群未启动或NameNode进程异常导致,可按以下步骤排查:1)检查Hadoop服务状态,执行jps查看NameNode进程(默认端口8020);2)若进程不存在,启动HDFS集群:start-dfs.sh;3)检查防火墙或安全组是否拦截NameNode端口;4)查看NameNode日志(位于$HADOOP_HOME/logs定位具体错误,如元数据损坏需格式化NameNode(hdfs namenode -format),但会丢失数据,需谨慎操作。