Hadoop fs命令是Hadoop分布式文件系统(HDFS)中最常用的命令行工具之一,用于与HDFS进行交互,如文件上传、下载、目录操作、权限管理、文件查看等,这些命令类似于Linux的文件系统命令,但针对分布式环境进行了优化,以下将详细介绍Hadoop fs命令的常用操作及具体用法,涵盖基本文件操作、高级功能及实用技巧。

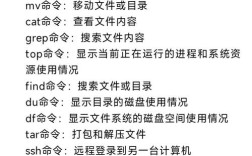

基本文件和目录操作

-

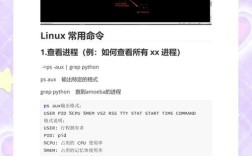

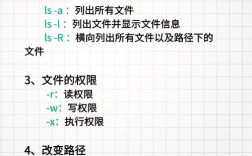

查看目录内容

使用ls命令可以列出指定目录下的文件和子目录。hadoop fs -ls /user # 查看/user目录下的内容 hadoop fs -ls -R /user # 递归查看/user及其子目录内容

-R选项表示递归显示,-h选项以人类可读格式显示文件大小(如KB、MB)。 -

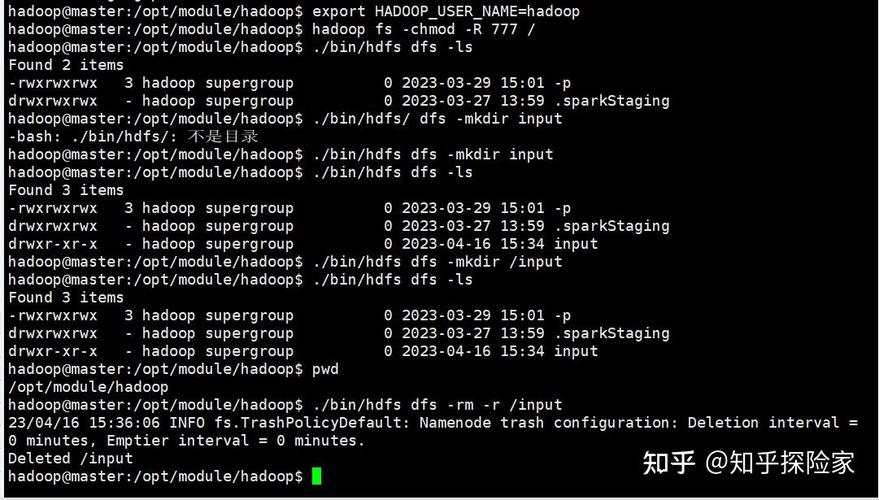

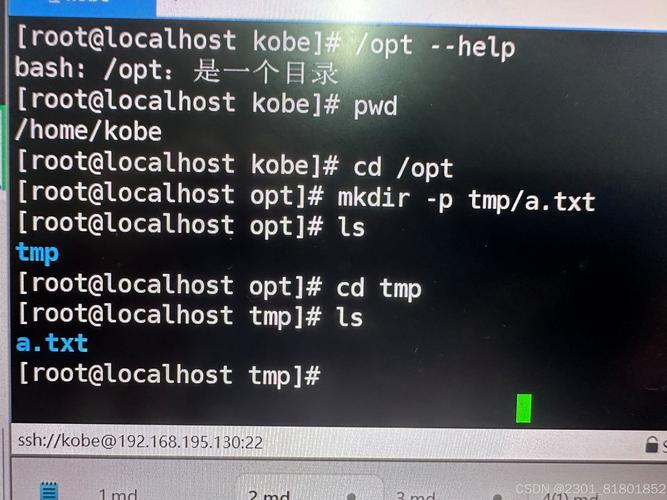

创建目录

mkdir命令用于创建目录,支持多级目录创建:hadoop fs -mkdir /data # 创建单级目录 hadoop fs -mkdir -p /data/input # 创建多级目录(-p自动创建父目录)

-

上传文件到HDFS

put或copyFromLocal命令可将本地文件上传至HDFS: (图片来源网络,侵删)

(图片来源网络,侵删)hadoop fs -put localfile.txt /data/ # 上传文件并重命名 hadoop fs -copyFromLocal localfile.txt /data/ # 功能与put类似

若需覆盖已存在文件,可使用

-f选项。 -

从HDFS下载文件

get或copyToLocal命令可将HDFS文件下载到本地:hadoop fs -get /data/file.txt ./ # 下载到当前目录 hadoop fs -copyToLocal /data/file.txt ./ # 功能与get类似

-

移动或重命名文件

mv命令用于移动文件或重命名:hadoop fs -mv /data/file1.txt /data/backup/ # 移动文件 hadoop fs -mv /data/file1.txt /data/file2.txt # 重命名文件

-

复制文件

cp命令用于复制文件或目录:hadoop fs -cp /data/file1.txt /data/backup/ # 复制文件 hadoop fs -cp -r /data/input /data/output # 复制整个目录(-r表示递归)

-

删除文件或目录

rm命令用于删除文件或目录:hadoop fs -rm /data/file.txt # 删除文件 hadoop fs -rm -r /data/input # 递归删除目录

删除后可通过

-skipTrash选项跳过回收站直接删除。 -

查看文件内容

cat、head、tail命令用于查看文件内容:hadoop fs -cat /data/file.txt # 查看整个文件 hadoop fs -head -n 100 /data/file.txt # 查看文件前100行 hadoop fs -tail -f /data/log.txt # 实时查看文件末尾内容(类似Linux的tail -f)

高级操作与实用功能

-

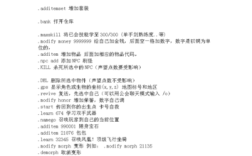

文件权限管理

HDFS支持Linux风格的权限控制,使用chmod和chown命令:hadoop fs -chmod 755 /data # 修改权限(rwxr-xr-x) hadoop fs -chown user:group /data # 修改所有者和所属组

-

文件块管理

查看文件块信息:hadoop fs -du /data # 显示目录下文件大小及总计 hadoop fs -du -h /data # 以人类可读格式显示大小 hadoop fs -count /data # 统计文件数量、目录数量和总大小

通过

-setrep命令可以设置文件副本数:hadoop fs -setrep 3 /data/file.txt # 设置副本数为3

-

文件归档与压缩

使用archive命令将小文件归档为HAR(Hadoop Archive)文件,减少NameNode内存占用:hadoop fs -archiveName input.har.har -p /data/small_files /data/input.har

-

检查文件完整性

通过checksum命令计算文件的校验和:hadoop fs -checksum /data/file.txt

-

分布式合并文件

使用getmerge命令将多个文件合并为本地单个文件:hadoop fs -getmerge /data/part-* ./merged_file.txt

常用命令速查表

| 命令 | 功能描述 | 示例 |

|---|---|---|

ls |

列出目录内容 | hadoop fs -ls /user |

mkdir |

创建目录 | hadoop fs -mkdir -p /data/input |

put/copyFromLocal |

上传本地文件到HDFS | hadoop fs -put local.txt /data/ |

get/copyToLocal |

从HDFS下载文件到本地 | hadoop fs -get /data/file.txt ./ |

mv |

移动或重命名文件 | hadoop fs -mv /data/f1.txt /f2.txt |

cp |

复制文件或目录 | hadoop fs -cp -r /src /dst |

rm |

删除文件或目录 | hadoop fs -rm -r /data/input |

cat |

查看文件内容 | hadoop fs -cat /data/file.txt |

head/tail |

查看文件开头/末尾内容 | hadoop fs -head -n 10 /data/file.txt |

du |

显示文件大小 | hadoop fs -du -h /data |

count |

统计文件数量、目录数和总大小 | hadoop fs -count /data |

chmod |

修改文件权限 | hadoop fs -chmod 644 /data/file.txt |

chown |

修改文件所有者/所属组 | hadoop fs -chown user:group /data |

setrep |

设置文件副本数 | hadoop fs -setrep 3 /data/file.txt |

getmerge |

合并HDFS文件到本地 | hadoop fs -getmerge /part-* ./merged |

实用技巧

- 使用通配符:部分命令支持通配符操作,如批量删除文件:

hadoop fs -rm /data/*.txt # 删除/data目录下所有.txt文件

- 结合管道操作:将命令通过管道连接,例如结合

grep过滤文件内容:hadoop fs -cat /data/log.txt | grep "ERROR"

- 查看命令帮助:通过

-help选项查看命令详细用法:hadoop fs -help put

相关问答FAQs

Q1: 如何批量重命名HDFS目录下的文件?

A: Hadoop fs命令本身不支持直接批量重命名,但可通过以下方法实现:

- 使用

hadoop fs -ls列出文件,结合脚本(如Python或Shell)生成重命名命令,hadoop fs -ls /data | awk '{print "hadoop fs -mv /data/"$9" /data/new_"$9}' > rename.sh bash rename.sh - 使用Hadoop的DistCp工具结合自定义逻辑实现复杂重命名操作。

Q2: 如何解决HDFS文件上传失败的问题?

A: 文件上传失败可能由多种原因导致,可按以下步骤排查:

- 检查权限:确认当前用户对目标目录有写权限,使用

hadoop fs -chmod调整权限。 - 检查磁盘空间:确保NameNode和DataNode节点有足够磁盘空间,通过

hadoop dfsadmin -report查看节点状态。 - 检查网络连通性:确认本地与Hadoop集群网络正常,可尝试ping集群节点。

- 查看日志:检查Hadoop日志(如

$HADOOP_HOME/logs定位具体错误信息,如“FileNotFound”或“Permission denied”。 - 重试或调整参数:对于临时性错误(如网络抖动),可重试上传;若文件过大,可尝试分块上传或调整

io.file.buffer.size参数。