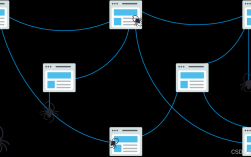

爬取招聘网招聘信息是一项常见的数据获取需求,通常用于市场分析、人才趋势研究或企业招聘策略制定,这一过程需要严格遵守法律法规和平台规则,避免侵犯数据隐私或违反网站使用条款,以下是详细的操作步骤、注意事项及技术实现方法,帮助合法合规地完成数据爬取任务。

明确爬取目标与合法性

在开始爬取前,需明确具体目标,如岗位名称、薪资范围、工作地点、公司信息等,必须确认目标招聘网站是否允许爬取,大部分网站会在其“robots.txt”文件中声明爬取规则,例如禁止爬取某些页面或限制爬取频率,需遵守《网络安全法》和《个人信息保护法》,避免爬取涉及个人隐私的信息(如联系方式、身份证号等),且不得将数据用于非法用途。

技术工具选择

爬取招聘信息通常需要以下工具:

- 编程语言:Python是最常用的选择,拥有丰富的库支持爬取任务。

- HTTP请求库:如

Requests用于发送HTTP请求,获取网页内容。 - 解析库:如

BeautifulSoup或lxml用于解析HTML结构,提取目标数据。 - 动态页面处理工具:如

Selenium或Playwright,用于处理JavaScript渲染的页面(如某些招聘网站的动态加载内容)。 - 数据存储库:如

Pandas用于数据整理,MySQL或MongoDB用于数据存储。

爬取步骤详解

分析目标网页结构

以某招聘网站为例,首先通过浏览器开发者工具(F12)分析目标页面的HTML结构,岗位信息可能存储在<div class="job-item">标签下,岗位名称在<h3 class="job-title">中,薪资在<span class="salary">中,通过分析定位到关键节点,为后续解析提供依据。

发送HTTP请求

使用Requests库模拟浏览器访问目标页面,需注意处理反爬机制,例如设置请求头(User-Agent、Referer等)避免被识别为爬虫。

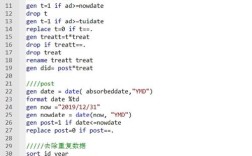

import requests

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

url = 'https://www.example.com/jobs?page=1'

response = requests.get(url, headers=headers)

解析网页内容

若页面为静态HTML,可直接用BeautifulSoup解析:

from bs4 import BeautifulSoup

soup = BeautifulSoup(response.text, 'html.parser')

job_items = soup.find_all('div', class_='job-item')

若页面为动态加载(如通过JavaScript渲染),需使用Selenium模拟浏览器操作:

from selenium import webdriver

driver = webdriver.Chrome()

driver.get(url)

job_items = driver.find_elements_by_class_name('job-item')

提取关键数据

遍历解析后的节点,提取所需信息。

data = []

for item in job_items:= item.find('h3', class_='job-title').text.strip()

salary = item.find('span', class_='salary').text.strip()

company = item.find('div', class_='company-name').text.strip()

data.append({'岗位名称': title, '薪资': salary, '公司': company})

数据存储与清洗

将提取的数据存储为结构化格式(如CSV、Excel或数据库),使用Pandas可快速整理数据:

import pandas as pd

df = pd.DataFrame(data)

df.to_csv('jobs.csv', index=False, encoding='utf-8-sig')

数据清洗步骤包括去除重复值、处理缺失值、统一格式(如薪资范围标准化)等。

处理反爬机制

招聘网站通常有反爬措施,需采取以下策略:

- IP代理池:使用代理IP避免单一IP被封禁。

- 请求频率控制:设置随机延时(如

time.sleep(random.uniform(1, 3)))模拟人类操作。 - 验证码处理:可通过第三方平台(如打码兔)识别验证码,或使用

Selenium手动处理。

注意事项

- 法律风险:未经授权爬取数据可能涉及侵权,需提前与网站沟通或仅爬取公开允许的数据。

- 数据安全:存储的数据需加密处理,避免泄露敏感信息。

- 道德规范:爬取数据后不得用于恶意竞争或骚扰求职者。

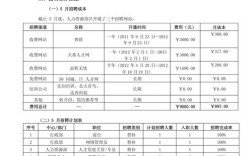

示例数据表格

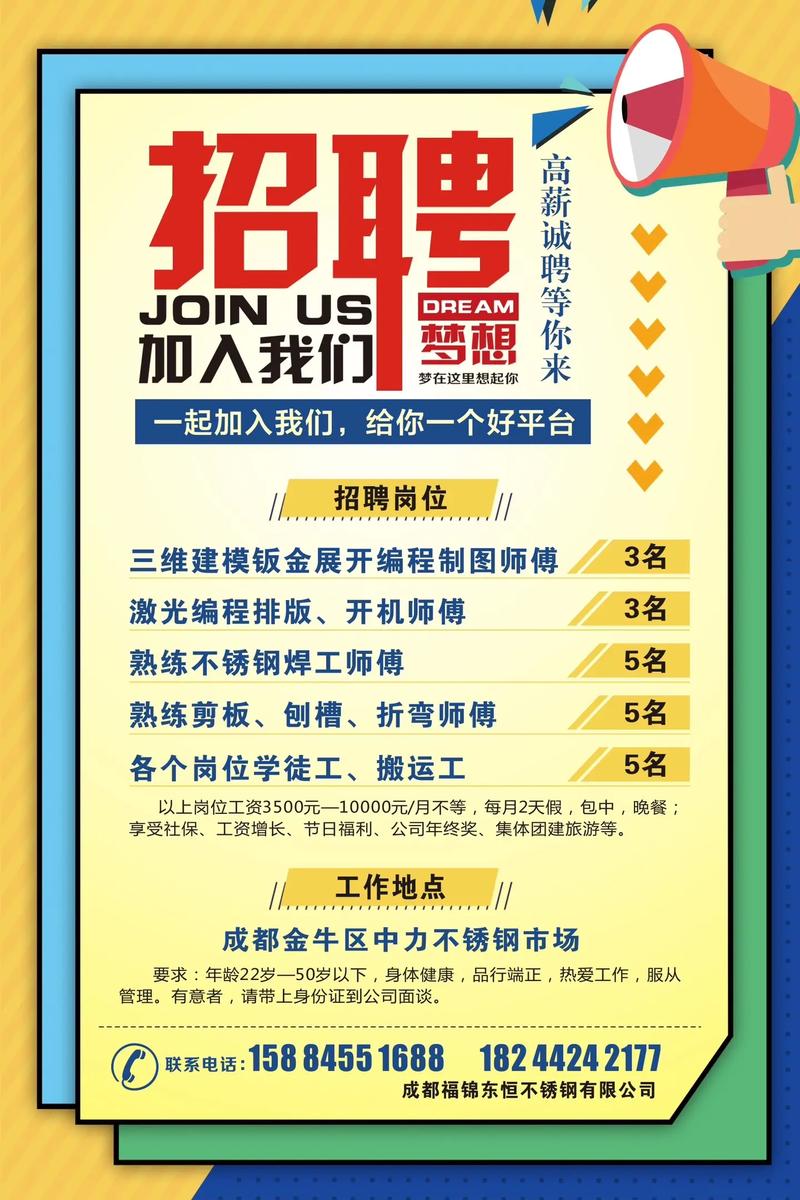

以下为爬取的招聘信息示例(部分字段):

| 岗位名称 | 薪资范围 | 工作地点 | 公司名称 | 学历要求 |

|---|---|---|---|---|

| Python开发工程师 | 15k-25k | 北京 | 某科技有限公司 | 本科 |

| 数据分析师 | 12k-20k | 上海 | 某互联网公司 | 硕士 |

| 产品经理 | 18k-30k | 深圳 | 某金融科技企业 | 本科 |

相关问答FAQs

Q1: 爬取招聘信息时遇到验证码怎么办?

A1: 验证码是网站反爬的常见手段,可通过以下方式解决:1)使用Selenium模拟人工手动输入验证码;2)集成第三方打码平台(如超级鹰、云打码)自动识别;3)降低爬取频率,减少触发验证码的概率,需注意,破解复杂验证码可能涉及法律风险,建议优先选择合规方式。

Q2: 如何避免爬取到的数据存在重复或缺失?

A2: 数据重复可通过去重机制解决,如使用Pandas的drop_duplicates()方法或数据库唯一索引,缺失数据可采取以下处理:1)删除缺失行(df.dropna());2)填充默认值(如“薪资面议”);3)通过多源数据补充,在爬取阶段可增加校验逻辑,如检查字段是否为空,确保数据质量。