Python爬取招聘信息是数据分析和求职领域常见的应用场景,通过编写爬虫程序可以自动化获取各大招聘平台(如智联招聘、前程无忧、BOSS直聘等)的岗位数据,为求职者提供岗位筛选、薪资分析、技能需求统计等支持,以下将从技术原理、实现步骤、注意事项及代码示例等方面详细介绍Python爬取招聘信息的方法。

爬虫技术原理

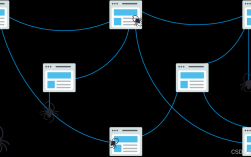

爬虫的核心是模拟浏览器向目标网站发送HTTP请求,获取服务器返回的HTML页面,然后通过解析工具提取所需数据,Python凭借丰富的库生态(如Requests、BeautifulSoup、Scrapy、Selenium等)成为爬虫开发的首选语言,Requests用于发送HTTP请求,BeautifulSoup和lxml用于解析HTML,Scrapy是功能强大的爬虫框架,Selenium则用于处理JavaScript动态加载的页面。

实现步骤

确定目标网站和数据需求

首先明确要爬取的招聘平台(如BOSS直聘)和所需字段(如岗位名称、公司名称、薪资、工作地点、学历要求、技能标签等),不同网站的数据加载方式和反爬机制不同,需针对性设计爬虫策略。

分析网页结构

使用浏览器开发者工具(F12)分析目标页面的HTML结构,定位数据所在的标签和属性,BOSS直聘的岗位信息通常位于<div class="job-primary">标签下,岗位名称在<span class="job-name">中,薪资在<span class="red">中。

发送HTTP请求

使用Requests库发送GET或POST请求,携带必要的请求头(如User-Agent、Referer)模拟浏览器访问,部分网站需要登录才能获取数据,可通过Session对象保持登录状态,或携带Cookie信息。

解析HTML页面

通过BeautifulSoup解析HTML,根据标签和属性提取数据。

from bs4 import BeautifulSoup

soup = BeautifulSoup(html_content, 'html.parser')

job_list = soup.find_all('div', class_='job-primary')

for job in job_list:

job_name = job.find('span', class_='job-name').text.strip()

salary = job.find('span', class_='red').text.strip()

company = job.find('div', class='company-text').find('h3').text.strip()

数据存储与清洗

将提取的数据存储为结构化格式(如CSV、Excel或数据库),使用Pandas库进行数据清洗,处理缺失值、统一格式(如薪资范围拆分为最低值和最高值)、标准化文本(如地点去重)。

处理动态加载与反爬

若网站通过JavaScript动态加载数据(如滚动加载更多岗位),需使用Selenium模拟浏览器操作,或分析接口请求直接调用API,反爬措施包括:设置请求间隔(time.sleep)、使用代理IP池、更换User-Agent、处理验证码等。

代码示例(以BOSS直聘为例)

import requests

from bs4 import BeautifulSoup

import pandas as pd

import time

url = 'https://www.zhipin.com/web/geek/job?query=python&city=101010100' # 北京的Python岗位

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.text, 'html.parser')

job_list = soup.find_all('div', class_='job-primary')

data = []

for job in job_list:

job_name = job.find('span', class_='job-name').text.strip()

salary = job.find('span', class_='red').text.strip()

company = job.find('div', class_='company-text').find('h3').text.strip()

location = job.find('ul', class_='job-area-wrapper').find('span').text.strip()

data.append([job_name, salary, company, location])

df = pd.DataFrame(data, columns=['岗位名称', '薪资', '公司名称', '工作地点'])

df.to_csv('jobs.csv', index=False, encoding='utf-8-sig')

注意事项

- 法律与道德规范:爬取数据需遵守网站robots协议,避免频繁请求导致服务器压力过大,尊重版权和隐私。

- 异常处理:使用try-except捕获网络请求异常(如超时、连接错误),避免程序中断。

- 数据准确性:部分网站数据可能重复或格式混乱,需通过去重和标准化处理提升数据质量。

- 动态页面优化:优先分析API接口减少请求量,Selenium仅作为备选方案。

常见问题与解决方案

如何应对反爬机制?

- 验证码问题:使用OCR库(如Tesseract)或第三方打码平台识别简单验证码;复杂验证码可降低请求频率或手动处理。

- IP封禁:构建代理IP池,每次请求随机切换IP,或使用Tor网络隐藏真实IP。

- 请求频率限制:设置随机延时(如

time.sleep(random.uniform(1, 3))),避免固定模式请求。

如何提高爬取效率?

- 多线程/异步请求:使用

concurrent.futures或asyncio库并发请求,减少总耗时。 - 增量爬取:记录已爬取的URL或数据ID,避免重复爬取。

- 分布式爬虫:通过Scrapy-Redis实现多机协作,大规模数据爬取时效果显著。

相关问答FAQs

Q1: 爬取招聘信息时遇到403错误怎么办?

A1: 403错误通常表示服务器拒绝访问,需检查请求头是否完整(如添加User-Agent、Referer),或尝试更换代理IP,若网站有登录验证,需先获取有效Cookie或使用Selenium模拟登录。

Q2: 如何确保爬取的数据不重复?

A2: 可通过唯一标识字段(如岗位链接、公司+岗位名称组合)去重,使用Pandas的drop_duplicates()方法实现,维护一个已爬取URL的集合,每次请求前检查是否已存在。

通过以上方法,可以高效、合法地利用Python爬取招聘信息,为求职决策或市场分析提供数据支持,实际开发中需根据目标网站的具体结构调整策略,并始终遵守法律法规和平台规则。