在数字化招聘时代,企业对人才的精准触达与高效筛选需求激增,而招聘软件作为连接求职者与企业的核心平台,积累了海量求职数据,为满足企业人才挖掘、市场分析或竞品调研等需求,招聘软件爬虫技术应运而生,其应用需在技术实现、法律合规与伦理边界间寻求平衡,本文将围绕招聘软件爬虫的技术原理、应用场景、风险挑战及合规实践展开详细探讨。

招聘软件爬虫的技术实现原理

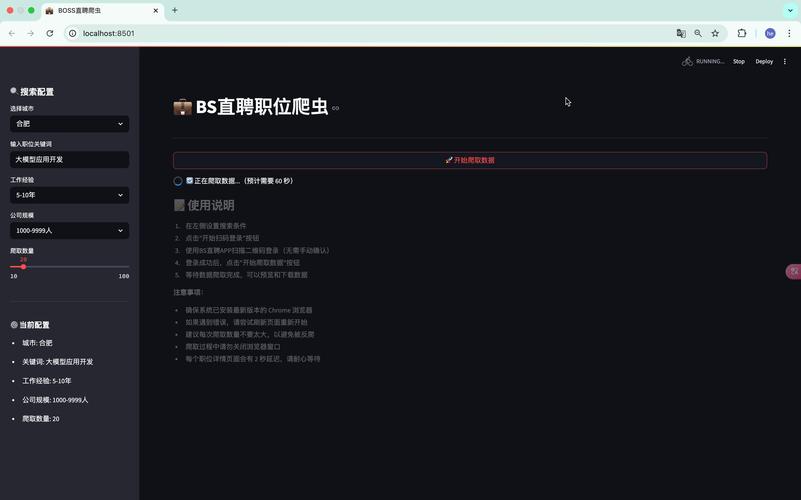

招聘软件爬虫本质上是模拟用户行为,通过自动化程序从目标招聘平台(如LinkedIn、BOSS直聘、智联招聘等)提取数据的程序,其技术实现通常包含以下几个核心环节:

数据采集模块

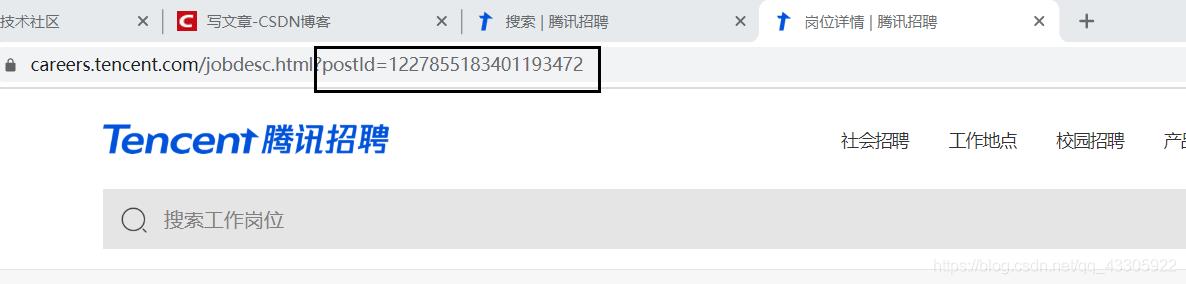

爬虫首先需确定目标数据结构,如求职者信息(姓名、学历、工作经历)、企业岗位(职位名称、薪资范围、任职要求)等,采集方式可分为静态页面爬取与动态页面解析:

- 静态页面:针对HTML结构固定的页面,爬虫通过HTTP请求(如Python的

requests库)获取页面源码,再使用BeautifulSoup或lxml解析HTML标签提取数据。 - 动态页面:现代招聘平台多依赖JavaScript渲染数据(如React、Vue框架),此时需借助无头浏览器(如Selenium、Playwright)模拟用户操作,等待页面加载完成后提取动态生成的内容。

反反爬虫对抗机制

为防止数据被恶意爬取,招聘平台普遍部署反爬虫策略,爬虫需通过技术手段应对:

- IP代理池:通过轮换代理IP(如 residential proxy、datacenter proxy)避免单一IP请求频率过高触发封禁。

- 请求头伪装:模拟真实浏览器请求头(如User-Agent、Referer、Cookie),使请求看起来来自正常用户。

- 行为模拟:控制请求频率(如随机延时、模拟鼠标滑动)、验证码识别(OCR技术或第三方打码平台)降低被识别概率。

数据存储与清洗

采集到的原始数据需经过结构化处理:

- 存储方案:关系型数据库(MySQL、PostgreSQL)适合存储结构化数据(如岗位信息),非关系型数据库(MongoDB、Elasticsearch)适合存储半结构化或文本数据(如简历内容)。

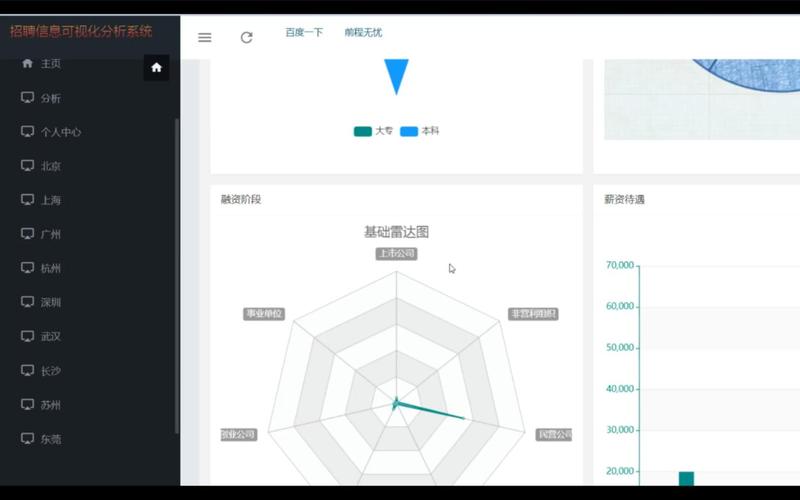

- 数据清洗:通过正则表达式、NLP技术(如分词、实体识别)去除噪声数据(如HTML标签、特殊字符),统一数据格式(如日期标准化、薪资范围拆分)。

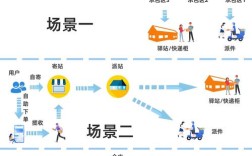

招聘软件爬虫的核心应用场景

招聘软件爬虫的价值在于将分散的招聘数据转化为可分析的“人才金矿”,其应用场景覆盖企业招聘、市场研究、职业服务等多个领域:

企业端:精准人才挖掘与岗位分析

- 被动候选人激活:企业可通过爬虫抓取目标竞品或行业内的人才简历(如具备特定技能、职级的求职者),结合内部人才库进行定向触达,提升招聘效率。

- 薪酬竞争力分析:爬取行业岗位的薪资数据(如“Java开发工程师”在不同城市的薪资范围),生成薪酬报告,为企业制定薪酬策略提供依据。

- 招聘策略优化:分析热门岗位的任职要求(如“数据分析岗”对Python、SQL的技能占比),调整招聘标准或培训计划。

市场研究:行业趋势与人才流动分析

- 行业人才需求洞察:爬取多平台岗位数据,统计高频技能词(如2023年“AI大模型”“Prompt工程”的岗位占比),预判行业技术趋势。

- 人才流动地图:追踪企业间的人才跳转路径(如从“腾讯”跳槽至“字节跳动”的产品经理数量),绘制人才流动网络,为企业人才竞争策略提供参考。

职业服务:求职辅助与行业报告

- 简历优化建议:爬取目标岗位的高匹配简历,提取共性特征(如项目描述关键词、教育背景偏好),为求职者提供简历修改建议。

- 职业规划工具:基于岗位数据生成“职业发展路径图”(如“初级测试工程师→自动化测试专家→测试经理”的晋升要求与薪资涨幅)。

招聘软件爬虫的法律风险与合规边界

尽管招聘软件爬虫具有商业价值,但其应用需严格遵守法律法规与平台规则,否则可能面临法律纠纷与声誉风险:

法律合规风险

- 数据隐私保护:根据《个人信息保护法》《网络安全法》,爬取包含个人身份信息(如姓名、电话、身份证号)、生物识别信息、行踪轨迹等敏感数据,需取得个人单独同意,否则可能构成侵权。

- 著作权与反不正当竞争:企业发布的岗位描述、简历内容可能构成著作权作品,未经授权爬取并用于商业目的可能侵犯著作权;若爬虫行为对平台服务器造成负载压力(如高频请求导致服务中断),可能违反《反不正当竞争法》。

平台规则限制

招聘平台通常在《用户协议》中明确禁止自动化工具爬取数据,违规者可能面临账号封禁、IP拉黑甚至法律诉讼,LinkedIn曾对多家数据公司提起诉讼,指控其通过爬虫非法抓取用户数据并用于招聘服务,最终赔偿高达1.2亿美元。

合实践径建议

- 最小必要原则:仅爬取与业务直接相关的必要数据,避免过度收集个人信息。

- 匿名化处理:对原始数据进行脱敏(如去除姓名、联系方式,仅保留技能、经验等非个人信息)。

- 授权与合作:优先通过平台开放API(如LinkedIn Talent Solutions)或与第三方数据服务商合作,获取合法数据源。

招聘软件爬虫的技术挑战与未来趋势

随着招聘平台反爬虫技术的升级,爬虫技术也需持续迭代,同时面临数据质量与伦理挑战:

技术挑战

- 动态页面复杂性:现代前端框架(如React、Vue)的组件化渲染增加了数据提取难度,需升级无头浏览器技术(如Puppeteer的page.evaluate()方法)。

- 反爬虫技术升级:平台引入行为分析(如鼠标移动轨迹、点击间隔)、验证码(如reCAPTCHA v3)、IP信誉评分等机制,爬虫需结合机器学习优化行为模拟。

- 数据异构性:不同平台的数据结构差异大(如BOSS直聘的“沟通中”状态、LinkedIn的“Open to work”标识),需定制化解析规则。

未来趋势

- AI驱动的智能爬虫:结合NLP技术理解非结构化数据(如简历中的项目经验描述),通过深度学习预测数据价值,提升采集精准度。

- 合规数据生态:平台可能开放合规数据接口,企业通过实名认证、数据用途声明后获取授权数据,形成“合法合规、数据共享”的生态。

- 隐私计算技术:联邦学习、差分隐私等技术可在不获取原始数据的前提下,进行联合建模与分析,平衡数据利用与隐私保护。

招聘软件爬虫应用案例(表格示例)

| 应用场景 | 案例描述 | 技术手段 | 效果 |

|---|---|---|---|

| 科技公司薪酬调研 | 某互联网企业爬取5大招聘平台“算法工程师”岗位数据,分析不同城市、经验段的薪资分布 | Selenium+代理IP+数据清洗 | 生成2023年算法岗位薪酬报告,调整offer薪资10%,降低核心人才流失率15% |

| 职业培训机构 | 机构爬取“产品经理”岗位要求,提取高频技能词(Axure、SQL、用户调研),优化课程体系 | BeautifulSoup+NLP分词+词频统计 | 课程匹配度提升25%,学员就业率从60%增至85% |

| 行业人才流动分析 | 研究机构爬取3年“新能源汽车”行业岗位数据,追踪企业间人才跳转路径 | Neo4j图数据库+网络分析 | 绘制人才流动图谱,帮助企业识别关键竞争对手的核心团队 |

相关问答FAQs

Q1:使用招聘软件爬虫抓取数据是否违法?如何判断合法性?

A:需结合数据类型、用途及平台规则综合判断,若爬取的数据包含个人信息(如电话、邮箱),且未经个人同意或超出“合理使用”范围(如仅用于个人学习、科研),则可能违反《个人信息保护法》;若数据用于商业目的(如出售人才数据、竞品分析),且未获得平台授权,则可能构成不正当竞争,合法路径包括:①通过平台开放API获取数据;②与平台签订数据合作协议;③对数据进行匿名化处理(如去除个人身份信息),且确保不用于识别特定个人。

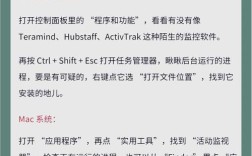

Q2:如何避免招聘软件爬虫被封禁?有哪些实用技巧?

A:避免封禁的核心是模拟真实用户行为,降低被识别概率,实用技巧包括:①控制请求频率(如每次请求间隔5-10秒,避免高频访问);②使用代理IP池(轮换住宅IP或数据中心IP,避免单一IP请求过多);③伪装请求头(模拟Chrome、Firefox等浏览器的User-Agent,携带Referer和Cookie);④处理验证码(通过OCR工具或第三方打码平台识别图形验证码,或使用Selenium模拟人工操作);⑤定期更新爬虫策略(如更换User-Agent、调整请求参数),适应平台反爬虫机制的升级。