搜索引擎爬取是信息检索系统的基础环节,其核心目标是高效、全面地发现并收集互联网上的网页资源,为后续的索引和检索提供数据支撑,这一过程涉及多个技术环节的协同,从初始的种子URL选择到页面的解析与存储,形成了一套复杂而精密的机制。

搜索引擎爬取的第一步是构建初始的URL集合,通常称为“种子URL”,这些种子URL可能来源于人工编辑推荐的优质网站、历史爬取数据中的高频URL、合作伙伴提供的数据源,或是通过其他搜索引擎公开的API获取,获得种子URL后,爬取系统会将其存储在一个称为“待抓取URL队列”(URL Frontier)的数据结构中,这个队列是整个爬取过程的“调度中心”,其管理策略直接影响爬取的效率和质量,URL队列通常采用优先级队列的形式,优先级可能基于URL的重要性、更新频率、域名负载等多种因素计算得出,知名新闻网站的首页可能比普通用户的博客页面具有更高的优先级,从而被优先抓取。

爬取程序会从URL队列中取出一个或多个URL,向目标网页所在的服务器发送HTTP请求,这个过程模拟了普通用户浏览器的行为,但需要遵守特定的规则和礼仪,以避免对目标服务器造成过大压力,HTTP请求通常包含请求头(Header)信息,如User-Agent(标识爬取程序的来源,如“Googlebot”或“Baiduspider”)、Accept(声明可接受的响应类型)等,服务器收到请求后,会返回HTTP响应,状态码(Status Code)是判断请求成功与否的关键,200表示成功,404表示页面不存在,301/302表示页面永久或临时重定向,而403则表示禁止访问,爬取程序需要根据不同的状态码采取不同的处理策略:对于200响应,则获取页面的内容;对于重定向响应,则会提取新的URL并加入待抓取队列;对于403或404等错误,则可能暂时放弃该URL或记录错误信息。

后,爬取程序需要对HTML文档进行解析,以提取出有价值的信息,主要包括两部分:一是页面的正文内容,即用户可见的文字、图片、视频等多媒体信息;二是页面中的超链接,即指向其他网页的URL,HTML解析通常使用专门的解析器(如基于DOM或SAX的解析器),将HTML字符串转换成树状结构,从而方便地定位和提取特定标签内的内容。<a>标签中的href属性值就是典型的超链接,提取出的正文内容会被送入后续的索引处理流程,而提取出的超链接则需要经过一系列的预处理后,才能被加入待抓取URL队列。

预处理是保证爬取质量和效率的重要环节,主要包括URL规范化(Normalization)和去重(Deduplication),URL规范化旨在将不同形式但指向同一资源的URL统一为标准格式。http://example.com/和http://example.com/index.html可能是同一个首页,规范化后会将其转换为统一的表示形式,常见的规范化操作包括将主机名转换为小写、移除默认的端口号(如80)、解析并规范化URL路径、移除片段标识符(#后的内容)等,去重则是为了避免重复爬取和索引相同的页面,由于互联网上存在大量内容重复或镜像的页面,通过计算URL或页面内容的哈希值(如MD5、SHA-1),可以快速判断一个URL是否已经被处理过,从而避免不必要的资源浪费。

在爬取过程中,爬取程序需要遵守一系列规则,这些规则通常以robots.txt文件的形式存在于网站根目录下。robots.txt是遵循Robots协议的文本文件,它告知搜索引擎哪些页面可以爬取,哪些不可以。User-agent: * Disallow: /admin/表示所有爬取程序都不得访问/admin/目录下的页面,爬取程序在抓取一个网站之前,应首先获取并解析其robots.txt文件,并将其中的规则应用到后续的URL请求中,爬取程序还需要控制请求的频率,通过设置请求间隔(Crawl-delay)或并发数,避免因请求过于密集而给目标服务器带来负担,甚至导致IP被封禁,一些大型搜索引擎还会建立网站联系人的机制,当需要大规模爬取某个网站时,尝试通过站长平台等方式与网站管理员沟通,以获得许可和指导。

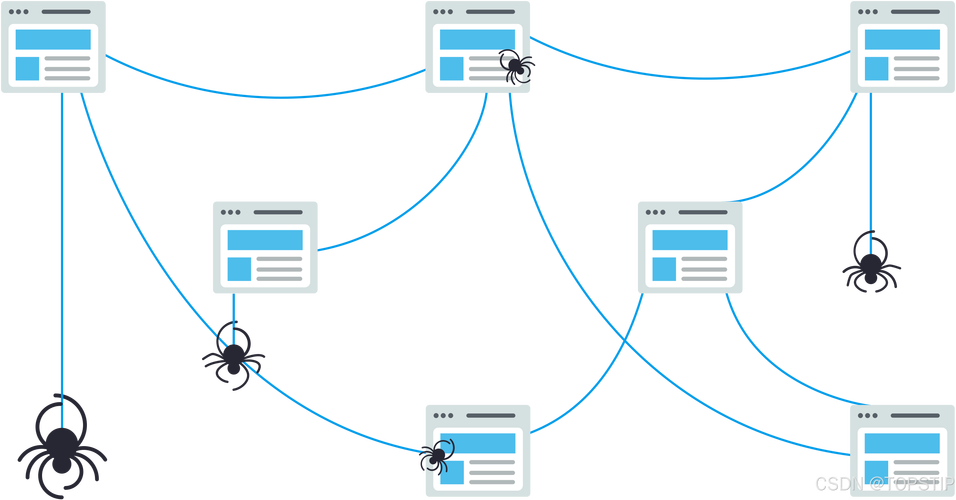

为了应对互联网的动态变化和海量规模,现代搜索引擎的爬取系统通常采用分布式架构,成百上千台爬取节点(Crawler Traps)组成一个集群,协同工作,每个节点负责一部分URL的抓取,并通过一个中心化的调度系统(URL队列管理器)来分配任务和协调进度,分布式架构不仅提高了爬取的并行度和效率,也增强了系统的容错能力,当某个节点出现故障时,其他节点可以接替其工作,为了应对网络延迟和服务器响应时间的不确定性,爬取系统通常会实现异步I/O模型,使得一个线程在等待网络响应的同时,可以处理其他URL的请求,从而最大化CPU和网络资源的利用率。 的爆炸式增长,爬取系统也面临着诸多挑战,如何有效处理JavaScript渲染的页面,因为传统爬取程序可能无法执行JS代码,从而无法获取到动态加载的内容;如何识别和规避“爬取陷阱”(Crawler Traps),如通过URL参数无限生成的页面;如何处理多语言、编码格式各异的页面,确保内容正确解析;以及如何在遵守法律法规和伦理规范的前提下,高效地抓取公开信息,针对这些挑战,爬取技术也在不断发展,例如引入无头浏览器(Headless Browser)技术来渲染JS页面,设计更复杂的URL模式识别算法来规避爬取陷阱,以及采用更智能的编码检测机制等。

为了更清晰地展示爬取过程中的关键步骤及其作用,可以将其归纳为下表:

| 步骤名称 | 主要操作 | 关键技术/工具 | 目的 |

|---|---|---|---|

| 种子URL选择 | 确定初始爬取范围,获取一批起始URL | 人工编辑、历史数据、合作伙伴API | 构建爬取的起点,覆盖核心互联网资源 |

| URL队列管理 | 存储待抓取URL,根据优先级调度 | 优先级队列、调度算法(如广度优先、深度优先) | 优化爬取顺序,优先重要和高价值页面 |

| HTTP请求与响应 | 向目标服务器发送请求,接收并解析响应 | HTTP协议、请求头定制(User-Agent等)、状态码处理 | 获取网页原始内容,处理网络异常和服务器反馈 |

| 页面解析 | 提取页面正文内容和超链接 | HTML解析器(DOM/SAX)、正则表达式 | 与链接,为索引和后续爬取提供数据 |

| URL预处理 | 规范化URL格式,去除重复URL | URL规范化算法、哈希算法(MD5/SHA-1) | 统一URL表示,避免重复爬取,提高效率 |

| 遵守爬取规则 | 解析并遵守robots.txt协议,控制爬取频率 |

Robots协议解析器、请求频率控制(Crawl-delay) | 尊重网站意愿,避免对服务器造成冲击,维护良好的爬取生态 |

| 分布式与并行化 | 多节点协同工作,分配任务,共享状态 | 分布式系统、消息队列、负载均衡 | 提高爬取速度和规模,增强系统健壮性和容错能力 |

搜索引擎爬取是一个涉及调度、网络通信、文档处理、规则遵守和系统优化的综合性工程,它从最初的种子URL出发,通过精心设计的队列调度策略,向互联网服务器发起请求,获取并解析网页内容,同时提取新的链接进行扩展,整个过程严格遵守Robots协议等规范,并借助分布式架构应对海量数据的挑战,爬取的质量和效率直接决定了搜索引擎索引库的丰富程度和时效性,是整个搜索引擎能够提供精准、快速服务的关键前提。

相关问答FAQs:

Q1: 为什么有些网页搜索引擎搜不到?

A1: 网页无法被搜索引擎搜到通常有以下几方面原因:该网站可能通过robots.txt文件明确禁止搜索引擎爬取该页面;页面可能设置了登录权限(如需要注册或付费才能访问),爬取程序无法获取内容;页面可能存在技术障碍,如大量依赖JavaScript动态加载内容,而传统爬取程序无法执行JS;页面可能存在“爬取陷阱”,导致爬取程序陷入无限循环;也可能是该页面是新发布的,搜索引擎尚未发现和爬取到。

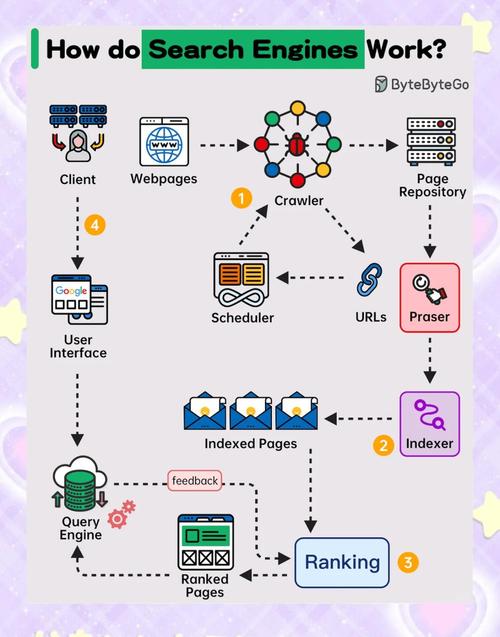

Q2: 搜索引擎爬取和索引是一回事吗? A2: 不是一回事,两者是搜索引擎工作流程中两个紧密相连但本质不同的阶段,爬取(Crawling)是指搜索引擎的爬虫程序发现、获取并下载网页的过程,其核心是“收集原始数据”,而索引(Indexing)则是指搜索引擎对爬取到的网页内容进行分析、处理(如分词、提取关键词、计算权重等),并将其结构化地存储到庞大的数据库(索引库)中的过程,其核心是“组织和优化数据”,爬取是“把书从图书馆借出来”,而索引是“把书的内容编成目录卡片”,只有经过索引的页面才能在搜索结果中展现。