在当今数字化浪潮下,企业运营中产生的数据量呈爆炸式增长,其中大量数据以混沌状态存在——这些数据结构不统一、格式多样、质量参差不齐,且往往分散在不同系统中,被称为“混沌数据”,如何从混沌数据中挖掘价值,已成为企业提升竞争力的关键,这也催生了对混沌数据处理人才的迫切需求,尤其在招聘领域,相关岗位的要求和标准正在发生深刻变化。

混沌数据的来源广泛,包括用户行为日志、传感器数据、社交媒体文本、业务交易记录等,其特征表现为高维性、稀疏性、噪声多和关联复杂,电商平台的用户数据可能同时包含结构化的购买记录、半结构化的浏览日志,以及非结构化的评论文本,这些数据若未经处理,直接用于分析会导致结果偏差;制造企业的设备传感器数据可能因采样频率不同、设备型号差异而形成混乱的时间序列,影响故障预测的准确性,企业亟需能够驾驭混沌数据的复合型人才,这类人才不仅要掌握传统数据处理技能,还需具备跨领域的综合能力。

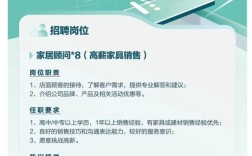

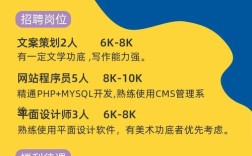

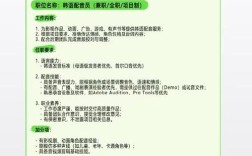

在招聘混沌数据相关岗位时,企业通常关注候选人的三大核心能力:技术硬实力、业务理解力和创新思维,技术层面,候选人需熟练掌握Python、SQL等编程语言,熟悉Hadoop、Spark等大数据处理框架,以及数据清洗、特征工程、机器学习建模等技能,同时了解NoSQL数据库(如MongoDB、Cassandra)的应用,以应对非结构化数据的存储与处理需求,业务层面,要求候选人能深入理解行业场景,将数据问题转化为业务解决方案,例如在金融领域,需具备风险控制或反欺诈的业务知识;在医疗领域,需了解病历数据的特点和分析逻辑,创新思维则体现在面对模糊数据问题时,能设计出灵活的处理流程,通过探索性数据分析发现隐藏规律,而非依赖固定模板。

为更精准地筛选人才,企业可构建多维度的评估体系,在技术面试中,可通过实际案例分析考察数据处理能力,例如给出一份包含缺失值、异常值和重复记录的混沌数据集,要求候选人设计清洗流程并说明理由;在业务场景测试中,可设置模拟问题,如“如何利用用户行为数据提升复购率”,考察候选人将数据与业务目标结合的能力;还可增加工具实操环节,测试候选人在Spark或Python中的代码编写效率与规范性,值得注意的是,混沌数据岗位更强调“解决问题”而非“记忆知识”,因此面试中应减少对概念定义的机械提问,多聚焦实际场景的应对策略。

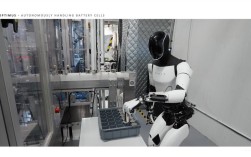

随着人工智能技术的发展,混沌数据处理工具不断迭代,从传统的ETL(抽取、转换、加载)工具到智能化的数据清洗平台,岗位需求也在动态演变,具备AI辅助数据处理能力、熟悉实时数据流处理(如Flink框架)、以及掌握数据可视化和叙事能力的候选人将更具竞争力,企业在招聘时,需打破“唯学历”“唯经验”的固化思维,重点关注候选人的学习能力和技术适应性,因为混沌数据领域的技术更新速度远超传统行业,持续学习是人才保持价值的核心要素。

相关问答FAQs

Q1:混沌数据岗位与常规数据分析师岗位的主要区别是什么?

A1:常规数据分析师多处理结构化、高质量的数据,侧重描述性分析和可视化呈现;而混沌数据岗位需应对非结构化、低质量的数据,核心能力包括数据清洗、噪声处理、多源数据融合,以及通过机器学习等技术从模糊数据中挖掘深层规律,对跨工具应用和业务场景理解的要求更高。

Q2:非计算机专业背景的候选人如何进入混沌数据领域?

A2:非计算机专业候选人可从“业务+数据”的交叉点切入,首先通过在线课程(如Coursera的数据科学专项)掌握Python、SQL等基础工具,再结合自身行业经验积累业务场景认知,例如从业务数据分析师岗位转型,逐步接触数据清洗和建模工作,同时参与开源项目或实践案例提升技术实操能力,弥补专业背景的不足。