在数字化时代,招聘行业正经历着从传统人工筛选到智能化、自动化管理的转型,而“爬虫程序”作为数据采集的核心工具,在其中扮演着不可或缺的角色,爬虫程序通过模拟浏览器行为,自动抓取互联网上的招聘信息、企业数据、候选人简历等,为招聘平台、企业HR以及求职者提供了高效的数据支持,本文将详细探讨爬虫程序在招聘领域的应用、技术实现、伦理挑战及未来趋势。

爬虫程序在招聘领域的核心应用场景

爬虫程序在招聘行业的应用贯穿于信息采集、数据分析、市场调研等多个环节,其核心价值在于提升效率、降低成本并挖掘潜在价值。

招聘信息聚合与平台搭建

主流招聘网站(如智联招聘、前程无忧、BOSS直聘等)每日发布数百万条职位信息,但信息分散在不同平台,求职者需逐一筛选,爬虫程序可定时抓取各平台的职位数据,包括岗位名称、薪资范围、工作地点、任职要求等,并整合到统一的招聘平台或数据库中,某垂直招聘平台通过爬取10+主流网站数据,构建了覆盖互联网、金融、制造等多行业的职位库,用户可一站式查询全网岗位信息,大幅提升匹配效率。

企业人才画像与竞争分析

企业HR可通过爬虫程序收集目标行业的企业招聘动态,分析竞争对手的人才需求、薪资水平及岗位分布,某互联网公司为制定2024年校招计划,爬取了50家头部企业的技术岗位JD(职位描述),通过关键词分析发现“AI算法”“大数据开发”等岗位需求同比增长30%,且薪资中位数较去年提升15%,从而调整了自身招聘策略,爬虫还可抓取企业官网的“加入我们”页面、领英公司主页等,获取企业组织架构、文化价值观等信息,辅助构建人才画像。

候选人简历库与被动人才挖掘

猎头和企业HR常需主动寻找潜在候选人,而公开的简历数据分散于各大社交平台和职业网站,爬虫程序可定向抓取领英、脉脉、知乎等平台的公开信息(如用户职业经历、技能标签、项目经验等),结合自然语言处理(NLP)技术,构建候选人简历库,某猎头公司通过爬取脉脉上“大数据”话题下的用户动态,筛选出具备3年以上工作经验且活跃度高的候选人,主动推送匹配度高的职位,转化率较传统渠道提升40%。

薪资数据监测与市场报告

薪资是招聘中的核心敏感信息,爬虫程序可实时抓取各平台公开的薪资数据,结合地域、行业、经验等维度进行分析,生成薪资报告,某数据研究机构爬取了2023年某一线城市10万条互联网岗位薪资数据,通过交叉分析发现:后端开发岗5年经验者薪资中位数为25k/月,而人工智能岗同经验薪资达35k/月,为企业和求职者提供市场参考。

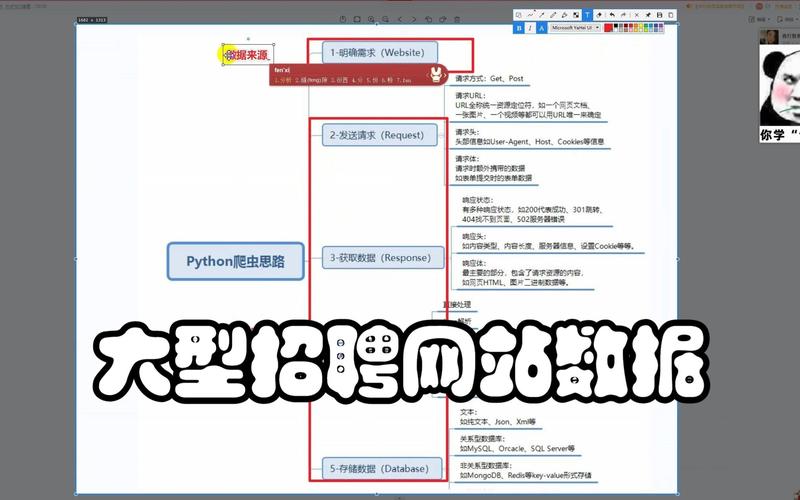

爬虫程序的技术实现与关键步骤

爬虫程序的开发需结合目标网站结构、反爬机制及数据处理需求,以下是核心实现流程:

环境准备与工具选择

- 编程语言:Python是主流选择,拥有Scrapy、PySpider等成熟爬虫框架,以及Requests(HTTP请求)、BeautifulSoup(HTML解析)、Selenium(动态页面渲染)等库。

- 数据存储:MySQL、MongoDB等数据库用于存储结构化/非结构化数据,Elasticsearch支持实时检索。

- 反爬应对:IP代理池(如阿布云、快代理)、User-Agent池、验证码识别(Tesseract OCR、第三方打码平台)、分布式爬虫(Scrapy-Redis)等。

数据抓取流程

以抓取某招聘网站“Java开发工程师”岗位为例:

- 发送HTTP请求:使用Requests库构造GET请求,携带Headers(模拟浏览器访问),目标URL为

https://www.zhaopin.com/job_search_result?jl=530&kw=Java开发工程师。 - 解析页面内容:若页面为静态HTML,用BeautifulSoup解析DOM树,提取岗位信息;若为动态加载(如JavaScript渲染),则用Selenium模拟浏览器操作,等待数据加载后获取源码。

- 数据提取与清洗:通过XPath或CSS选择器定位字段,如

//div[@class='job-info']//h3/text()提取岗位名称,提取后的数据需进行去重、格式转换(如薪资“15k-25k”转为数值范围)。 - 存储与更新:将清洗后的数据存入MySQL数据库,设置定时任务(如每日2点爬取),增量更新新增岗位。

动态与反爬应对

现代招聘网站普遍采用动态加载和反爬策略:

- 动态页面:通过分析XHR请求(浏览器开发者工具>Network),直接调用后端API获取数据,如

https://www.lagou.com/jobs/positionAjax.json?needAddtionalResult=false。 - IP封禁:采用轮换代理IP(每次请求更换IP),设置请求间隔(如5秒/次),避免高频访问。

- 验证码:对于滑动验证码,可使用Selenium模拟拖动;对于图形验证码,调用打码平台API识别。

爬虫程序的伦理风险与合规边界

尽管爬虫程序为招聘行业带来效率提升,但其应用需严格遵守法律法规与伦理规范,避免引发数据安全与隐私问题。

法律风险

- 《网络安全法》与《数据安全法》:明确爬虫不得违反robots.txt协议(如

Disallow:/字段),不得抓取非公开数据(如用户简历的联系方式、身份证号等),否则可能面临侵权诉讼。 - 个人信息保护:根据《个人信息保护法》,爬取公开信息时需确保数据“最小必要”,不得过度收集,且需对敏感信息(如薪资、学历)脱敏处理。

伦理争议

- 数据垄断:部分招聘平台通过爬虫抓取其他平台数据,形成信息壁垒,损害行业公平竞争。

- 求职者隐私:若候选人简历在未授权被抓取并用于商业用途,可能侵犯其肖像权与隐私权。

合规建议

- 尊重robots协议:爬虫程序应优先遵守目标网站的robots.txt规则,如

Disallow:/user/表示禁止抓取用户隐私页面。 - 数据脱敏与授权:对抓取的候选人信息去除手机号、邮箱等敏感字段,企业内部使用时需签订数据授权协议。

- 技术留痕:记录爬虫访问日志,包括访问时间、IP、请求内容,便于追溯与合规审查。

未来趋势:AI驱动的智能招聘爬虫

随着人工智能技术的发展,招聘爬虫正从“数据采集工具”向“智能分析助手”进化:

- 语义理解与精准匹配:结合NLP技术,爬虫可解析JD中的隐性需求(如“抗压能力强”对应“加班频率高”),提升岗位与候选人的匹配准确率。

- 预测性分析:基于历史招聘数据,爬虫可预测未来行业人才需求趋势,如“新能源汽车行业电池工程师岗位需求将在2024年Q3增长50%”。

- 自动化招聘流程:爬虫与AI面试系统、ATS( applicant Tracking System)联动,实现从数据抓取、简历筛选到面试安排的全流程自动化。

相关问答FAQs

Q1:使用爬虫程序抓取招聘数据是否合法?

A1:合法性取决于数据来源与用途,若仅抓取公开信息(如岗位描述、公司简介)且遵守robots协议,一般不违法;但若抓取非公开个人信息(如简历联系方式、身份证号)或用于商业倒卖,则违反《网络安全法》《个人信息保护法》,需承担法律责任,建议企业内部使用爬虫时,咨询法律顾问并制定合规的数据使用规范。

Q2:如何避免招聘网站的反爬机制导致IP被封禁?

A2:可通过以下方法降低被封风险:①使用高质量代理IP池,避免单一IP高频访问;②设置随机请求间隔(如3-10秒),模拟人类操作节奏;③定期更换User-Agent,避免被识别为爬虫;④采用分布式爬虫,将任务分配到多个节点;⑤对验证码等反爬措施,调用专业打码平台或人工辅助识别,需严格遵守目标网站的访问频率限制,避免过度请求。