(H1):Hadoop命令使用完全指南:从入门到精通,掌握大数据核心操作

Meta描述: 还在为Hadoop命令头疼?本文是一份超详细的Hadoop命令使用完全指南,涵盖HDFS、YARN、MapReduce等核心组件的常用命令,配有清晰实例与场景解析,助你从入门到精通,轻松驾驭大数据操作。

(引言/开篇)

在数字化浪潮席卷全球的今天,大数据已成为企业决策与创新的“新石油”,而Hadoop,作为大数据处理领域的“元老级”框架,其重要性不言而喻,无论是数据分析师、后端工程师还是大数据爱好者,熟练掌握Hadoop命令都是一项必备的核心技能。

你是否也曾遇到过这样的困惑:

- 如何在庞大的HDFS文件系统中上传、下载或查看文件?

- 如何监控一个MapReduce或Spark作业的运行状态?

- 如何排查Hadoop集群中的常见问题?

别担心,这篇文章就是为你量身打造的“Hadoop命令使用”速查宝典,我们将从最基础的HDFS命令讲起,逐步深入到YARN资源管理和MapReduce作业控制,让你在阅读后,不仅能“知其然”,更能“知其所以然”,真正将命令运用到实际工作中。

(H2)一、 核心基础:HDFS文件系统命令详解

HDFS(Hadoop Distributed File System)是Hadoop的基石,所有的大数据计算都建立在对HDFS的操作之上,熟练掌握HDFS命令是第一步。

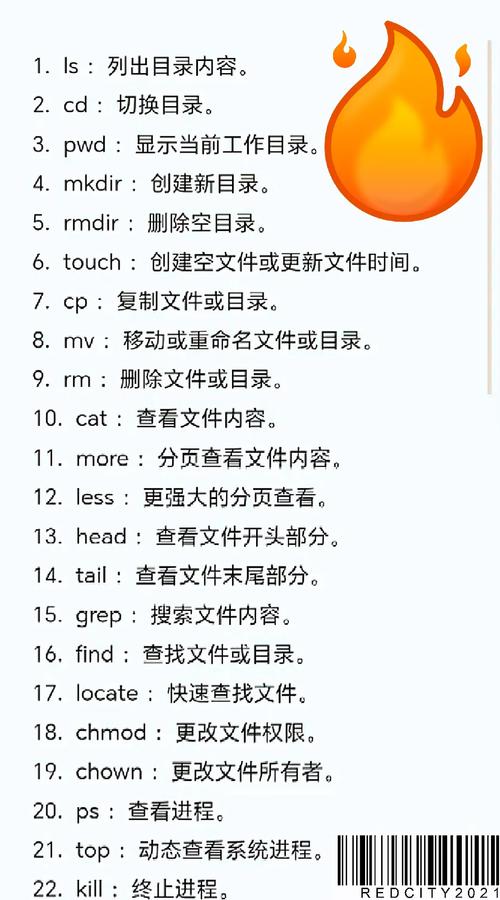

(H3)1.1 文件与目录管理:如同操作Linux

HDFS的命令语法与Linux Shell命令高度相似,如果你熟悉Linux,上手会非常快。

| 命令 | 功能描述 | 实例与场景 |

|---|---|---|

hdfs dfs -ls <path> |

列出指定路径下的文件和目录 | hdfs dfs -ls /:查看HDFS根目录下所有内容。 |

hdfs dfs -mkdir <path> |

创建新的目录 | hdfs dfs -mkdir -p /user/data/input:递归创建多级目录,常用于准备数据输入路径。 |

hdfs dfs -put <local> <hdfs> |

从本地文件系统上传文件到HDFS | hdfs dfs -put /home/user/local.txt /user/data/input/:将本地文件上传至HDFS,为后续MapReduce作业准备数据。 |

hdfs dfs -get <hdfs> <local> |

从HDFS下载文件到本地文件系统 | hdfs dfs -get /user/data/output/result.txt /home/user/:将HDFS上的计算结果下载到本地进行分析。 |

hdfs dfs -rm [-r] <path> |

删除文件或目录(-r用于递归删除目录) |

hdfs dfs -rm /user/data/input/old_file.txt:删除单个文件。hdfs dfs -rm -r /user/data/output:清空输出目录,为下一次运行做准备。 |

hdfs dfs -mv <src> <dst> |

移动或重命名文件/目录 | hdfs dfs -mv /user/data/input/file1.txt /user/data/backup/:移动文件到备份目录。 |

hdfs dfs -cp <src> <dst> |

复制文件/目录 | hdfs dfs -cp /user/data/input/file1.txt /user/data/input/file2.txt:复制一份文件作为测试数据。 |

hdfs dfs -cat <path> |

在终端显示文件内容 | hdfs dfs -cat /user/data/input/sample.log:查看日志文件的前几行,快速预览数据。 |

(H3)1.2 HDFS高级与运维命令

除了日常操作,了解一些高级命令对于系统管理和性能优化至关重要。

| 命令 | 功能描述 | 实例与场景 |

|---|---|---|

hdfs dfs -du [-s] [-h] <path> |

查看目录或文件所占空间 | hdfs dfs -du -s -h /user/data:-s汇总显示,-h以人类可读格式(如KB, MB)显示总大小,用于评估数据规模。 |

hdfs dfs -chown [-R] <owner>:<group> <path> |

修改文件/目录的所有者和所属组 | hdfs dfs -chown -R hadoop:hadoop /user/data:修改整个数据目录的权限,确保Hadoop用户有读写权限。 |

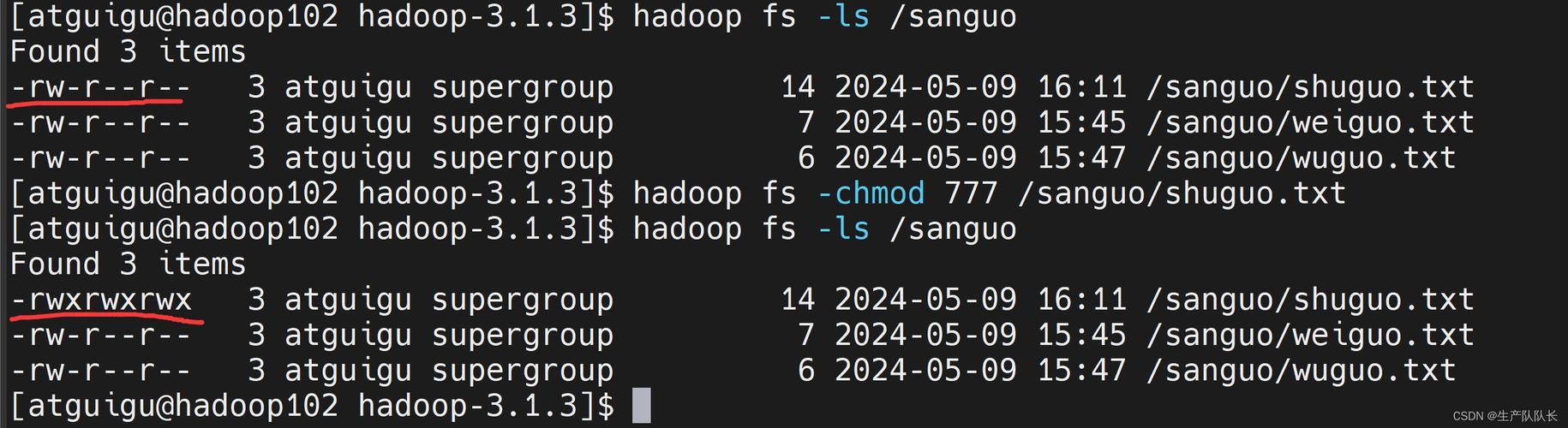

hdfs dfs -chmod [-R] <mode> <path> |

修改文件/目录的权限 | hdfs dfs -chmod 755 /user/data:设置目录权限,保证数据安全。 |

hdfs dfs -count [-q] <path> |

统计目录下文件数量、目录数量和总大小 | hdfs dfs -count -q /user/data:-q显示配额信息,用于空间管理。 |

(H2)二、 作业调度:YARN命令与资源管理

Hadoop 2.0引入了YARN(Yet Another Resource Negotiator),它将资源管理和作业调度/监控功能分离开来,使得Hadoop集群更加通用和高效。

(H3)2.1 查看集群与节点状态

在提交作业前,了解集群的健康状况是必不可少的。

| 命令 | 功能描述 | 实例与场景 |

|---|---|---|

yarn node -list |

列出所有正在运行NodeManager的节点 | yarn node -list:快速检查集群中有多少个计算节点在工作。 |

yarn node -status <nodeId> |

查看指定节点的详细信息 | yarn node -status node1:8042:排查某个特定节点是否资源不足或状态异常。 |

yarn application -list |

列出所有应用程序 | yarn application -list:查看当前集群上运行了哪些作业。 |

yarn application -status <appId> |

查看指定应用程序的详细信息 | yarn application -status application_1234567890012_0001:这是最常用的命令,用于跟踪作业的运行状态(如ACCEPTED, RUNNING, SUCCEEDED, FAILED)。 |

(H3)2.2 作业生命周期管理

当你提交了一个长时间运行的作业,你可能需要管理它。

| 命令 | 功能描述 | 实例与场景 |

|---|---|---|

yarn application -kill <appId> |

终止一个正在运行的应用程序 | yarn application -kill application_1234567890012_0001:作业卡死或发现逻辑错误,立即终止以释放资源。 |

yarn application -kill <appId> |

终止一个正在运行的应用程序 | yarn application -kill application_1234567890012_0001:作业卡死或发现逻辑错误,立即终止以释放资源。 |

yarn logs -applicationId <appId> |

获取应用程序的日志 | yarn logs -applicationId application_1234567890012_0001 > app.log:将作业日志导出到本地文件,是调试程序错误的利器。 |

(H2)三、 数据处理:MapReduce命令实战

MapReduce是Hadoop的原始计算模型,虽然现在Spark更流行,但理解MapReduce的执行过程对掌握大数据思想至关重要。

(H3)3.1 运行与监控MapReduce作业

| 命令 | 功能描述 | 实例与场景 |

|---|---|---|

hadoop jar <jar> <mainClass> [args] |

提交并运行一个MapReduce作业 | hadoop jar wordcount.jar com.example.WordCount /user/data/input /user/data/output:经典的WordCount作业提交命令。 |

mapred job -status <jobId> |

查看MapReduce作业的详细信息 | mapred job -status job_1234567890012_0001:查看作业的Map和Reduce任务进度、输入/输出大小等。 |

mapred job -history [history] |

查看作业的历史记录 | mapred job -history /user/data/output:查看已完成的作业的总结报告,包括成功/失败原因、资源消耗等。 |

(H2)四、 命令之外:高效使用Hadoop的实用技巧

记住命令只是第一步,如何高效、安全地使用它们才是关键。

- 善用Tab键自动补全:在配置好Hadoop环境变量后,在命令行输入

hdfs dfs或yarn后按Tab键,可以自动补全可用的子命令,提高效率,减少拼写错误。 - 注意路径格式:HDFS路径总是以开头,例如

/user/data,而不是user/data。 - 权限管理是生命线:在生产环境中,务必通过

chown和chmod设置好严格的文件权限,防止数据泄露或误操作。-R(递归)选项非常有用。 - 日志是最好的老师:当作业失败时,不要慌张,首先使用

yarn logs -applicationId <appId>获取日志,日志中会清晰地指出错误原因,如java.io.FileNotFoundException通常是文件路径问题,OutOfMemoryError则是内存不足。 - 理解HDFS的“一次写入,多次读取”:HDFS不适合频繁修改文件,设计数据处理流程时,应尽量将数据以追加或新生成文件的方式写入,而不是原地修改。

(H2)五、 总结与展望

本文系统地梳理了Hadoop生态中最核心的几类命令,从基础的HDFS文件操作,到YARN的资源调度,再到MapReduce的作业执行,并提供了一个实用的故障排查思路。

Hadoop命令使用是大数据工程师的“基本功”,它不仅仅是几个孤立的单词,而是你与分布式系统对话的语言,熟练掌握它们,意味着你能够自如地管理数据、调度资源、监控任务,从而高效地完成大数据处理工作。

随着技术的发展,虽然出现了更多如Spark、Flink等更高效的计算框架,但它们大多仍然运行在YARN之上,并依赖HDFS作为存储,本篇文章所讲的Hadoop命令,在很长一段时间内都将是大数据领域从业者不可或缺的知识财富。

打开你的终端,尝试执行这些命令吧!实践是掌握技术的唯一捷径。

(文章底部/SEO优化)

相关热门搜索推荐:

- hadoop常用命令大全

- hdfs命令详解

- yarn命令使用教程

- hadoop面试题及答案

- hadoop集群配置

- mapreduce命令示例

- 大数据学习路线

- hadoop shell命令

互动话题: 你在使用Hadoop命令时,遇到过最棘手的问题是什么?又是如何解决的?欢迎在评论区分享你的经验和故事!