爬虫工程师招聘面试通常会涉及多个方面的知识,包括Python编程基础、网络协议、反爬虫机制、数据处理与存储、项目经验等,以下从常见的技术问题、项目经验考察、反爬虫应对策略以及实际编程题等方面展开详细说明。

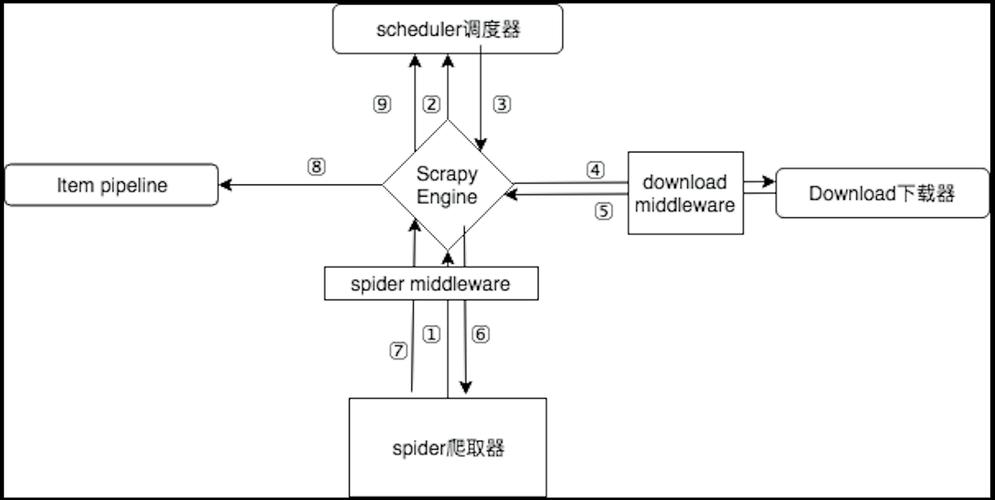

在Python基础方面,面试官可能会考察候选人对Python核心库的掌握程度,例如requests、BeautifulSoup、Scrapy、XPath、正则表达式等,常见问题包括:“请简述requests库和urllib库的区别?”答案可以从易用性、性能、功能丰富度等角度回答,例如requests库语法更简洁,支持Session对象,而urllib是Python标准库,无需安装但功能相对基础,可能会问“Scrapy框架中Spider和CrawlerRunner的区别”,需要说明Spider是爬虫的核心类,定义了爬取逻辑,而CrawlerRunner用于运行和管理多个爬虫实例。

网络协议相关的问题重点考察HTTP/HTTPS原理,GET和POST请求的区别”,除了常规的方法不同、参数传递方式不同外,还需提到GET请求会被浏览器缓存,而POST请求更适合敏感数据传输。“Cookie和Session的作用及区别”也是高频考点,Cookie存储在客户端,Session存储在服务器,常用于用户状态管理,爬虫中可能需要模拟登录,因此理解Cookie的传递机制(如headers中的Cookie字段)和Session的维持(如requests.Session的使用)至关重要。

反爬虫机制是爬虫工程师的核心能力之一,面试官可能会问“如何应对IP封禁?”,常见策略包括使用代理IP池(如轮换高匿代理)、降低请求频率(设置time.sleep)、模拟随机User-Agent等,针对动态网页,问题可能涉及“如何爬取JavaScript渲染的页面?”,需说明使用Selenium、Playwright或Pyppeteer等工具,以及无头浏览器模式的配置。“验证码的处理方法”也是重点,简单验证码可通过OCR(如Tesseract)识别,复杂验证码可能需要第三方平台(如打码兔)或对接验证码识别API。

数据处理与存储方面,考察候选人对数据清洗、存储和效率优化的能力,爬取的数据如何去重?”,常用方法包括使用布隆过滤器(Bloom Filter)或数据库唯一索引(如MySQL的UNIQUE约束),对于大规模数据存储,可能会问“如何选择数据库?”,需根据场景分析:MySQL适合结构化数据,MongoDB适合非结构化数据,Redis适合缓存高频访问数据。“如何优化爬取效率?”可能涉及异步请求(如aiohttp库)、分布式爬虫(如Scrapy-Redis)或增量爬取(通过记录已爬取URL的指纹)。

项目经验考察通常要求候选人描述实际爬虫项目,请介绍一个你负责的爬虫项目,遇到的挑战及解决方案”,回答时应涵盖项目目标(如爬取电商商品信息)、技术选型(为何用Scrapy而非requests)、数据量(如日均爬取10万条数据)、遇到的难点(如反爬策略导致IP被封,解决方案是搭建代理IP池并动态更换)以及成果(如数据用于价格监控,准确率达95%)。

实际编程题可能涉及代码实现,用Python编写一个爬虫,爬取知乎某个话题下的所有问题标题和链接”,参考代码如下:

import requests

from bs4 import BeautifulSoup

import time

url = "https://www.zhihu.com/topic/19562128/hot"

headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36"}

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.text, "html.parser")

for item in soup.select(".ContentItem-title a"):

print(item.text.strip(), item["href"])

time.sleep(1) # 礼貌性爬取

面试官可能会追问代码优化点,如添加异常处理(try-except)、使用Session对象、配置代理等。

相关问答FAQs:

-

问:爬虫遇到403 Forbidden错误怎么办?

答:403错误通常表示服务器禁止访问,解决方法包括:检查User-Agent是否被识别(随机更换User-Agent)、添加请求头(如Referer模拟正常访问)、使用代理IP隐藏真实IP,或降低请求频率避免触发反爬机制。 -

问:如何设计一个分布式爬虫系统?

答:分布式爬虫的核心是任务分配和结果去重,可采用Scrapy-Redis框架,利用Redis作为任务队列(存储待爬取URL)和去重集合(存储已爬取URL指纹),多台爬虫节点从Redis队列获取任务,爬取结果存储到共享数据库(如MongoDB),并通过Redis的分布式锁协调节点间的任务分配,避免重复爬取。