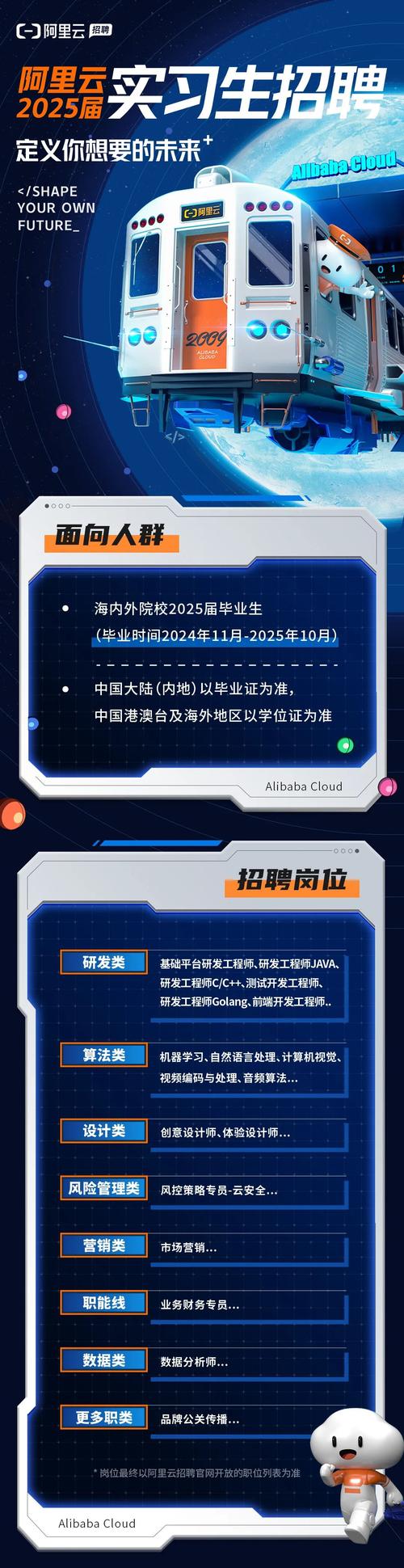

在数字化时代,招聘信息的快速获取与分析对求职者和企业都具有重要意义,对于求职者而言,实时掌握目标企业的招聘需求、岗位要求及薪资范围,能显著提升求职效率;对于企业HR或行业分析师,通过技术手段批量采集招聘数据,有助于洞察行业人才需求趋势、优化招聘策略,阿里作为国内互联网行业的领军企业,其招聘信息不仅是求职者的“风向标”,也是行业人才需求的“晴雨表”,本文将详细介绍如何通过爬虫技术采集阿里招聘网站的数据,包括技术原理、实现步骤、注意事项及数据分析应用,帮助读者了解从数据采集到价值挖掘的全流程。

爬虫技术原理与阿里招聘网站分析

爬虫(Web Crawler)是一种按照一定规则自动抓取互联网信息的程序,其核心流程包括:发起HTTP请求、接收服务器响应、解析HTML页面、提取目标数据、存储数据并处理分页或反爬机制,以阿里招聘官网(job.alibaba.com)为例,其岗位信息通常以动态加载或静态页面的形式呈现,需通过分析页面结构确定数据提取策略。

网站结构分析

阿里招聘的岗位列表页通常包含多个模块:职位名称、工作地点、部门名称、学历要求、工作经验、薪资范围、发布时间等,这些数据可能存在于HTML的<div>、<span>或<li>标签中,部分动态数据(如分页加载)可能通过AJAX请求获取,需进一步分析接口地址,开发者可通过浏览器开发者工具(F12)查看页面源码,定位目标数据的HTML结构,并检查Network模块中的XHR请求,找到动态数据的API接口。

爬虫技术栈选择

实现爬虫的常用技术栈包括Python的Requests库(发起HTTP请求)、BeautifulSoup库(解析HTML)、Selenium库(模拟浏览器操作,处理动态加载)以及Scrapy框架(分布式爬虫),针对阿里招聘网站,若数据为静态加载,可直接使用Requests+BeautifulSoup;若存在动态加载或反爬机制(如JavaScript渲染、验证码),需结合Selenium或Playwright模拟用户行为。

反爬机制应对

阿里招聘作为大型招聘平台,具备一定的反爬措施,包括IP限制、请求频率限制、User-Agent检测、验证码等,为避免被封禁,爬虫需采取以下策略:

- 代理IP池:使用代理IP轮换请求,避免单一IP高频访问;

- 请求头伪装:随机生成User-Agent、Referer等请求头,模拟真实浏览器;

- 请求频率控制:设置随机延时(如1-3秒),避免短时间内大量请求;

- 验证码处理:可通过第三方平台(如2Captcha)识别简单验证码,或使用Selenium模拟手动操作。

爬虫实现步骤详解

以下以Python为例,展示采集阿里招聘岗位数据的具体步骤,假设目标为获取“杭州”地区“Python开发”岗位的列表信息,包括职位名称、公司、薪资、学历等字段。

环境准备

安装必要的Python库:

pip install requests beautifulsoup4 pandas lxml

发起HTTP请求

使用Requests库获取岗位列表页的HTML内容,需设置合理的请求头:

import requests

from bs4 import BeautifulSoup

import time

import random

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36',

'Referer': 'https://job.alibaba.com/'

}

url = 'https://job.alibaba.com/zhaopinhuisu.html'

params = {

'key': 'Python开发',

'city': '杭州',

'pageSize': 20,

'currentPage': 1

}

response = requests.get(url, headers=headers, params=params, timeout=10)

if response.status_code == 200:

html = response.text

else:

print(f"请求失败,状态码:{response.status_code}")

解析HTML并提取数据

使用BeautifulSoup解析HTML,通过定位特定标签提取目标字段,岗位信息可能存在于class="job-item"的<div>标签中:

soup = BeautifulSoup(html, 'lxml')

job_list = soup.find_all('div', class_='job-item')

data = []

for job in job_list:

job_name = job.find('h3', class_='job-name').text.strip()

company = job.find('span', class_='company-name').text.strip()

salary = job.find('span', class_='salary').text.strip()

education = job.find('span', class_='education').text.strip()

experience = job.find('span', class_='experience').text.strip()

publish_time = job.find('span', class_='publish-time').text.strip()

data.append({

'职位名称': job_name,

'公司名称': company,

'薪资范围': salary,

'学历要求': education,

'工作经验': experience,

'发布时间': publish_time

})

数据存储与分页处理

将提取的数据存储为CSV或Excel文件,便于后续分析,处理分页逻辑,循环请求多页数据:

import pandas as pd

df = pd.DataFrame(data)

df.to_csv('ali_jobs_hangzhou.csv', index=False, encoding='utf-8-sig')

# 分页请求示例

total_pages = 5 # 假设总页数为5

for page in range(2, total_pages + 1):

params['currentPage'] = page

response = requests.get(url, headers=headers, params=params, timeout=10)

time.sleep(random.uniform(1, 3)) # 随机延时

# 解析并存储数据(同上步骤)

动态数据采集(可选)

若岗位详情页数据通过AJAX加载,需通过Network模块找到API接口,直接请求JSON数据。

api_url = 'https://job.alibaba.com/api/job/list'

api_params = {

'keyword': 'Python开发',

'cityCode': '530',

'pageSize': 20,

'pageNum': 1

}

api_response = requests.get(api_url, headers=headers, params=api_params)

if api_response.status_code == 200:

jobs_data = api_response.json()['data']['list']

for job in jobs_data:

print(job['jobName'], job['salary'])

数据分析与应用场景

采集到的阿里招聘数据可通过数据清洗、统计分析、可视化等手段挖掘价值,常见应用场景包括:

求职者岗位匹配分析

- 关键词提取:通过自然语言处理(NLP)技术提取岗位描述中的高频技能(如“Python”“机器学习”“Django”),帮助求职者针对性提升技能;

- 薪资趋势分析:统计不同城市、学历、工作经验下的薪资分布,为薪资谈判提供参考;

- 岗位竞争度:结合岗位发布时间与数量,分析热门岗位的竞争激烈程度。

企业招聘策略优化

- 人才需求洞察:分析阿里等头部企业的岗位需求变化,预判行业技术趋势(如AI、大数据岗位的增长);

- 薪酬竞争力评估:对比自身岗位薪资与市场平均水平,调整薪酬策略以吸引人才;

- 招聘渠道效果分析:若数据包含来源渠道,可评估不同渠道的简历质量与转化率。

行业研究报告撰写

- 人才流动趋势:通过岗位发布时间与数量变化,分析行业招聘淡旺季;

- 区域人才分布:统计不同城市的岗位数量,绘制人才热力图,为企业选址提供依据。

注意事项与法律风险

在采集招聘数据时,需严格遵守法律法规与平台规则,避免以下风险:

- 版权与隐私保护:未经授权,不得将采集到的个人简历信息(如联系方式、身份证号)用于商业用途;

- 平台协议遵守:部分网站在robots.txt中明确禁止爬虫访问,需提前检查并遵守;

- 数据使用规范:采集的数据仅可用于个人学习或行业研究,不得用于恶意竞争或非法行为。

相关问答FAQs

Q1:使用爬虫采集阿里招聘数据是否违法?

A1:需根据数据用途和采集方式判断,若仅用于个人学习、非商业分析,且未违反网站robots协议,通常不构成违法;但若用于商业用途(如出售数据、恶意竞争)或采集涉及个人隐私的信息(如简历中的联系方式),则可能侵犯平台或个人的合法权益,存在法律风险,建议在使用前咨询法律意见,并严格遵守《网络安全法》《个人信息保护法》等法规。

Q2:如何提高爬虫的稳定性和效率?

A2:可通过以下方法优化爬虫性能:①使用分布式爬虫框架(如Scrapy-Redis)实现多节点并行采集;②建立代理IP池,定期检测可用IP,避免因IP被封导致中断;③采用异步请求库(如aiohttp)提高并发效率;④设置异常重试机制(如请求失败后自动重试3次),并记录错误日志便于排查问题;⑤针对动态页面,优先分析API接口直接获取JSON数据,减少HTML解析耗时。