爬取招聘网站招聘数据是一项常见的数据采集任务,通常用于分析就业市场趋势、企业招聘需求、薪资水平等,以下是关于该任务的详细内容,包括数据采集的背景、方法、工具、注意事项及实际应用场景。

在数字化时代,招聘网站已成为企业招聘和求职者求职的重要平台,主流招聘网站如智联招聘、前程无忧、BOSS直聘等积累了海量招聘信息,包括职位名称、公司信息、薪资范围、工作地点、任职要求等,这些数据对于人力资源从业者、市场研究人员、求职者等具有重要价值,企业可以通过分析招聘数据了解行业人才需求,求职者可以把握市场动态,而研究人员则可以基于数据撰写行业报告或进行学术研究。

爬取招聘数据的第一步是明确数据需求,不同的分析目标需要采集的字段可能不同,例如基础字段包括职位名称、公司名称、薪资、工作地点、学历要求、工作经验等;扩展字段可能包括公司规模、行业类型、福利待遇、发布时间等,明确需求后,需确定数据来源,即选择目标招聘网站,需要注意的是,不同网站的数据结构和反爬机制差异较大,需针对性制定采集策略。

接下来是技术实现环节,爬取招聘数据通常使用Python编程语言,结合第三方库如Requests(用于发送HTTP请求)、BeautifulSoup(用于解析HTML)、Scrapy(用于构建爬虫框架)等,对于动态加载的网页(如通过JavaScript渲染的内容),还需使用Selenium或Playwright等工具模拟浏览器行为,以爬取某招聘网站的前10页数据为例,基本流程包括:发送请求获取网页源码、解析提取目标字段、存储数据到文件(如CSV、Excel)或数据库(如MySQL、MongoDB),使用Requests库获取网页后,可通过BeautifulSoup定位包含职位信息的HTML标签,提取文本并存储,若目标网站有反爬机制,需设置请求头(如User-Agent)、使用代理IP、添加随机延时等,避免被识别为爬虫。

在实际操作中,需注意法律法规和网站的使用条款。《中华人民共和国网络安全法》及《数据安全法》明确规定,爬取数据不得侵犯他人合法权益或违反公序良俗,部分招聘网站在用户协议中明确禁止未经授权的数据爬取,违规可能导致IP被封禁或法律风险,建议优先使用官方提供的API接口(如有),或控制爬取频率,避免对服务器造成过大压力。

数据清洗与处理是爬取后的关键步骤,原始数据常存在缺失值、重复值、格式不一致等问题,例如薪资范围可能写作“8K-15K”或“8000-15000”,需统一格式;工作地点可能包含“北京”或“北京市”,需标准化处理,还需处理异常值,如明显偏离市场范围的薪资数据,清洗后的数据可通过Pandas库进行整理和分析,例如统计各岗位的平均薪资、热门技能需求等。

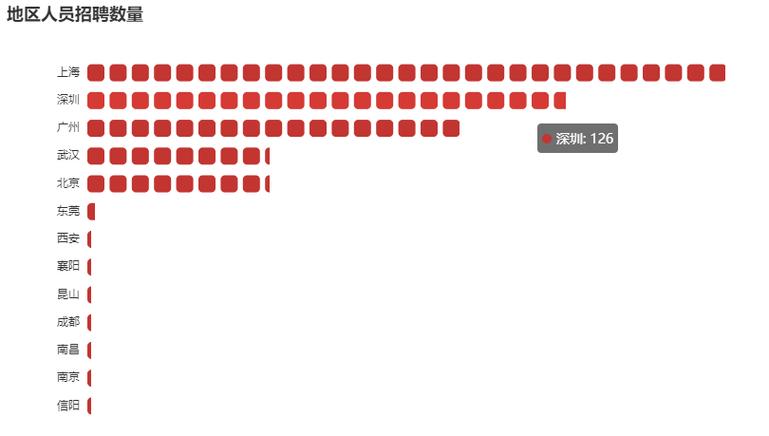

爬取的招聘数据可应用于多个场景,对企业而言,可通过分析竞争对手的招聘信息了解其人才战略;对求职者而言,可结合薪资数据和市场热度调整求职方向;对教育机构而言,可依据行业需求优化课程设置,通过分析某行业近一年的招聘数据,发现“数据分析”岗位需求同比增长30%,且Python技能要求占比达80%,这为职业培训提供了明确方向。

在工具选择上,Scrapy框架适合大规模数据爬取,支持异步请求和分布式部署;而Selenium则更适合处理复杂的动态网页,对于非技术人员,也可使用八爪鱼、火车头等可视化爬虫工具,通过配置节点实现数据采集,但灵活性和效率相对较低。

以下是一个简单的数据采集示例表格,展示爬取字段及其说明:

| 字段名称 | 说明 | 示例值 |

|---|---|---|

| 职位名称 | 招聘岗位的名称 | 数据分析师 |

| 公司名称 | 招聘企业的名称 | 阿里巴巴集团 |

| 薪资范围 | 月薪或年薪范围 | 15K-25K |

| 工作地点 | 职位所在城市 | 杭州 |

| 学历要求 | 最低学历要求 | 本科 |

| 工作经验 | 所需工作经验年限 | 3-5年 |

| 发布时间 | 职位发布日期 | 2023-10-01 |

| 福利待遇 | 公司提供的福利(如五险一金) | 五险一金、年终奖 |

爬取过程中需关注数据时效性,招聘信息可能随时间更新或失效,因此需定期采集或设置增量爬取逻辑,仅获取新增或变更的数据,数据存储时建议添加时间戳字段,便于后续分析趋势变化。

相关问答FAQs:

-

问:爬取招聘数据是否违法?如何规避法律风险?

答:爬取数据是否违法需结合目的和方式判断,若仅用于个人研究且未商业利用,且遵守网站robots协议、控制爬取频率,通常风险较低,但若用于商业用途或批量采集,可能侵犯网站权益,违反《反不正当竞争法》,建议优先使用官方API,或与网站数据服务方合作获取授权。 -

问:如何应对招聘网站的反爬机制?

答:应对反爬机制需综合采取多种措施:①设置随机User-Agent和请求头,模拟真实浏览器访问;②使用代理IP池,避免单一IP被封禁;③控制请求频率,添加随机延时(如1-3秒);④处理验证码,可通过第三方平台(如打码兔)识别;⑤对于动态网页,使用Selenium或Playwright渲染页面后再提取数据,需定期更新爬虫策略,因网站反爬机制会不断升级。