要切出网站网页代码,通常指的是获取网页的HTML、CSS、JavaScript等源代码,以便分析、学习或二次开发,以下是详细的操作步骤和方法,涵盖不同场景和工具的使用:

浏览器开发者工具(最常用方法)

几乎所有现代浏览器都内置了开发者工具,这是查看和获取网页代码的基础方法。

操作步骤:

- 打开目标网页:在浏览器中访问想要分析的网站。

- 进入开发者工具:

- Windows/Linux系统:按

F12或Ctrl+Shift+I。 - macOS系统:按

Cmd+Option+I。 - 右键点击网页任意位置,选择“检查”(Inspect)。

- Windows/Linux系统:按

- 查看代码:

- Elements(元素)面板:显示网页的HTML结构,可实时编辑并查看效果,右键点击任意元素,选择“Copy”→“Copy outerHTML”即可复制该元素的代码。

- Sources(源代码)面板:查看网页加载的所有CSS、JavaScript文件,可下载或复制文件内容。

- Network(网络)面板:记录网页请求的所有资源(如图片、API接口),可查看响应内容(部分接口可能需登录或权限)。

注意事项:动态加载的内容(如通过JavaScript渲染的数据)需在开发者工具中刷新页面或触发加载后才能完整查看。

查看网页源代码(静态HTML)

若仅需获取网页的初始HTML代码(不含动态内容),可通过以下方法:

- 浏览器菜单操作:

- Chrome/Edge:地址栏右侧点击“自定义及控制”图标(三个点)→“更多工具”→“查看网页源代码”。

- Firefox:点击“三横线”菜单→“Web开发”→“页面源代码”。

- 快捷键:

- Windows/Linux:

Ctrl+U。 - macOS:

Cmd+Option+U。

- Windows/Linux:

- 保存源代码:在源代码页面右键选择“另存为”,可将HTML文件保存到本地。

局限性:无法获取JavaScript动态生成的内容,适合分析静态网页结构。

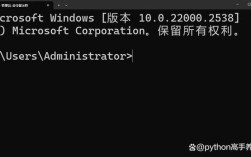

命令行工具(适合开发者)

curl(Linux/macOS/Windows 10+)

curl -s https://www.example.com > webpage.html

-s:静默模式,不显示进度信息。>:将输出重定向到HTML文件。

wget

wget -O webpage.html https://www.example.com

-O:指定保存文件名。

PowerShell(Windows)

Invoke-WebRequest -Uri https://www.example.com -OutFile webpage.html

在线工具(无需安装)

若不想使用命令行,可通过在线“网页源代码查看器”获取代码,如:

- View Source Online(https://view-source.io)

- Web Page Source Viewer(https://www.seoquake.com/source-code-viewer/)

操作步骤:输入网址,点击“查看”,即可复制或下载源代码。

编程语言获取代码(适合自动化需求)

Python示例(使用requests库)

import requests

url = "https://www.example.com"

response = requests.get(url)

if response.status_code == 200:

with open("webpage.html", "w", encoding="utf-8") as f:

f.write(response.text)

需安装库:pip install requests

JavaScript示例(Node.js)

const fs = require('fs');

const https = require('https');

https.get('https://www.example.com', (res) => {

let data = '';

res.on('data', (chunk) => data += chunk);

res.on('end', () => fs.writeFileSync('webpage.html', data));

}).on('error', (err) => console.error(err));

爬虫框架(复杂需求)

对于需要处理动态渲染、登录验证的网页,可使用爬虫框架:

- Selenium:模拟浏览器操作,支持JavaScript渲染。

- Playwright:高性能自动化工具,支持多浏览器。

示例(Selenium + Python):from selenium import webdriver driver = webdriver.Chrome() driver.get("https://www.example.com") html = driver.page_source with open("webpage.html", "w", encoding="utf-8") as f: f.write(html) driver.quit()

常见问题与注意事项

- 反爬虫机制:部分网站会限制频繁请求,需设置请求头(如

User-Agent)或使用代理IP。 - :若网页数据由JavaScript动态加载,需使用Selenium等工具等待渲染完成。

- 法律与道德:仅获取允许公开的代码,避免爬取受版权保护或私密数据。

相关问答FAQs

Q1: 为什么用浏览器查看源代码时,看不到网页上的实际内容?

A1: 这是因为网页内容可能通过JavaScript动态加载,初始源代码仅包含静态HTML结构,需在开发者工具的“Elements”面板中实时查看渲染后的内容,或使用Selenium等工具模拟浏览器行为。

Q2: 如何获取网页中所有图片的链接?

A2: 可通过以下方法:

- 手动操作:在开发者工具“Elements”面板中搜索

<img>标签,复制src属性值。 - 编程实现(Python示例):

from bs4 import BeautifulSoup import requests url = "https://www.example.com" response = requests.get(url) soup = BeautifulSoup(response.text, 'html.parser') img_tags = soup.find_all('img') for img in img_tags: print(img['src'])需安装库:

pip install beautifulsoup4 requests。