要下载网页的HTML代码,可以通过多种方法实现,具体选择取决于你的需求和技术背景,以下是几种常见且详细的操作方式,涵盖从浏览器内置工具到编程脚本的多种场景。

对于普通用户而言,最简单的方法是使用浏览器自带的开发者工具,以Chrome浏览器为例,首先打开目标网页,按下键盘上的F12键或右键点击页面选择“检查”,即可打开开发者工具,在工具界面中,切换到“Elements”(元素)选项卡,这里会显示当前页面的HTML结构,右键点击任意HTML元素,选择“Copy”(复制),然后点击“Copy outerHTML”即可复制该元素及其子元素的代码,如果需要复制整个页面的HTML,可以在“Elements”选项卡中右键点击最顶层的<html>标签,选择“Copy”→“Copy outerHTML”,但这种方法可能无法获取完整的HTML,因为部分动态加载的内容可能未包含其中,更可靠的方式是使用“Network”(网络)选项卡:在开发者工具中切换到“Network”标签,勾选“Disable cache”(禁用缓存)以确保加载最新内容,然后刷新页面,在过滤栏中输入“doc”或“html”,找到名为“document”的请求,右键点击并选择“Copy”→“Copy response”,即可获取完整的HTML源代码,许多浏览器还支持通过“保存网页”功能获取HTML:按下Ctrl+S(Windows)或Cmd+S(Mac),在弹出的对话框中选择“网页,仅HTML”格式,保存后即可得到一个包含HTML代码的.html文件,但需要注意这种方式会丢失外部CSS和JS文件引用。

对于需要批量下载或自动化处理的用户,可以使用命令行工具如curl或wget,以curl为例,打开终端或命令提示符,输入命令curl -o output.html https://example.com,其中-o参数指定输出文件名,https://example.com替换为目标网址,执行后,output.html文件将保存网页的完整HTML代码。wget的使用类似,命令为wget -O output.html https://example.com,-O参数用于指定输出文件,这两种工具支持多种参数,如添加--user-agent模拟浏览器访问,或使用--header添加自定义请求头,以应对反爬虫机制。

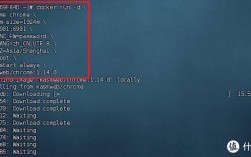

对于开发者而言,编写脚本是最灵活的方式,以Python为例,可以使用requests库获取HTML代码:首先安装库(pip install requests),然后编写脚本import requests; url = 'https://example.com'; response = requests.get(url); html_code = response.text; print(html_code),运行后即可在控制台输出HTML内容,如果需要处理JavaScript渲染的页面(如动态加载的内容),则需使用Selenium或Playwright等工具,以Selenium为例,安装库(pip install selenium)并下载对应浏览器的WebDriver,编写脚本from selenium import webdriver; driver = webdriver.Chrome(); driver.get('https://example.com'); html_code = driver.page_source; print(html_code); driver.quit(),即可获取渲染后的完整HTML,JavaScript环境(如Node.js)中,可以使用puppeteer库,通过const puppeteer = require('puppeteer'); (async () => {const browser = await puppeteer.launch(); const page = await browser.newPage(); await page.goto('https://example.com'); const html = await page.content(); console.log(html); await browser.close(); })()实现类似功能。

不同方法的适用场景如下表所示:

| 方法类型 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|

| 浏览器开发者工具 | 操作简单,无需安装工具 | 需手动操作,不适合批量处理 | 临时查看或少量下载HTML代码 |

| 浏览器保存功能 | 保留原始文件结构 | 可能丢失外部资源,无法自动化 | 离线查看网页基础内容 |

| 命令行工具 | 支持批量处理,可自定义参数 | 需要基础命令行知识,无法处理JS渲染 | 批量下载静态页面或服务器脚本 |

| 编程脚本 | 灵活度高,可处理动态内容 | 需要编程知识,配置相对复杂 | 自动化爬虫、数据抓取等场景 |

在实际操作中,需要注意遵守网站的robots.txt协议和用户条款,避免过度请求导致服务器负载,部分网站可能会通过反爬虫机制(如验证码、IP封锁)阻止HTML代码下载,此时可通过设置请求头、使用代理IP或降低请求频率等方式应对。

相关问答FAQs:

-

为什么使用浏览器开发者工具无法获取完整的HTML代码?

答:部分网页采用动态加载技术(如JavaScript异步渲染),开发者工具的“Elements”选项卡仅显示当前已渲染的DOM结构,而“Network”选项卡的“document”请求可能未包含动态加载的内容,此时需使用Selenium或Puppeteer等工具模拟浏览器行为,获取完整渲染后的HTML。 -

如何下载网页HTML代码时保留CSS和JS文件?

答:若需完整保留网页样式和功能,建议使用浏览器“保存网页”功能并选择“网页,完整”格式,这会保存HTML文件及关联的CSS、JS和图片等资源到本地文件夹,若通过编程方式,可使用requests或Selenium下载HTML后,再通过解析HTML中的<link>、<script>和<img>标签,逐一下载并替换本地路径,确保资源引用正确。 (图片来源网络,侵删)

(图片来源网络,侵删)