Hadoop Archive命令(HAR)是Hadoop生态系统中一个实用工具,主要用于解决HDFS小文件过多导致的存储效率低下和NameNode内存压力过大的问题,在分布式存储系统中,大量小文件会显著增加NameNode的元数据管理负担,因为每个文件、目录和块都需要在NameNode中存储相应的元数据信息,当小文件数量达到数百万甚至更多时,NameNode的内存消耗会急剧上升,可能导致系统性能下降甚至崩溃,HAR命令通过将多个小文件打包成一个归档文件,减少文件数量,从而优化存储和访问效率。

HAR命令的基本语法结构为hadoop archive -archiveName <归档文件名.har> -p <源路径1> [源路径2...] <目标路径>。-archiveName参数用于指定生成的归档文件名称,必须以.har作为后缀;-p参数表示源路径,可以指定一个或多个目录或文件;目标路径则是归档文件存放的位置,将/user/input目录下的所有小文件打包成名为input.har的归档文件并存放在/user/archives目录下,可以使用命令hadoop archive -archiveName input.har -p /user/input /user/archives。

HAR命令的工作原理是通过在HDFS上创建一个特殊的归档文件结构,该结构包含三个部分:_index文件、_masterindex文件和实际的归档数据块,_index文件是一个包含归档文件中所有小文件元数据的索引表,记录了每个小文件在归档数据块中的偏移量和长度;_masterindex文件则是_index文件的索引,用于快速定位_index文件中的条目;归档数据块则是将多个小文件的内容连续存储在一起的大文件,当用户访问归档文件中的某个小文件时,Hadoop会先通过_masterindex找到对应的_index条目,然后根据偏移量和长度从归档数据块中提取数据,最终还原成原始的小文件。

HAR命令的优势在于显著减少了文件数量,从而降低了NameNode的元数据负载,如果有10000个每个大小为1MB的小文件,直接存储在HDFS上会产生10000个文件条目;而将这些文件打包成一个归档文件后,文件条目数量减少到3个(_index、_masterindex和归档数据块),大幅降低了NameNode的内存占用,归档文件仍然支持标准的HDFS API操作,用户可以通过hadoop fs -ls har://<路径>或hadoop fs -cat har://<路径>等命令访问归档文件中的内容,无需修改现有应用程序。

HAR命令也存在一些局限性,归档文件的创建过程需要消耗额外的计算和I/O资源,尤其是在处理大量小文件时,可能会对集群性能产生短暂影响,归档文件不支持文件级别的追加和修改操作,一旦创建完成,无法直接向归档文件中添加或删除文件,必须重新创建整个归档文件,归档文件的访问延迟略高于直接访问HDFS文件,因为需要额外的索引查询步骤,但对于批量读取操作,这种延迟通常可以忽略不计。

为了更好地使用HAR命令,用户需要注意以下几点:一是确保归档文件的名称以.har否则Hadoop无法正确识别归档文件格式;二是源路径可以是多个目录或文件,但目标路径必须是一个不存在的目录或HDFS上的有效路径;三是归档文件创建完成后,原始文件不会被自动删除,用户需要手动清理以释放存储空间;四是归档文件不支持HDFS的快照功能,因此在对归档文件进行操作前,建议先创建快照以防止数据丢失。

以下是一个使用HAR命令的示例场景:假设某HDFS集群中有一个/user/logs目录,包含100000个日志文件,每个文件大小为10KB,直接存储这些文件会导致NameNode内存压力过大,使用HAR命令将这些文件打包成logs.har归档文件,步骤如下:首先执行hadoop archive -archiveName logs.har -p /user/logs /user/archives命令,等待归档文件创建完成;然后通过hadoop fs -ls har:///user/archives/logs.har查看归档文件内容;最后确认无误后,手动删除原始的/user/logs目录以释放空间,归档完成后,文件数量从100000减少到3个,NameNode的元数据负载显著降低。

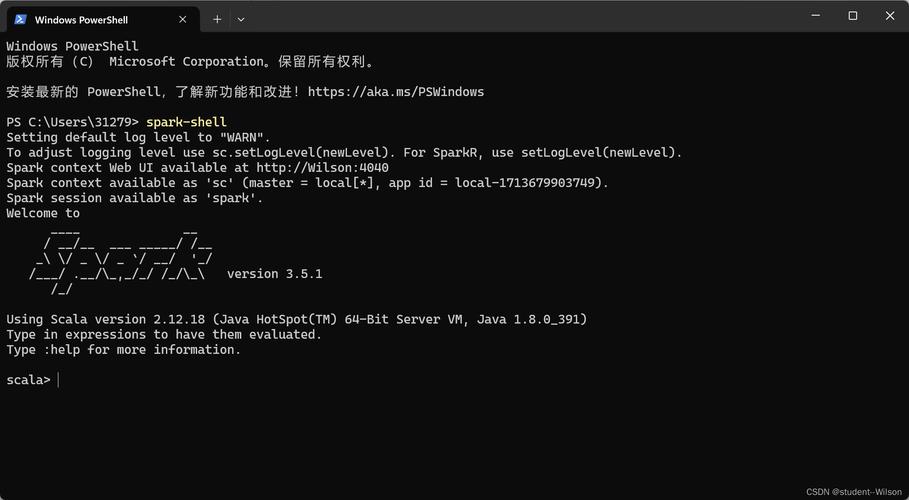

归档文件的访问方式与普通HDFS文件类似,但需要使用har://协议前缀,访问归档文件中的某个文件example.log,可以使用命令hadoop fs -cat har:///user/archives/logs.har/example.log,在应用程序中,可以通过FileSystem API的getHarFileSystem方法获取归档文件的文件系统实例,从而实现程序化访问,在Java代码中,可以使用以下代码片段访问归档文件:

Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(conf);

FileSystem harFs = new HarFileSystem(fs);

harFs.initialize(new URI("har:///user/archives/logs.har"), conf);

FSDataInputStream in = harFs.open(new Path("example.log"));

// 读取文件内容

in.close();

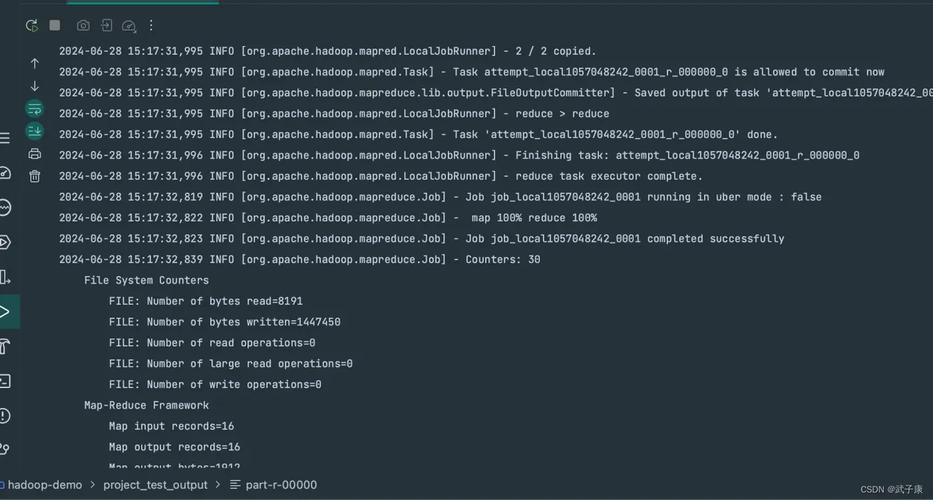

归档文件的性能优化也是一个重要考虑因素,在创建归档文件时,可以通过调整mapreduce.job.maps参数来控制MapTask的数量,以优化归档过程的并行度,归档文件的大小也会影响访问性能,通常建议单个归档文件的大小不超过HDFS块大小(如128MB或256MB)的整数倍,以减少数据读取时的寻址开销,对于频繁访问的小文件,可以考虑将其缓存在内存中,以提高访问速度。

归档文件的管理和维护同样重要,用户可以定期检查归档文件的完整性,通过hadoop fs -checksum命令验证归档数据块和索引文件的校验和是否一致,如果发现损坏,可以尝试重新创建归档文件,归档文件不支持HDFS的回收站功能,因此在删除归档文件时需要谨慎操作,避免误删重要数据。

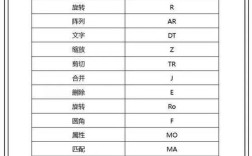

以下表格总结了HAR命令的主要参数及其作用:

| 参数 | 描述 | 示例 |

|---|---|---|

| -archiveName | 指定归档文件名称,必须以.har结尾 | -archiveName input.har |

| -p | 指定源路径,可以是一个或多个文件或目录 | -p /user/input /user/data |

| 目标路径 | 归档文件存放的HDFS路径 | /user/archives |

相关问答FAQs:

-

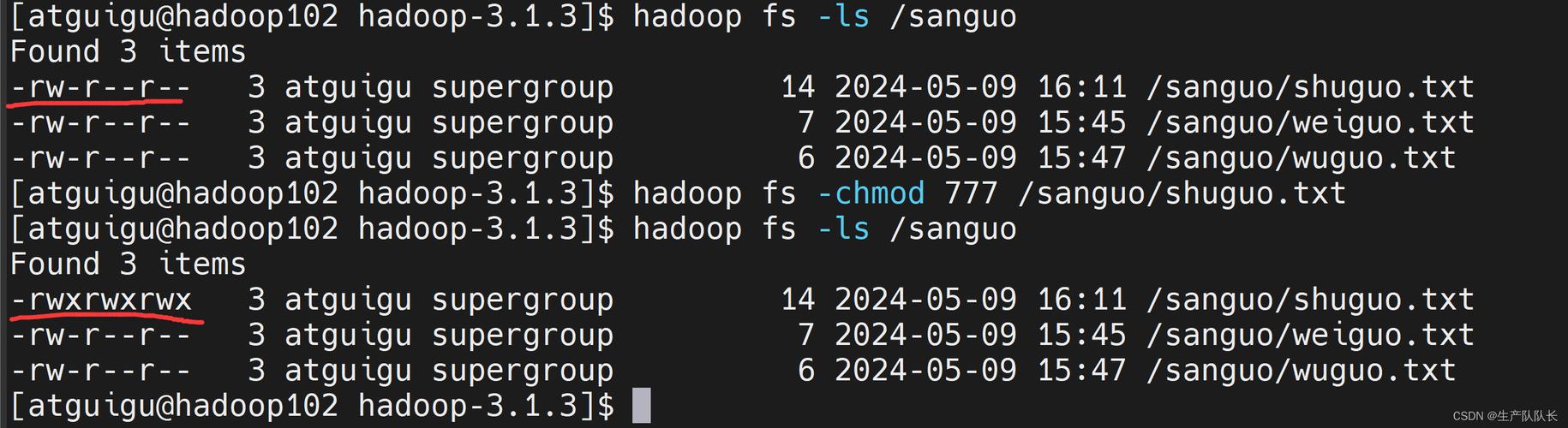

问:HAR命令创建的归档文件是否可以像普通HDFS文件一样进行权限管理?

答:是的,HAR命令创建的归档文件继承HDFS的权限管理机制,可以通过hadoop fs -chmod、hadoop fs -chown等命令修改归档文件及其内部文件的权限和所有者,修改归档文件内部文件的权限需要先通过har://协议访问该文件,例如hadoop fs -chmod 755 har:///user/archives/logs.har/example.log。 -

问:如何将归档文件解压回普通的HDFS文件?

答:Hadoop没有直接提供归档文件的解压命令,但可以通过hadoop fs -cp命令将归档文件中的内容复制到普通HDFS目录中实现解压,将logs.har中的所有文件解压到/user/extracted_logs目录,可以使用命令hadoop fs -cp har:///user/archives/logs.har/* /user/extracted_logs,也可以编写自定义程序遍历归档文件中的所有文件并逐个复制到目标目录。