在Hadoop生态系统中,压缩是优化存储空间和提升数据处理效率的重要手段,通过压缩技术,可以显著减少HDFS上的数据占用,同时降低网络传输开销,从而加速MapReduce、Spark等计算框架的任务执行,Hadoop支持多种压缩算法,如Gzip、Bzip2、LZO、Snappy等,每种算法在压缩率、压缩速度和解压速度上各有侧重,用户可根据实际场景选择合适的压缩方式,以下将详细介绍Hadoop中的常用压缩命令及其使用方法。

常用压缩命令与工具

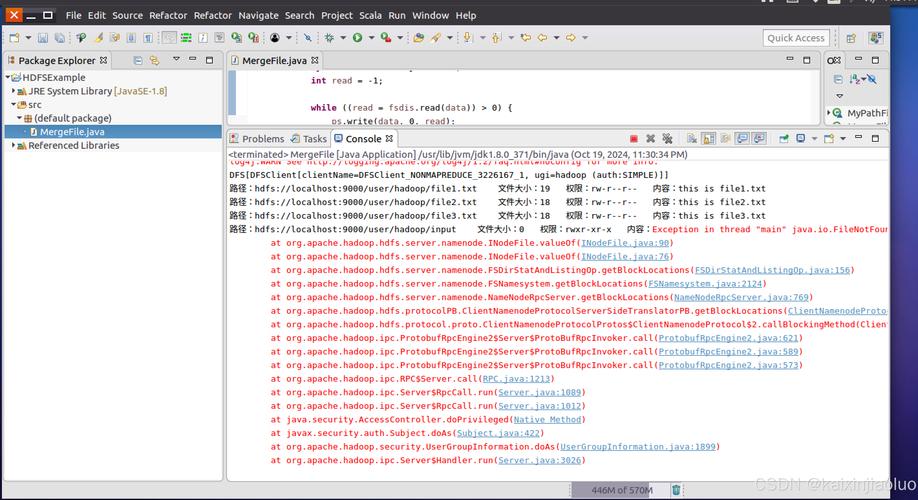

Hadoop提供了命令行工具(如hadoop jar)和API接口支持数据压缩,对于文件级别的压缩,可通过Linux系统工具或Hadoop内置命令实现,使用Gzip压缩文件时,可通过gzip -r input_dir命令递归压缩目录,解压则用gunzip -d file.gz,若需在Hadoop分布式文件系统(HDFS)上直接压缩文件,可执行hadoop fs -put local_file.txt hdfs_path/file.txt.gz,但此时需确保文件已通过Gzip工具压缩,对于MapReduce任务的中间结果压缩,可通过配置mapreduce.map.output.compress和mapreduce.map.output.compress.codec参数启用,例如设置压缩编解码器为org.apache.hadoop.io.compress.SnappyCodec以提升压缩速度。

压缩格式选择与性能对比

不同压缩格式的适用场景差异较大,以下是常见压缩格式的性能对比:

| 压缩格式 | 压缩率 | 压缩速度 | 解压速度 | 适用场景 |

|---|---|---|---|---|

| Gzip | 高 | 中 | 中 | 归档存储,最终输出 |

| Bzip2 | 很高 | 慢 | 慢 | 对压缩率要求极高场景 |

| LZO | 中 | 快 | 很快 | 中间数据压缩,实时处理 |

| Snappy | 低 | 很快 | 很快 | 内存缓存,实时交互 |

在MapReduce任务中,若中间数据需频繁读写,推荐使用Snappy或LZO,以减少I/O等待时间;而对于长期存储的最终结果,Gzip或Bzip2能更节省磁盘空间。

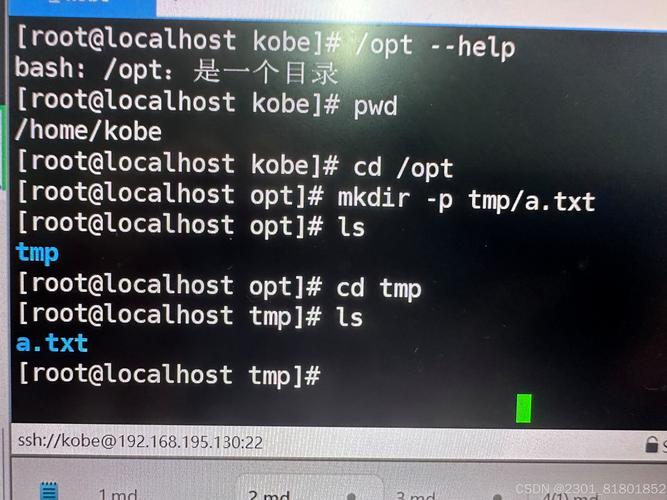

压缩命令实操示例

-

本地文件压缩:

压缩:hadoop fs -put -p local_file.txt hdfs_path/file.txt.gz

(需确保本地文件已通过gzip命令压缩为.gz格式)

解压:hadoop fs -cat hdfs_path/file.txt.gz | gunzip > local_file.txt (图片来源网络,侵删)

(图片来源网络,侵删) -

MapReduce任务启用压缩:

在mapred-site.xml中配置:<property> <name>mapreduce.map.output.compress</name> <value>true</value> </property> <property> <name>mapreduce.map.output.compress.codec</name> <value>org.apache.hadoop.io.compress.LzoCodec</value> </property> -

Hive表压缩:

创建表时指定压缩格式:CREATE TABLE compressed_table (id INT, name STRING) STORED AS ORCFILE TBLPROPERTIES ("orc.compress"="SNAPPY");

相关问答FAQs

Q1: 如何在Hadoop中动态选择压缩格式?

A1: 可通过Java API动态设置压缩编解码器,在MapReduce的Job配置中,通过job.getConfiguration().setClass("mapreduce.map.output.compress.codec", SnappyCodec.class, CompressionCodec.class)实时指定压缩格式,或根据文件扩展名匹配对应的Codec实现。

Q2: 压缩后文件为何无法直接用文本编辑器打开?

A2: 压缩文件(如.gz、.lzo)是二进制格式,需通过专用工具解压才能查看内容,使用hadoop fs -cat file.gz | zcat或gunzip命令解压后,方可查看原始文本数据,若需直接处理压缩文件,可通过Hadoop提供的CompressionInputStream类读取压缩流,避免全量解压。