要准确找出文本中的分词结果,需要结合自然语言处理(NLP)中的分词技术、工具和算法原理,分词是将连续的文本序列切分为具有独立语义的词汇单元的过程,是中文NLP的基础任务之一,以下是详细的方法和步骤,涵盖从基础概念到实际应用的完整流程。

理解分词的基本原理

分词的核心是识别文本中的词边界,中文由于没有像英文那样的天然空格分隔,分词难度较大,常见的分词方法包括基于规则、基于统计和基于深度学习三类:

- 基于规则的分词:通过词典匹配和人工规则(如最大匹配法)进行分词,优点是速度快,缺点是对新词和歧义词处理能力弱。

- 基于统计的分词:利用大规模语料库训练统计模型(如隐马尔可夫模型HMM、条件随机场CRF),通过计算词的出现概率和上下文关联性进行分词,适应性强但需要大量训练数据。

- 基于深度学习的分词:采用循环神经网络(RNN)、Transformer等模型,通过端到端学习自动提取特征,分词精度高,但对算力和数据量要求较高。

选择合适的分词工具

实际应用中,可直接使用成熟的分词工具,无需从零实现,以下是常用工具及其特点:

| 工具名称 | 开发方 | 技术原理 | 适用场景 | 优势 |

|---|---|---|---|---|

| Jieba | 中文NLP社区 | 基于前缀词典+HMM | 通用中文分词 | 轻量级、支持自定义词典 |

| HanLP | HanLP团队 | 基于CRF+深度学习 | 学术研究、企业级应用 | 多语言支持、功能全面(分词、NER等) |

| LTP | 哈工大社会计算实验室 | 基于深度学习(BiLSTM+CRF) | 高精度分词任务 | 支持多种NLP任务联动 |

| THULAC | 清华大学 | 基于结构化感知机 | 中文分词与词性标注一体化 | 处理速度快、准确率高 |

| spaCy | 英文社区 | 基于深度学习 | 多语言(包括中文)处理 | 工业级性能、支持Pipeline |

示例:使用Jieba进行分词

import jieba

text = "自然语言处理是人工智能的重要分支"

seg_list = jieba.cut(text, cut_all=False) # 精确模式

print("/".join(seg_list))

# 输出:自然语言/处理/是/人工智能/的/重要/分支

自定义分词场景优化

通用工具可能无法满足特定领域的需求(如医疗、法律文本),需通过以下方式优化:

- 添加专业词典:向工具中导入领域术语,提高新词识别率,在Jieba中可通过

jieba.load_userdict("domain_dict.txt")加载自定义词典。 - 调整分词粒度:根据需求选择细分或粗分模式。

- 细分模式:将“北京大学”切分为“北京/大学”。

- 粗分模式:保留“北京大学”作为一个完整词。

- 处理歧义词:通过上下文规则或模型消除歧义。“发展中国家”在“经济/发展中国家”中应整体切分,而非“发展/中国/家”。

评估分词结果准确性

分词后需验证结果是否符合预期,常用评估指标包括:

- 精确率(Precision):正确切分的词数 / 总切分词数。

- 召回率(Recall):正确切分的词数 / 应切分词数。

- F1值:精确率和召回率的调和平均数。

可通过人工标注的测试集对比工具输出结果,计算上述指标,使用jieba.analyse模块或第三方库如seqeval进行评估。

分词中的常见问题及解决方法

- 新词识别问题:如“元宇宙”“碳中和”等未登录词(OOV)可能被错误切分。

- 解决方案:定期更新词典,或使用支持新词发现的工具(如HanLP的

new_word discovery功能)。

- 解决方案:定期更新词典,或使用支持新词发现的工具(如HanLP的

- 未登录词(OOV)处理:专有名词、网络流行语等可能被拆分。

解决方案:结合命名实体识别(NER)技术,对专有名词进行保护性切分。

- 混合文本分词:中英文混合(如“AI技术”)或含数字、符号的文本(如“CPU性能提升20%”)。

解决方案:使用支持多模态分词的工具(如spaCy),或预处理文本统一格式。

分词技术的进阶应用

- 词性标注与分词联合模型:如LTP和THULAC可在分词同时输出词性,提升文本理解效率。

- 上下文感知分词:利用BERT等预训练模型,通过上下文动态调整切分结果。

“这个项目很有潜力”中,“潜力”作为名词整体保留;而“潜力无限”中,“潜力”与“无限”可能被切分。

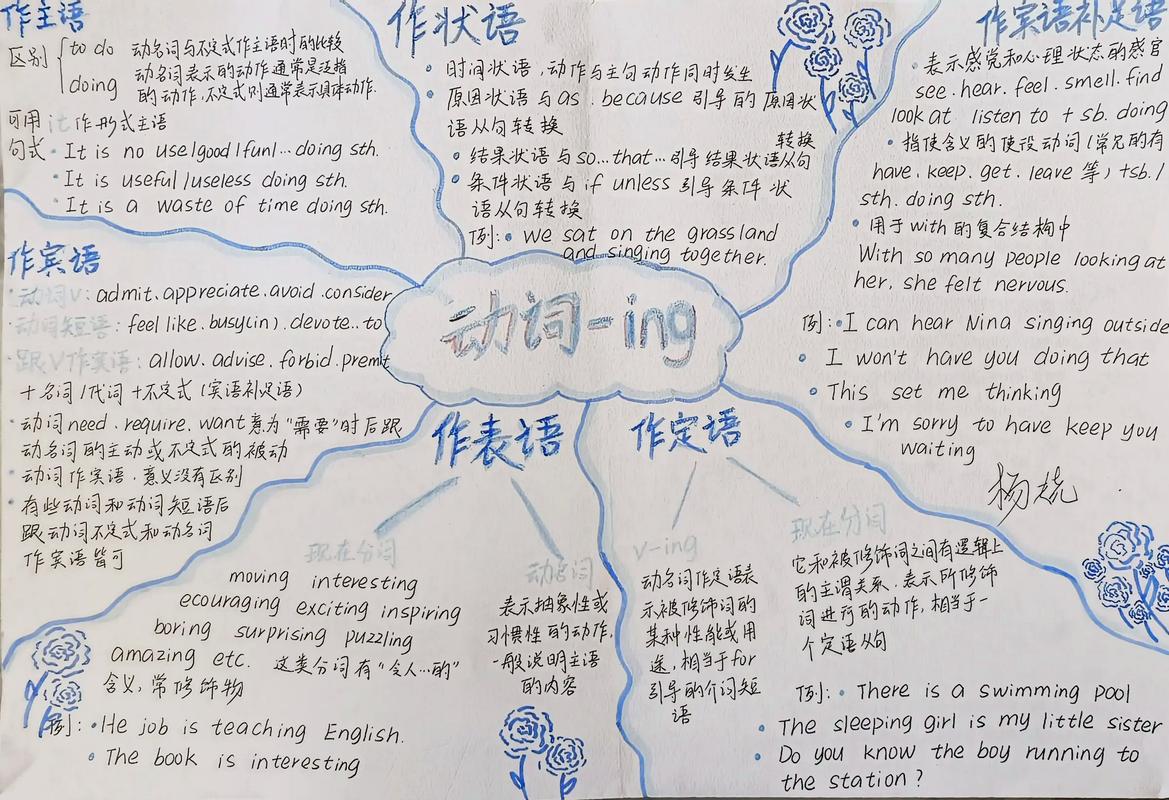

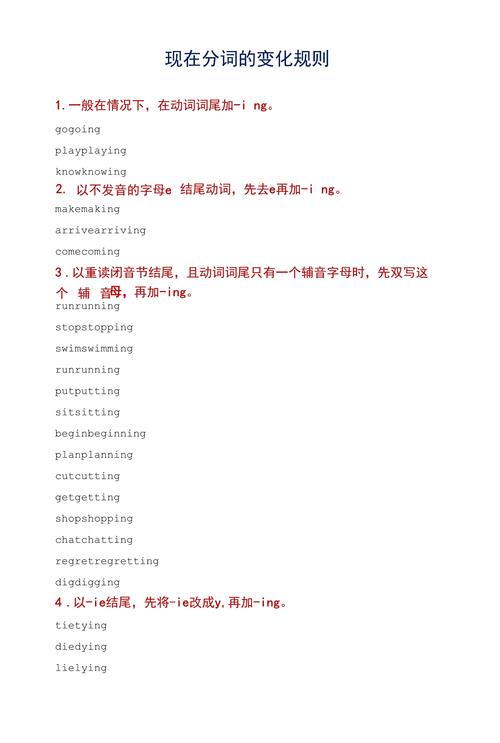

(图片来源网络,侵删)

(图片来源网络,侵删) - 分布式分词系统:对于大规模文本(如亿级语料),可采用分布式计算框架(如Spark)加速分词处理。

实践步骤总结

- 明确需求:确定分词粒度、领域类型和精度要求。

- 选择工具:根据需求从上述工具中挑选,优先考虑开源生态和社区支持。

- 数据预处理:清洗文本(去除特殊字符、统一编码),必要时进行分块处理。

- 模型训练/调参:若使用深度学习工具,需准备标注数据集并调整超参数。

- 结果验证:通过人工抽样或自动化评估检查分词质量。

- 部署优化:将分词模块集成到实际应用中,监控并持续优化性能。

相关问答FAQs

Q1: 如何处理分词中的未登录词(OOV)问题?

A: 未登录词是指词典中未收录的新词或专有名词,可通过以下方法解决:

- 动态更新词典:定期从语料库中提取新词(如使用互信息、左右熵等算法),添加到工具词典中。

- 结合命名实体识别(NER):先识别专有名词(如人名、机构名),再对这些实体进行整体切分。

- 使用支持OOV的模型:基于字符的深度学习模型(如BiLSTM-CRF)能通过字符组合推断新词,减少对词典的依赖,HanLP和LTP均内置新词发现功能。

Q2: 如何判断分词结果的合理性?

A: 分词结果的合理性需结合语言学规则和任务需求综合判断:

- 语言学验证:检查切分后的词是否具有独立语义,是否符合语法结构。“乒乓球拍卖完了”应切分为“乒乓球/拍卖/完了”而非“乒乓/球拍/卖/完了”。

- 任务导向验证:根据下游任务(如情感分析、机器翻译)评估分词对任务效果的影响,情感分析中“不/好”和“不好”的切分可能导致情感极性相反。

- 数据驱动验证:通过人工标注的测试集计算精确率、召回率等指标,或使用交叉验证对比不同工具的输出结果,F1值高于0.95通常视为高质量分词。