阿里Hadoop招聘涉及多个技术方向和岗位需求,涵盖大数据生态系统的开发、运维、优化及业务落地等环节,随着企业数字化转型的深入,阿里对Hadoop技术人才的要求不仅包括扎实的理论基础,更强调实际工程能力和业务场景适配能力,以下从岗位方向、技能要求、招聘流程及职业发展等方面展开分析。

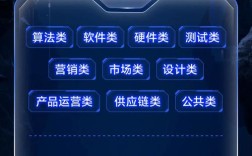

核心岗位方向与技术栈

阿里Hadoop相关岗位主要分为技术研发、数据工程、大数据运维三大类,具体职责和技术栈差异显著:

大数据开发工程师

核心职责:负责Hadoop生态组件(如HDFS、MapReduce、YARN)的二次开发与优化,设计分布式数据处理架构,支撑海量离线/实时数据计算场景。

技术栈要求:

- 熟练掌握Java/Scala编程,理解JVM原理及多线程并发编程;

- 深入理解Hadoop核心组件原理,具备源码级阅读和调试能力;

- 熟悉Hive、Spark、Flink等计算引擎,能结合业务场景优化SQL执行计划或流处理任务;

- 掌握数据分区、索引、压缩等性能调优手段,熟悉PB级数据处理经验者优先。

数据平台工程师

核心职责:构建企业级数据中台,设计数据模型(如维度建模),开发ETL工具链,保障数据从采集到分发的全链路稳定性。

技术栈要求:

- 熟悉Kafka、Flume等数据采集工具,具备高并发数据管道设计经验;

- 掌握Hive数据仓库设计,能通过HQL/Spark SQL实现复杂指标计算;

- 了解数据治理工具(如Atlas、DataHub),具备元数据管理、数据质量监控实践经验;

- 熟悉阿里云EMR、MaxCompute等云原生大数据平台者优先。

大数据运维工程师

核心职责:负责Hadoop集群的部署、监控、扩容及故障处理,保障集群高可用性与资源利用率。

技术栈要求:

- 熟悉Linux系统管理,掌握Shell/Python脚本开发;

- 深入理解Hadoop集群架构(如NameNode HA、ResourceManager联邦),能定位并解决OOM、DataNode掉线等典型问题;

- 熟悉ZooKeeper、Kerberos等组件的运维配置,具备容器化(Docker/K8s)部署经验;

- 了解阿里云ACK、E-MapReduce等云服务运维模式者优先。

招聘流程与能力评估

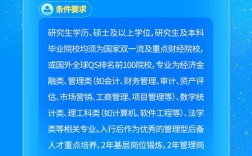

阿里Hadoop岗位招聘通常包含简历初筛、技术面试、业务面试及HR面试四个环节,重点考察以下能力:

简历初筛

关键词聚焦:Hadoop生态组件掌握程度、项目经验规模(如数据量、集群规模)、技术深度(如源码阅读、性能调优案例),候选人需明确描述在项目中如何通过调整MapReduce任务数或Hive存储格式将计算效率提升30%以上。

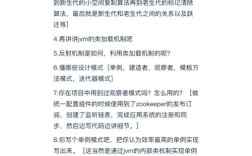

技术面试

- 基础能力:考察计算机网络、操作系统、数据结构等基础知识,HDFS读写流程”“YARN资源调度机制”;

- 场景题:结合实际业务场景设计解决方案,如“设计每日10TB日志的实时分析架构,需考虑延迟与成本平衡”;

- 代码能力:现场编写MapReduce程序实现TopK算法,或优化Spark SQL执行计划。

业务面试

评估候选人业务理解能力,如何通过大数据分析提升电商用户复购率”,需结合Hadoop技术栈给出数据采集、特征工程、模型训练的全链路方案。

HR面试

关注职业规划与团队适配性,未来3年技术发展方向”“对阿里‘中台战略’的理解”。

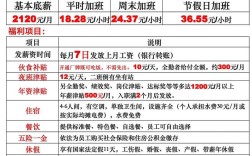

职业发展与薪酬竞争力

阿里为Hadoop技术人才提供清晰的晋升路径:初级工程师→高级工程师→技术专家→架构师,薪酬方面,根据2023年市场数据,阿里大数据开发工程师应届生起薪约20-35K/月,3年经验可达40-60K/月,技术专家级别年薪百万以上,阿里内部提供“技术双通道”晋升机制,可通过技术管理或专业路线发展,并参与双十一、双11等超大规模数据处理项目积累实战经验。

相关问答FAQs

Q1:非科班出身,自学Hadoop能否进入阿里?

A:可以,阿里更看重实际技术能力而非学历背景,建议通过以下方式提升竞争力:①系统学习Hadoop生态组件原理,完成至少2个实战项目(如搭建PB级数据集群、开发实时推荐系统);②参与开源社区贡献(如提交Hadoop bug修复或文档优化);③在GitHub上传技术博客或代码案例,展示解决问题的思路,非科班候选人需在面试中突出项目经验和技术深度,弥补理论基础的不足。

Q2:阿里Hadoop岗位与互联网公司其他大数据岗位有何区别?

A:阿里Hadoop岗位更侧重“大规模工程化落地”与“业务场景驱动”,区别于中小公司的“工具使用”,阿里要求候选人具备从0到1设计数据平台的能力,同时需熟悉阿里云大数据服务(如EMR、OSS)的混合云架构,阿里业务场景复杂(电商、金融、物流等),要求技术方案兼顾性能、成本与合规性,例如需通过HBase实现毫秒级查询的同时满足数据安全审计要求。