要查看百度蜘蛛的爬行情况,可以通过多种工具和方法实现,这些方式既能帮助网站管理员了解蜘蛛的访问频率、抓取路径,也能辅助分析网站的健康状况和索引问题,以下从工具推荐、具体操作步骤、数据解读及注意事项等方面展开详细说明。

常用工具及使用方法

百度站长平台

百度站长平台是官方提供的核心工具,能直接展示百度蜘蛛的爬行数据,操作步骤如下:

- 登录平台:进入百度站长平台(https://ziyuan.baidu.com/),绑定已验证的网站。

- 查看爬取统计:在“数据监控”或“索引量”菜单中找到“爬取统计”板块,系统会展示近30天的抓取频次、抓取量、下载量等数据,抓取频次”指百度蜘蛛每天访问网站的次数,“抓取量”为蜘蛛每天下载的数据总量(单位为KB)。

- 抓取诊断:通过“抓取诊断”功能,可输入具体URL查看百度蜘蛛的抓取状态,包括成功、失败(如404、500错误)或拒绝抓取的原因,帮助定位页面问题。

服务器日志分析

服务器日志记录了所有访问请求,包括百度蜘蛛的访问轨迹,需通过以下步骤操作:

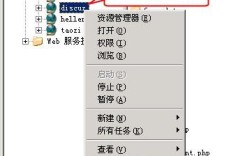

- 获取日志文件:登录服务器(如使用Linux系统),通常日志文件位于

/var/log/nginx/(Nginx)或/var/log/httpd/(Apache)目录,文件名如access.log。 - 筛选百度蜘蛛UA:使用命令行工具过滤百度蜘蛛的User-Agent(如

Baiduspider+),在Linux中执行命令:grep 'Baiduspider+' /var/log/nginx/access.log > baiduspider_log.txt,将百度蜘蛛的日志提取至单独文件。 - 分析日志内容:通过工具(如AWStats、GoAccess)或脚本分析日志,提取关键信息:访问时间、请求URL、响应状态码(200表示成功,404表示页面不存在)、抓取间隔等,若某URL频繁返回404,需检查页面是否被误删或路径错误。

第三方SEO工具

部分第三方工具提供百度蜘蛛监控功能,适合不熟悉技术操作的用户:

- 站长工具(如5118、爱站):输入域名后,在“蜘蛛池”或“抓取分析”板块查看百度蜘蛛的最近访问时间、抓取量及趋势对比。

- SEO浏览器插件:如“站长之家SEO”插件,在浏览器中访问页面时,可实时显示该页面的百度蜘蛛抓取状态及历史数据。

网站日志分析工具

为更直观展示日志分析结果,可参考以下表格对比不同工具的特点:

| 工具名称 | 优势 | 适用场景 | 局限性 |

|---|---|---|---|

| 百度站长平台 | 官方数据,权威且实时 | 日常监控抓取量、诊断页面问题 | 需绑定网站,部分高级功能需申请 |

| 服务器日志 | 数据最原始,可自定义分析维度 | 深度技术分析,排查抓取异常 | 需一定技术基础,手动处理较繁琐 |

| 第三方SEO工具 | 操作简便,提供趋势对比和竞品数据 | 快速了解抓取概况,新手友好 | 数据可能存在延迟,非官方来源 |

| 日志分析软件 | 支持可视化图表,生成统计报告 | 大量日志数据处理,长期趋势分析 | 部分软件需付费,配置较复杂 |

数据解读与优化建议

- 抓取频次过低:若百度蜘蛛每日抓取次数少于10次(尤其对新站),需检查网站robots.txt是否禁止抓取,或网站是否存在大量死链、打开速度慢(建议加载时间<3秒)等问题。

- 抓取量异常波动:某天抓取量骤增可能是蜘蛛在集中抓取新内容,骤减则需警惕网站是否被降权或出现服务器宕机,可通过“抓取诊断”确认页面可访问性。

- 抓取间隔过长:若蜘蛛对重要页面(如首页、分类页)的抓取间隔超过7天,需提升内容更新频率,或通过“主动推送”功能向百度提交新URL(站长平台“索引提交”菜单中操作)。

注意事项

- 区分蜘蛛类型:百度蜘蛛包括PC端(

Baiduspider+)、移动端(Baiduspider-mobile)及图片蜘蛛(Baiduspider-image),需根据网站类型重点监控对应蜘蛛的数据。 - 避免过度优化:频繁主动推送或生成大量低质量页面可能导致蜘蛛抓取效率下降,建议保持内容原创性,合理更新频率(如每日1-2篇高质量文章)。

- 定期检查robots.txt:确保该文件未误屏蔽重要目录(如或

/article/),可通过站长平台“robots.txt检测”工具验证语法正确性。

相关问答FAQs

问题1:为什么百度蜘蛛每天只抓取首页,不抓取内页?

解答:通常内页抓取量少的原因包括:内页存在大量重复内容、内链结构混乱(蜘蛛无法从首页导航到内页)、或内页打开速度过慢,建议优化内链锚文本(如使用相关文章推荐)、检查内页是否被robots.txt禁止,并通过主动推送功能提交内页URL。

问题2:服务器日志显示百度蜘蛛抓取返回403错误,如何解决?

解答:403错误表示服务器禁止访问,可能原因包括:IP被防火墙拦截、目录权限设置错误(如目录未开启读取权限)、或UA被误判为恶意爬虫,需检查服务器的安全组规则,确保百度蜘蛛的IP段(如123.125.66.0/24)未被屏蔽;同时确认网站根目录的index.html或index.php文件存在且有执行权限,若问题持续,可联系服务器技术支持排查。