随着大数据技术的飞速发展,Hadoop作为分布式计算和存储的核心框架,已成为企业数据处理的重要基础设施,上海作为中国的经济中心和科技创新高地,聚集了大量互联网、金融、物流等行业的企业,对Hadoop相关人才的需求持续旺盛,本文将围绕Hadoop在上海的招聘市场现状、岗位要求、技能需求及职业发展路径进行详细分析,为求职者提供参考。

在上海,Hadoop岗位主要集中在互联网巨头、金融机构、电商平台、科技公司以及传统企业的数字化转型部门,这些企业通常面临海量数据存储、实时数据处理、数据挖掘分析等需求,因此需要熟练掌握Hadoop生态系统的技术人才,从招聘平台的数据来看,Hadoop相关岗位包括Hadoop开发工程师、大数据开发工程师、数据工程师、数据平台架构师等,薪资水平根据经验和技能差异较大,初级岗位年薪一般在15万-25万元,资深岗位可达40万-80万元,部分管理或架构师岗位甚至更高。

岗位要求方面,Hadoop开发工程师通常需要具备扎实的Java编程基础,熟悉Hadoop核心组件如HDFS、MapReduce、YARN的原理与使用,同时掌握Hive、HBase、Spark、Flink等生态工具,对于大数据开发工程师,除了Hadoop技术栈,还需具备数据清洗、ETL流程设计、数据建模能力,熟悉SQL和Python等数据分析工具,数据平台架构师则更侧重系统设计能力,需要具备大规模分布式系统的架构经验,熟悉高可用、高并发场景下的性能优化,同时了解云原生大数据技术如AWS EMR、阿里云MaxCompute等,企业普遍要求求职者具备良好的问题解决能力和团队协作精神,部分金融或电商企业还会对数据安全、隐私保护提出额外要求。

技能需求上,除了传统的Hadoop生态技术,上海企业对新兴技术的融合应用也越来越重视,Spark Streaming、Flink等实时计算框架已成为许多岗位的加分项;Kafka、Pulsar等消息队列工具在实时数据管道构建中的应用需求增长;容器化技术Docker和Kubernetes在大数据集群部署中的使用逐渐普及;机器学习与大数据的结合,如使用Spark MLlib进行数据建模,也成为高级岗位的重要技能,熟悉云平台的大数据服务(如AWS、阿里云、腾讯云)的求职者更受青睐,尤其是混合云和多云架构设计经验。

职业发展路径方面,Hadoop技术人才通常可以从初级开发工程师起步,积累项目经验后向高级开发工程师、技术专家或团队管理方向发展,对于有架构设计兴趣的人才,可以转向数据平台架构师或大数据解决方案架构师岗位;对数据分析感兴趣的人才,则可深入数据挖掘、机器学习领域,成为数据科学家,在上海,随着企业数字化转型的深入,具备跨领域知识(如金融风控、电商推荐系统、智慧物流)的复合型Hadoop人才更具竞争力,职业发展空间也更广阔。

以下为Hadoop相关岗位技能需求概览:

| 技能类别 | 核心技能点 | 岗位相关性 |

|---|---|---|

| 编程语言 | Java(必备)、Python、Scala | 高 |

| Hadoop生态 | HDFS、MapReduce、YARN、Hive、HBase、Spark、Flink | 高 |

| 实时计算 | Kafka、Spark Streaming、Flink、Storm | 中高 |

| 数据工具 | Sqoop、Flume、Oozie、ZooKeeper | 中 |

| 数据库/仓库 | MySQL、PostgreSQL、MongoDB、数据建模 | 中高 |

| 云与容器化 | AWS/阿里云/腾讯云大数据服务、Docker、Kubernetes | 中 |

| 机器学习 | Spark MLlib、TensorFlow、PyTorch(数据建模方向) | 低中 |

| 软技能 | 问题解决、团队协作、文档编写、系统设计 | 高 |

针对Hadoop在上海的求职,建议求职者首先夯实Java和Hadoop核心基础,通过实际项目(如搭建Hadoop集群、开发数据处理任务)积累经验;根据目标岗位方向(如实时计算、数据仓库、机器学习)深入学习相关生态工具;关注行业动态,学习云原生和大数据融合技术,提升竞争力,准备面试时需重点梳理项目中的技术难点和解决方案,熟悉常见面试题(如HDFS读写流程、MapReduce优化、Hive调优等),并关注企业业务场景,展现将技术应用于实际问题的能力。

相关问答FAQs:

-

问:没有Hadoop项目经验,如何入门并找到相关工作?

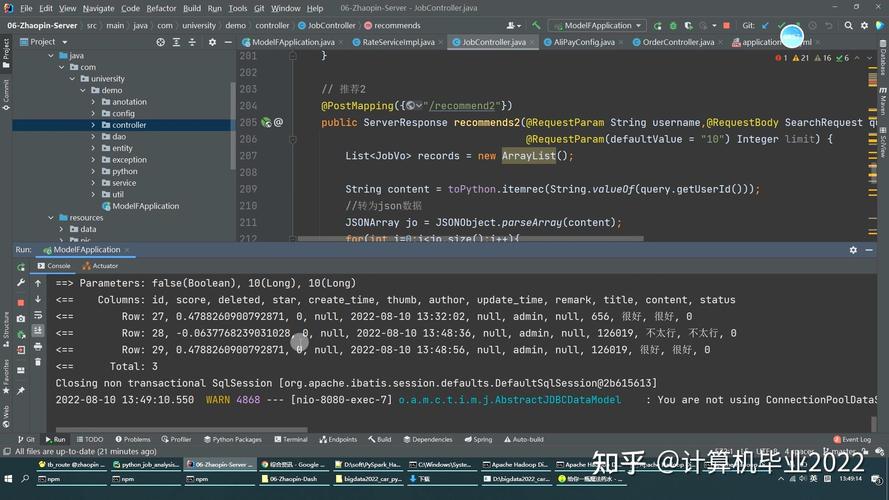

答:对于没有项目经验的求职者,可通过以下方式入门:通过在线课程(如Coursera、慕课网)学习Hadoop基础理论,搭建本地虚拟机环境(如Cloudera Quickstart VM)进行实践;参与开源项目(如Apache Hadoop、Spark的GitHub仓库)或复现公开数据集(如Kaggle)的处理任务,积累项目经验;在简历中突出学习能力和技术实践,例如描述自学完成的Hadoop集群搭建、数据处理脚本开发等,并针对初级岗位强调编程基础和问题解决潜力,可考虑从数据分析师、ETL开发等与数据相关的岗位切入,逐步转向Hadoop开发方向。 (图片来源网络,侵删)

(图片来源网络,侵删) -

问:上海Hadoop岗位对学历和学历要求高吗?非科班出身如何突围?

答:上海部分大型企业(如互联网大厂、金融机构)对学历(本科及以上)和技术背景(计算机相关专业)有一定要求,但更看重实际能力和项目经验,非科班出身的求职者可通过以下方式提升竞争力:一是系统学习计算机基础课程(如数据结构、操作系统、计算机网络),弥补知识短板;二是通过实习、兼职或个人项目积累实战经验,例如为中小企业搭建小型数据平台或参与开源社区贡献;三是考取相关认证(如Cloudera CCAH、Databricks Spark认证)证明技术能力;四是面试中突出跨领域优势(如金融、医疗等行业知识),展现将Hadoop技术应用于特定场景的理解,中小型企业和传统企业数字化转型部门对非科班人才更为开放,可作为求职重点。