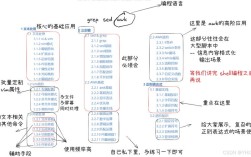

在Linux系统中,处理数据时经常需要去除重复内容,无论是文本文件中的重复行、命令输出中的重复结果,还是目录中的重复文件,都可以通过多种命令高效实现,以下将详细介绍几种常用的Linux命令去重复方法,包括uniq、sort | uniq、awk、comm以及fdupes等工具的使用场景和操作示例,帮助用户根据实际需求选择合适的方案。

uniq命令是专门用于去除相邻重复行的工具,其基本语法为uniq [选项] [输入文件] [输出文件],需要注意的是,uniq只能处理相邻的重复行,因此在去重前通常需要先用sort命令对文件进行排序,确保相同行聚集在一起。sort file.txt | uniq会先对file.txt进行排序,然后去除所有重复行,仅保留唯一行,如果需要同时统计重复行的出现次数,可以使用-c选项,如sort file.txt | uniq -c,输出结果中每行会附带重复次数。-d选项仅显示重复行,-u选项则仅显示不重复的行。sort file.txt | uniq -d会列出所有重复出现的行,而sort file.txt | uniq -u则只显示出现一次的行。

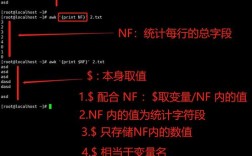

对于更复杂的去重需求,awk命令提供了更灵活的处理方式。awk是基于列处理的工具,可以通过指定列来去重。awk '!seen[$0]++' file.txt会直接去除文件中的所有重复行,无论行是否相邻,这里的seen是一个数组,$0表示整行内容,!seen[$0]++的含义是:如果当前行未被记录过(即seen[$0]为假),则输出该行并将seen[$0]标记为真(表示递增),如果需要按特定列去重,例如按第二列去重,可以使用awk '!seen[$2]++' file.txt,此时$2代表第二列的值。awk还可以结合其他条件实现更复杂的去重逻辑,例如去除重复行且保留最后一次出现的行:awk '{a[$0]=$0} END {for(i in a) print a[i]}' file.txt。

当需要比较两个文件并找出各自的唯一行时,comm命令是理想选择。comm要求输入文件已排序,其基本用法为comm [选项] 文件1 文件2,默认情况下,comm会输出三列:仅在文件1中出现的行、仅在文件2中出现的行、两个文件共有的行。comm file1.txt file2.txt会显示三列结果,如果需要仅显示两个文件共有的行,可以使用comm -12 file1.txt file2.txt(-1和-2选项会隐藏第一列和第二列),如果需要显示文件1中独有的行,可以使用comm -23 file1.txt file2.txt,需要注意的是,comm要求数据已排序,因此在使用前通常需要先用sort处理文件,如sort file1.txt > file1_sorted.txt && sort file2.txt > file2_sorted.txt && comm file1_sorted.txt file2_sorted.txt。

对于去重文件中的重复文件(即内容相同的文件),可以使用fdupes工具。fdupes是一个专门用于查找重复文件的命令行工具,安装后可以通过fdupes 目录路径扫描指定目录下的重复文件。fdupes /home/user/documents会列出所有重复文件,并提示用户选择删除哪些文件。fdupes还支持递归扫描子目录(-r选项)、排除特定文件(--exclude选项)等高级功能。fdupes还可以结合-d选项进入交互式删除模式,如fdupes -d /home/user/documents,用户可以逐个确认是否删除重复文件。

除了上述命令,还可以结合sort和其他工具实现去重。sort -u file.txt会直接对文件进行排序并去除重复行,相当于sort file.txt | uniq的效果,如果需要去除重复行且保留原始顺序,可以使用awk或perl等工具,例如awk '!a[$0]++' file.txt会保留首次出现的行并去除后续重复行,而原始顺序不变,对于CSV或表格数据,可以使用cut或awk提取特定列后去重,例如cut -d',' -f1 file.csv | sort | uniq会提取CSV文件的第一列并去除重复值。

以下是一个常用去重命令的对比表格,帮助用户快速选择合适的工具:

| 命令组合 | 功能描述 | 示例 | 适用场景 |

|---|---|---|---|

sort | uniq |

去除相邻重复行(需先排序) | sort file.txt | uniq |

文本文件去重,需排序 |

uniq -c |

统计重复行出现次数 | sort file.txt | uniq -c |

需要重复行频率统计 |

awk '!seen[$0]++' |

去除所有重复行(保留首次出现) | awk '!seen[$0]++' file.txt |

无需排序,保留原始顺序 |

comm -12 |

找出两个文件的共同行(需排序) | comm -12 file1.txt file2.txt |

比较两个文件的交集 |

sort -u |

排序并去重 | sort -u file.txt |

需要排序后的唯一行 |

fdupes |

查找并删除重复文件 | fdupes /path/to/directory |

文件系统去重 |

在实际操作中,选择合适的去重命令取决于数据格式、是否需要保留顺序、是否需要统计重复次数等需求,对于大型日志文件,sort | uniq可能更高效;而对于需要保留原始顺序的场景,awk命令则是更好的选择,在处理二进制文件或大型目录时,fdupes能提供更专业的重复文件管理功能。

相关问答FAQs:

-

问:

uniq命令为什么无法直接去除文件中的所有重复行?

答:uniq命令只能去除相邻的重复行,因此在使用前需要先用sort命令对文件进行排序,确保相同行聚集在一起。sort file.txt | uniq才能正确去除所有重复行,如果直接使用uniq file.txt,仅会去除连续的重复行,而分散在文件不同位置的重复行不会被去除。 -

问:如何去除文本文件中的重复行并保留原始顺序?

答:可以使用awk命令实现,例如awk '!seen[$0]++' file.txt,该命令通过数组seen记录已出现的行,仅输出首次出现的行,从而保留原始顺序,如果需要按特定列去重并保留顺序,可以修改$0为列号,例如awk '!seen[$2]++' file.txt会按第二列去重并保留首次出现的行的顺序。