在Hadoop分布式文件系统(HDFS)中,上传文件是基础且高频的操作,用户可以通过多种命令实现文件上传,每种命令适用于不同场景,具有独特的语法和功能,以下是关于HDFS文件上传命令的详细说明,涵盖常用命令、参数配置、场景应用及注意事项。

基本上传命令:hdfs dfs -put

hdfs dfs -put是最常用的上传命令,用于将本地文件或目录上传到HDFS指定路径,其基本语法为:hdfs dfs -put <local_src> <hdfs_dest>。local_src可以是本地文件或目录路径,hdfs_dest是HDFS上的目标路径,将本地文件/home/user/data.txt上传到HDFS的/input目录下,可执行hdfs dfs -put /home/user/data.txt /input/data.txt;若上传整个目录,需添加-f参数覆盖已存在文件,或-p参数保留源文件的权限和时间戳,该命令支持批量上传,可通过通配符实现,如hdfs dfs -put /home/user/*.txt /input/可将所有.txt文件上传至HDFS,需要注意的是,上传大文件时,若网络不稳定或集群资源紧张,可能导致上传失败,建议结合-D参数调整块大小(如-D dfs.blocksize=128m)以提升效率。

并行上传命令:hadoop fs -put

hadoop fs -put与hdfs dfs -put功能基本一致,但属于Hadoop通用文件系统命令,适用于HDFS与其他兼容Hadoop API的文件系统(如Azure Data Lake Storage),其语法和参数与hdfs dfs -put高度相似,但在跨文件系统操作时更具通用性。hadoop fs -put local_file hdfs_path同样支持本地到HDFS的上传,且可通过-skipcrccheck参数跳过校验和检查,适用于对数据完整性要求不高的场景。hadoop fs命令家族还支持-copyFromLocal,其功能与-put类似,但仅支持本地到HDFS的上传,无法处理标准输入流,语法为hadoop fs -copyFromLocal <local_src> <hdfs_dest>。

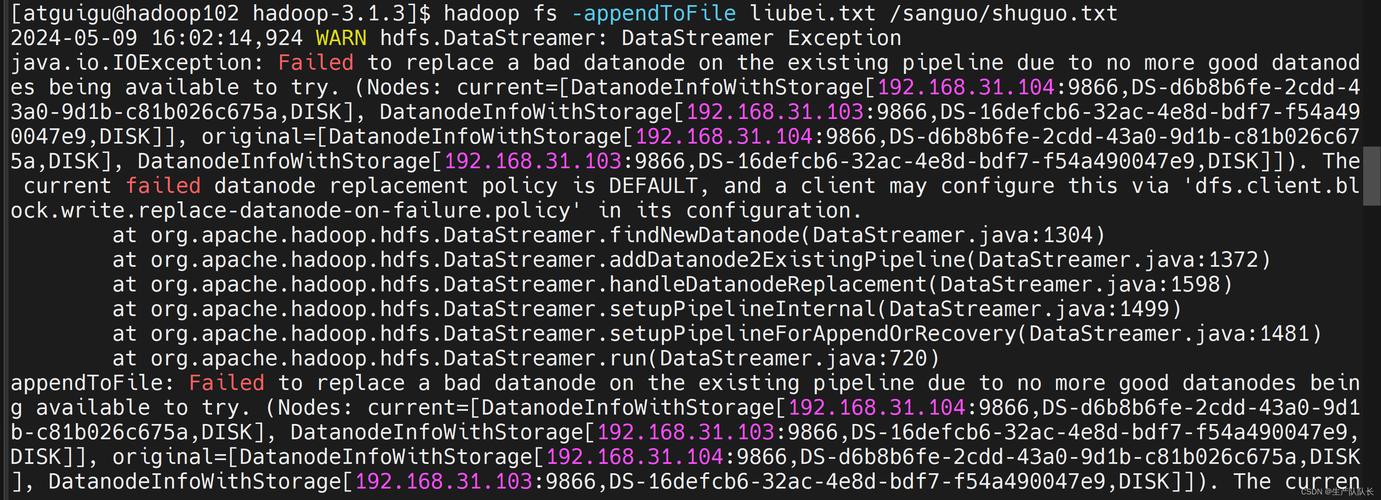

追加上传命令:hdfs dfs -appendToFile

当需要将本地内容追加到HDFS已有文件末尾时,可使用hdfs dfs -appendToFile命令,其语法为hdfs dfs -appendToFile <local_src> <hdfs_dest>,其中local_src可以是本地文件或直接输入的文本内容,将本地文件log1.txt追加到HDFS文件/input/combined.log中,执行hdfs dfs -appendToFile log1.txt /input/combined.log;若追加文本内容,可用引号包裹,如hdfs dfs -appendToFile "new data" /input/combined.log,该命令要求目标文件必须已存在,否则会报错,且仅支持追加操作,无法覆盖或插入文件中间内容。

分块上传与并行处理:distcp工具

对于大规模数据迁移或跨集群上传,Hadoop提供了distcp(分布式复制)工具,通过MapReduce实现并行上传,显著提升效率。distcp的基本语法为hadoop distcp <local_src> <hdfs_dest>,但更常见的用法是跨集群复制,如hadoop distcp hdfs://cluster1/path hdfs://cluster2/path,本地文件上传时,需先确保本地路径可通过Hadoop访问(如挂载到分布式文件系统),或结合-f参数指定文件列表。distcp支持增量复制(-update参数)、过滤文件(-i参数忽略失败)等高级功能,适用于TB级数据迁移场景,但需要额外启动MapReduce任务,资源消耗较高。

参数配置与性能优化

上传文件时,可通过参数调整优化性能。-D dfs.blocksize设置HDFS块大小(默认128MB,大文件可调整为256MB或512MB),减少小文件数量;-D dfs.replication设置副本数(默认3,可根据集群规模调整);-D io.file.buffer.size设置缓冲区大小(默认64KB,大文件可提升至256KB),使用-threads参数(需结合hadoop jar调用多线程工具)可增加并发上传线程数,适合小批量文件快速上传,若上传过程中频繁出现超时,可调整-D dfs.client.socket-timeout参数延长超时时间。

常见场景与命令选择

| 场景 | 推荐命令 | 示例 |

|---|---|---|

| 单个小文件上传 | hdfs dfs -put | hdfs dfs -put file.txt /data/ |

| 批量文件上传 | hdfs dfs -put + 通配符 | hdfs dfs -put *.csv /input/ |

| 大文件上传(需优化性能) | hdfs dfs -put + 参数调整 | hdfs dfs -put -D dfs.blocksize=256m large_file /data/ |

| 跨集群/大规模数据迁移 | hadoop distcp | hadoop distcp hdfs://src/cluster/path hdfs://dest/cluster/path |

注意事项

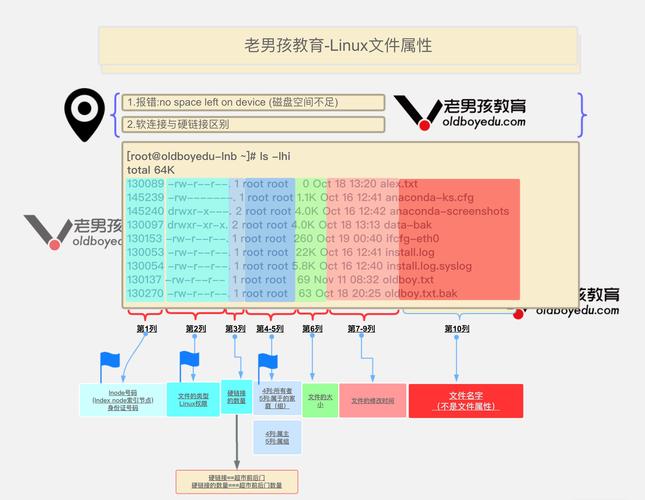

- 权限问题:上传文件需确保HDFS目标目录有写入权限,可通过

hdfs dfs -chmod调整权限。 - 磁盘空间:上传前检查HDFS集群剩余空间,避免因空间不足导致上传失败。

- 网络稳定性:大文件上传建议在集群低峰期进行,或启用断点续传功能(需第三方工具支持)。

- 文件覆盖:默认情况下,

-put命令若目标文件已存在会报错,需添加-f参数强制覆盖。

相关问答FAQs

Q1: 使用hdfs dfs -put上传大文件时速度很慢,如何优化?

A1: 可通过以下方式优化:① 调整HDFS块大小(如-D dfs.blocksize=256m),减少元数据压力;② 增加副本数并发(如-D dfs.replication=1,仅适用于测试环境);③ 使用-D io.file.buffer.size=262144增大缓冲区;④ 采用distcp工具进行并行上传,或通过多线程工具(如parallel命令)分片上传后合并。

Q2: 如何将本地文件夹及其子目录结构完整上传到HDFS?

A2: 使用hdfs dfs -put命令时,直接指定本地目录路径即可保留子目录结构,例如hdfs dfs -put /local/folder /hdfs/target/会将/local/folder及其所有子目录上传到HDFS的/hdfs/target/folder下,若需覆盖已存在目录,添加-f参数;若需保留源文件权限和时间戳,添加-p参数。