第一步:明确你的收集目的

在开始之前,最重要的一步是问自己:“我为什么要收集门户网站?” 不同的目的,决定了你收集的范围、深度和标准。

- 目的A:市场研究/竞品分析

- 目标:了解特定行业的头部玩家、市场份额、用户群体和商业模式。

- 例子:我想了解中国主流的新闻门户有哪些?它们各自的特色是什么?

- 目的B:SEO/数字营销

- 目标:寻找高质量的网站进行内容投稿、友情链接交换或广告投放。

- 例子:我需要收集一些流量高、权重高的科技类门户网站列表。

- 目的C:内容聚合/导航站搭建

- 目标:建立一个全面的分类目录,方便用户访问特定类型的网站。

- 例子:我想做一个“全国高校官网导航”,需要收集所有大学的官方门户网站。

- 目的D:学术研究/数据挖掘

- 目标:获取大量网站数据,进行量化分析或建立数据集。

- 例子:我需要收集过去10年所有“世界500强”企业的官方网站。

明确目的后,你就可以定义“什么是你眼中的‘门户网站’”。

第二步:定义“门户网站”的范围和标准

“门户网站”的定义已经随着时代发展而演变,你需要根据你的目的来设定标准。

按类型和领域分类

这是最常用、最有效的分类方式,你可以将门户网站分为:

- 综合门户

- 特点包罗万象,涵盖新闻、财经、科技、娱乐、体育、汽车等几乎所有领域,通常拥有强大的搜索引擎和邮箱等增值服务。

- 例子:雅虎、新浪、搜狐、网易、腾讯网。

- 垂直门户

- 特点:专注于某一特定行业或领域,提供更深入、专业的资讯和服务。

- 例子:

- 科技:36氪、虎嗅网、IT之家、CSDN。

- 汽车:汽车之家、易车网。

- 房产:链家、贝壳找房。

- 游戏:17173、多玩。

- 健康:丁香园、好大夫在线。

- 政府/机构门户

- 特点:由政府、事业单位或组织建立,提供官方信息、办事服务和政策发布。

- 例子:中华人民共和国中央人民政府门户网站、各部委官网、大学官网、图书馆官网。

- 地方/区域门户

- 特点:专注于特定城市或地区的本地化信息,如新闻、生活服务、招聘等。

- 例子:北京的“千龙网”、上海的“东方网”、地方的城市通网站。

- 企业门户

- 特点:作为企业的官方信息发布平台、品牌形象展示窗口和客户服务入口。

- 例子:华为官网、阿里巴巴集团官网、苹果官网。

按关键指标筛选

如果你需要进行量化分析,可以设定一些硬性指标:

- 流量指标:根据 SimilarWeb, Alexa 等工具的月访问量进行排名。

- 权重指标:根据 Ahrefs, Moz 等工具的域名权威度进行筛选。

- 内容质量:网站是否有原创、深度、高质量的内容。

- 用户活跃度:评论区的活跃度、社交媒体的互动情况。

- 更新频率是否定期更新。

第三步:选择收集方法和工具

根据你的目的和范围,选择合适的组合方法。

手动搜索与整理(适合少量、精准需求)

这是最基础也是最直接的方法。

- 技巧:

- 使用精确搜索关键词,在 Google 或百度中搜索:

"门户网站" 列表site:.gov.cn "政府门户网站"(只搜索政府域名下的网站)行业 + "门户网站",“金融门户网站”

- 利用高级搜索指令:

intitle:(标题包含),inurl:(网址包含),filetype:(文件类型)。

- 使用精确搜索关键词,在 Google 或百度中搜索:

- 工具:

- 搜索引擎:Google, Bing, Baidu (百度)。

- 浏览器书签:将找到的网站分门别类地保存起来。

- 优点:精准、可控,能人工判断网站质量。

- 缺点:效率低,不适合大规模收集。

利用第三方数据平台(适合市场研究和竞品分析)

这些平台已经做了大量的数据爬取和整理工作,是获取高质量网站列表的捷径。

- 工具推荐:

- SimilarWeb:提供全球网站的流量估算、流量来源、用户画像等数据,可以按类别、国家、流量排名查找网站。

- Alexa:老牌网站排名工具,可以查看网站的全球和地区排名,以及相关网站推荐。

- Ahrefs / Semrush:专业的SEO工具,它们的“网站 Explorer”和“关键词研究”功能可以帮助你找到特定领域的权威网站(即垂直门户)。

- 中国本土工具:站长之家、爱站网 等,提供类似SimilarWeb的流量数据和网站信息查询。

- 操作流程:

- 在 SimilarWeb 中选择“类别”,News and Media (新闻与媒体)”。

- 你会看到一个排名列表,点击“View all”查看更多。

- 可以按国家/地区筛选,China”。

- 将结果导出为CSV或Excel。

使用爬虫技术(适合大规模、自动化数据收集)

如果你需要成千上万个网站链接,或者需要定期更新数据,这是最强大的方法。

- 工具和技术:

- Python + Scrapy 框架:最流行的爬虫框架,高效、强大,可定制化程度高。

- Python + BeautifulSoup / Selenium:适合中小型项目,Selenium可以处理JavaScript动态加载的页面。

- 八爪鱼、火车头等可视化爬虫工具:无需编程,通过图形化界面配置任务,适合非技术人员。

- 数据来源:

- 搜索引擎结果页:通过模拟搜索,抓取SERP中的链接。

- 网站目录:如 DMOZ (已关闭,但可作为参考思路)、维基百科的分类页面。

- 行业链接农场/导航站:这些网站本身就有大量分类好的网站链接。

- 优点:自动化程度高,可扩展性强,能获取海量数据。

- 缺点:技术门槛较高,需要处理反爬策略(IP封锁、验证码等),且需遵守网站的

robots.txt协议。

利用API接口(适合高质量、结构化数据)

一些大型平台提供API,允许开发者合法地获取其数据。

- 工具推荐:

- Google Custom Search API:可以创建自定义搜索引擎,并通过API获取搜索结果,其中就包含网站列表。

- 各大开放平台:一些大型门户网站(如知乎、微博)可能提供开放API,可以获取其生态内的网站信息。

- 优点:数据稳定、结构化、使用合法。

- 缺点:可能需要付费,且有调用频率限制。

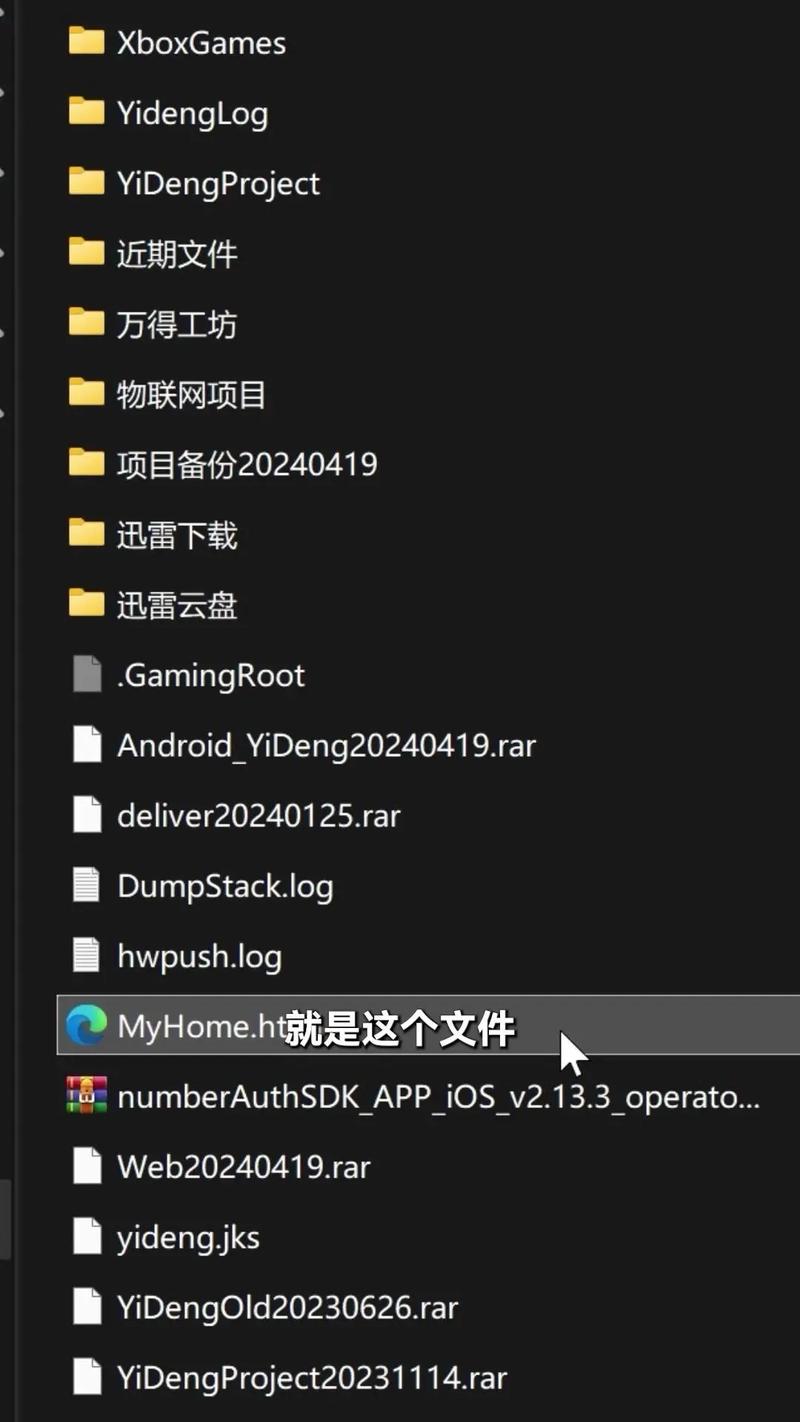

第四步:整理和验证收集到的数据

收集只是第一步,整理和验证才能让数据变得可用。

- 去重:使用Excel或编程脚本(如Python的Pandas库)去除重复的网址。

- 分类:根据你在第二步中定义的类型(综合、垂直、政府等),对网站进行打标分类,可以创建一个Excel表格,包含以下列:

网站名称网址类型(综合/垂直/政府...)所属领域(科技/财经/教育...)国家/地区备注(特色、简介等)

- 验证:

- 访问测试:随机抽查部分网址,确认网站是否可以正常访问。

- 信息核对:核对网站名称、网址等关键信息是否准确。

- 工具二次验证:用Ahrefs或SimilarWeb抽查几个网站的流量和权重,看是否符合你的筛选标准。

第五步:持续维护和更新

互联网是动态变化的,网站会关闭、会改版、会更换域名,一个静态的列表很快就会过时。

- 定期检查:设定一个周期(如每月或每季度)来检查你的列表,更新失效链接。

- 设置Google Alerts:为你的关键词(如“新上线的科技门户”)设置Google快讯,一旦有相关新闻,你就能及时获取信息。

- 关注行业动态:关注科技媒体、行业报告,了解新的网站平台的出现和旧平台的消亡。

一个可行的实践方案(以“收集中国科技类垂直门户”为例)

- 目的:为我的科技博客寻找高质量的投稿和合作对象。

- 标准:

- 类型:科技垂直门户。

- 领域:互联网、AI、创投。

- 指标:月访问量 > 100万,DA > 40,内容更新频繁。

- 方法:

- 初步筛选:在 SimilarWeb 中,选择“类别”->“Computers and Electronics”,然后筛选“China”,按流量排序,浏览前50名。

- 深度挖掘:将候选名单输入 Ahrefs,查看它们的域名权威度、反向链接数量和内容关键词,进一步筛选。

- 人工补充:在百度搜索“中国科技媒体”、“创投媒体”、“IT门户”,补充一些可能未被SimilarWeb收录的新兴网站。

- 整理:将最终名单整理到Excel表格中,并标注其特色(如“侧重AI”、“侧重创投报道”、“开发者社区”)。

- 维护:将此列表存档,并订阅这些网站的RSS或关注其官方账号,以便持续了解其动态。

通过以上系统化的步骤,你就可以高效、准确地收集到符合你需求的门户网站列表。