Hadoop运行jar包命令是大数据处理中常用的操作,主要用于将打包好的Java应用程序提交到Hadoop集群上执行,Hadoop作为一个分布式系统框架,提供了命令行工具来管理作业、资源和任务执行,其中hadoop jar命令是最核心的命令之一,下面将详细介绍该命令的使用方法、参数配置、常见场景及注意事项。

在Hadoop中,运行jar包的基本语法为hadoop jar <jar文件> <主类> [参数]。<jar文件>是包含应用程序代码的JAR包,<主类>是JAR包中包含main方法的类名,[参数]是传递给主类的可选参数,执行一个名为wordcount.jar的JAR包,其主类为com.example.WordCount,命令为hadoop jar wordcount.jar com.example.WordCount input output,其中input和output分别是程序的输入和输出路径。

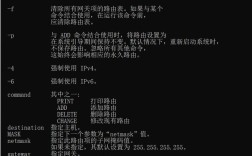

除了基本语法外,hadoop jar命令还支持多种参数来控制作业的行为,以下是一些常用参数及其说明:

| 参数 | 说明 | 示例 |

|---|---|---|

-D <property=value> |

设置Hadoop配置属性 | hadoop jar myapp.jar -D mapreduce.job.queuename=queue1 com.example.Main |

-conf <配置文件> |

指定Hadoop配置文件路径 | hadoop jar myapp.jar -conf /path/to/hadoop-site.xml com.example.Main |

-fs <文件系统URI> |

指定默认的文件系统 | hadoop jar myapp.jar -fs hdfs://namenode:9000 com.example.Main |

-jt <JobTracker URI> |

指定JobTracker地址(适用于旧版本Hadoop) | hadoop jar myapp.jar -jt resourcemanager:8032 com.example.Main |

-files <本地文件列表> |

将本地文件分发到各个节点 | hadoop jar myapp.jar -files file1.txt,file2.txt com.example.Main |

-archives <归档文件列表> |

将归档文件(如zip、tar)分发到各个节点 | hadoop jar myapp.jar -archives mylib.zip com.example.Main |

-libjars <JAR包列表> |

将额外的JAR包添加到类路径 | hadoop jar myapp.jar -libjars lib1.jar,lib2.jar com.example.Main |

-verbose |

启用详细输出模式 | hadoop jar -verbose myapp.jar com.example.Main |

-logs |

获取作业的日志文件 | hadoop jar -logs myapp.jar com.example.Main |

在实际应用中,合理使用这些参数可以优化作业执行效率,通过-libjars参数可以确保应用程序依赖的所有JAR包在集群中可用,避免因缺少依赖导致的运行失败,而-files和-archives参数则适用于需要分发配置文件或静态资源的场景,尤其是在MapReduce或Spark作业中。

对于MapReduce作业,还可以通过-D参数调整核心配置,设置Map任务的数量可通过-D mapreduce.job.maps=10,设置Reduce任务的数量可通过-D mapreduce.job.reduces=5,还可以调整内存配置,如-D mapreduce.map.memory.mb=2048和-D mapreduce.reduce.memory.mb=4096,以适应不同任务的资源需求。

在运行Hadoop作业时,输入和输出路径的处理至关重要,输入路径可以是HDFS上的目录,也可以是本地文件(需通过-file参数指定),而输出路径必须是HDFS上不存在的目录,否则作业会报错,若输出路径/user/output已存在,需先使用hadoop fs -rm -r /user/output删除该目录。

除了MapReduce,hadoop jar命令也可用于运行其他类型的作业,如Hive、HBase或Spark,运行一个Spark作业时,需确保Spark的相关依赖通过-libjars参数传递,并正确设置Spark的配置属性,Hadoop 3.x版本引入了hadoop jar命令的改进,支持更灵活的资源管理和作业调度。

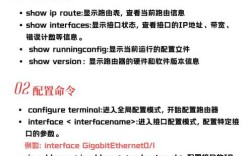

调试Hadoop作业时,日志是重要的参考信息,通过-verbose参数可以查看详细的作业执行过程,而-logs参数则可帮助定位节点级别的日志文件,Hadoop Web UI(通常为http://<namenode>:8088)提供了作业的可视化监控界面,可查看任务进度、资源使用情况和错误信息。

需要注意的是,运行Hadoop作业时需确保集群资源充足,避免因资源不足导致作业排队或失败,合理设置任务的优先级和队列(通过-D mapreduce.job.queuename)可以提高集群资源利用率,对于大规模作业,建议先使用小数据集测试,验证逻辑正确后再提交全量数据。

关于JAR包的打包方式,需确保主类的MANIFEST.MF文件中正确指定了Main-Class属性,否则需在命令中显式指定主类名,使用Maven或Gradle构建工具时,可通过插件自动生成可执行的JAR包,例如Maven的maven-shade-plugin或maven-assembly-plugin。

相关问答FAQs:

-

问:运行Hadoop jar包时遇到“ClassNotFoundException”错误,如何解决?

答: 该错误通常是由于JAR包依赖缺失或类路径配置不当导致的,可通过以下方式解决:- 使用

-libjars参数添加依赖的JAR包,如hadoop jar myapp.jar -libjars dependency1.jar,dependency2.jar com.example.Main。 - 检查JAR包的

MANIFEST.MF文件是否正确配置了Main-Class属性。 - 确保所有依赖的JAR包已上传到HDFS或集群节点,并在程序中正确引用路径。

- 使用

-

问:如何查看Hadoop作业的执行日志?

答: 查看Hadoop作业日志可通过以下方法:- 使用

hadoop job -history <作业ID>命令查看作业的历史记录和错误摘要。 - 通过Hadoop Web UI(

http://<ResourceManager地址>:8088)进入作业详情页面,点击“Logs”链接查看各个任务的日志。 - 使用

-logs参数获取作业日志的本地路径,如hadoop jar -logs myapp.jar,然后根据提示的路径查看日志文件。

- 使用