在处理MySQL数据库导入大文件时,性能优化至关重要,尤其是当文件达到GB级别或包含数百万行数据时,以下是提升导入效率的详细方法,涵盖预处理、配置调整、工具选择及执行策略等关键环节。

数据预处理与格式优化

-

选择合适的文件格式

使用CSV或TXT格式时,确保文件是纯文本且无BOM头(避免编码问题),若使用SQL脚本,尽量减少INSERT语句中的冗余信息(如注释、事务控制),对于超大型文件,优先考虑LOAD DATA INFILE而非逐行INSERT,其性能可提升10倍以上。 -

减少文件体积

- 压缩文件:使用

gzip压缩后再导入,可减少I/O时间,但需在MySQL中通过SET GLOBAL local_infile=ON;启用本地文件加载,并使用zcat命令解压流式导入。 - 分割文件:将大文件按行数或大小分割(如

split -l 1000000 large_file.txt part_),并行导入不同表或分表。

- 压缩文件:使用

-

数据清理与转换

在导入前清理无效数据(如空值、异常格式),避免导入后执行大量UPDATE或DELETE,若需转换数据(如日期格式),使用脚本预处理而非依赖MySQL函数。

MySQL配置调优

-

禁用索引与约束

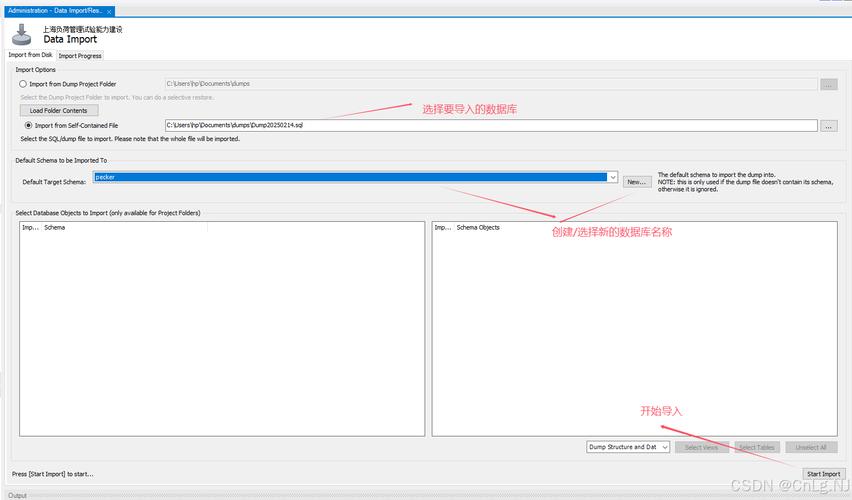

导入前临时关闭表的索引和外键检查,可显著减少写入开销: (图片来源网络,侵删)

(图片来源网络,侵删)ALTER TABLE target_table DISABLE KEYS; SET FOREIGN_KEY_CHECKS = 0; SET UNIQUE_CHECKS = 0;

导入完成后重新启用:

ALTER TABLE target_table ENABLE KEYS; SET FOREIGN_KEY_CHECKS = 1; SET UNIQUE_CHECKS = 1;

-

调整缓冲区与事务设置

- 增加

innodb_buffer_pool_size(建议为物理内存的70-80%),提升缓存命中率。 - 使用大事务批量提交(如

SET autocommit=0;,每10万行提交一次),减少事务日志开销。 - 临时调整

innodb_log_file_size(如设为2GB)以容纳更大的事务日志。

- 增加

-

优化I/O与并发

- 对于机械硬盘,启用

innodb_flush_log_at_trx_commit=2(牺牲部分持久性换取性能);SSD可保持默认值1。 - 使用

bulk_insert_buffer_size控制批量插入的缓存大小(默认8MB,可调至256MB)。

- 对于机械硬盘,启用

工具选择与执行策略

-

推荐工具对比

| 工具 | 适用场景 | 优势 | 注意事项 |

|---------------------|-----------------------------------|---------------------------------------|-----------------------------------|

|LOAD DATA INFILE| 本地文件导入,CSV/TXT格式 | 速度最快(可达10万行/秒) | 需文件服务器权限,格式严格 |

|mysqlimport| 命令行导入,基于LOAD DATA| 简单易用,支持并行导入 | 功能单一,无法复杂预处理 |

|MyLoader| Percona XtraBackup配套工具 | 支持并行导入、断点续传 | 需额外安装,配置较复杂 |

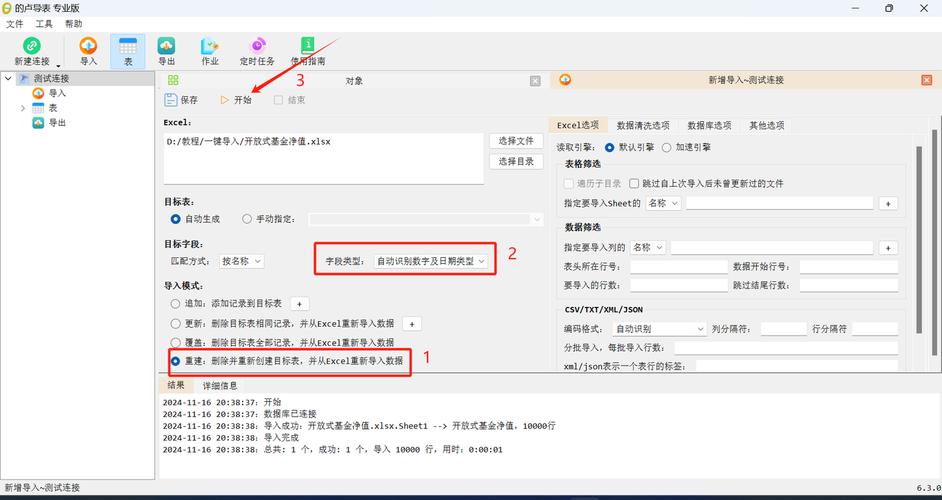

| 自定义脚本 | 复杂格式或需数据转换 | 灵活性高,可定制逻辑 | 需编程能力,可能引入瓶颈 | (图片来源网络,侵删)

(图片来源网络,侵删) -

并行导入技巧

- 若表结构允许,将大文件分割后导入不同表或分表(如

table_01,table_02),利用多线程并发执行。 - 使用

GNU parallel或xargs -P命令并行调用mysqlimport:cat file_list.txt | xargs -n 1 -P 4 mysqlimport --local -u user -p db_name

- 若表结构允许,将大文件分割后导入不同表或分表(如

-

网络与服务器资源

- 若文件在远程服务器,先传输至本地再导入,避免网络延迟。

- 导入期间暂停非必要服务(如备份、监控),释放CPU与I/O资源。

后续优化与验证

-

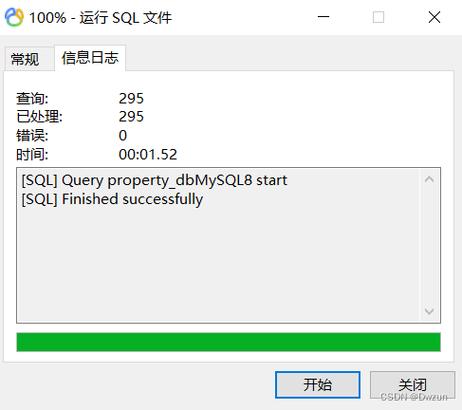

索引重建与统计信息更新

导入后执行ANALYZE TABLE更新统计信息,优化查询计划,对于全文索引,可能需单独重建。 -

监控与调优

通过SHOW PROCESSLIST监控导入进度,观察Innodb_row_insert等性能计数器,若出现锁等待,可调整innodb_thread_concurrency参数。

相关问答FAQs

Q1: 导入过程中出现“Error Code: 13”权限错误,如何解决?

A: 此错误通常因MySQL无文件读取权限导致,需确保:

- MySQL用户拥有

FILE权限(GRANT FILE ON *.* TO 'user'@'host';)。 - 文件位于服务器本地(

LOAD DATA INFILE不支持远程路径)。 - 若使用

--local选项,需在客户端配置local_infile=1(如mysql --local-infile -u user -p)。

Q2: 如何判断导入性能瓶颈?

A: 通过以下方式定位瓶颈:

- I/O瓶颈:监控

iostat -dx 1,若util%持续高于80%,考虑升级磁盘或使用SSD。 - CPU瓶颈:

top命令中MySQL进程CPU占用过高,检查是否因函数计算或锁竞争导致,可优化SQL或调整innodb_thread_concurrency。 - 内存瓶颈:观察

Innodb_buffer_pool_wait_free状态变量,若值频繁递增,需增加innodb_buffer_pool_size。