导入超大数据库是一个复杂且需要谨慎操作的过程,涉及技术、资源、流程管理等多个维度,以下从前期准备、技术方法、优化策略、风险控制等方面详细说明操作步骤和注意事项。

在开始导入前,必须进行全面的前期准备,首先是数据源分析,需要明确原始数据的格式(如CSV、JSON、Parquet)、大小(总行数、单文件大小)、结构(表结构、字段类型、关联关系)以及质量(是否存在重复、缺失、异常值),这一步可通过编写脚本或使用工具(如Python的pandas库)进行抽样分析,生成数据质量报告,其次是目标环境评估,确认目标数据库的类型(如MySQL、PostgreSQL、MongoDB、Hadoop等)、版本、存储容量(磁盘空间是否充足)、配置参数(如缓冲区大小、连接数限制)以及网络带宽(尤其是跨服务器导入时的传输速度),最后是制定详细计划,包括导入时间窗口(选择业务低峰期)、回滚方案(如保留备份)、责任人分工以及应急措施,确保每个环节都有明确指引。

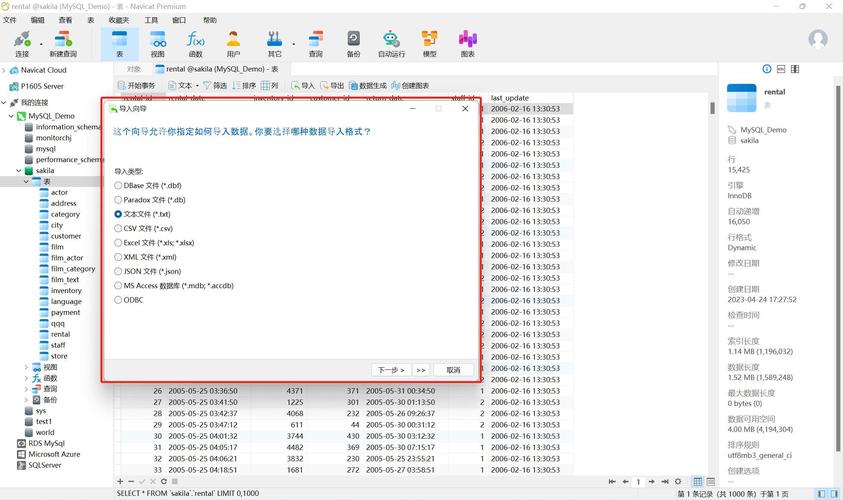

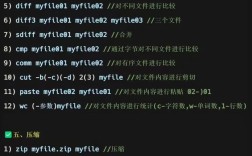

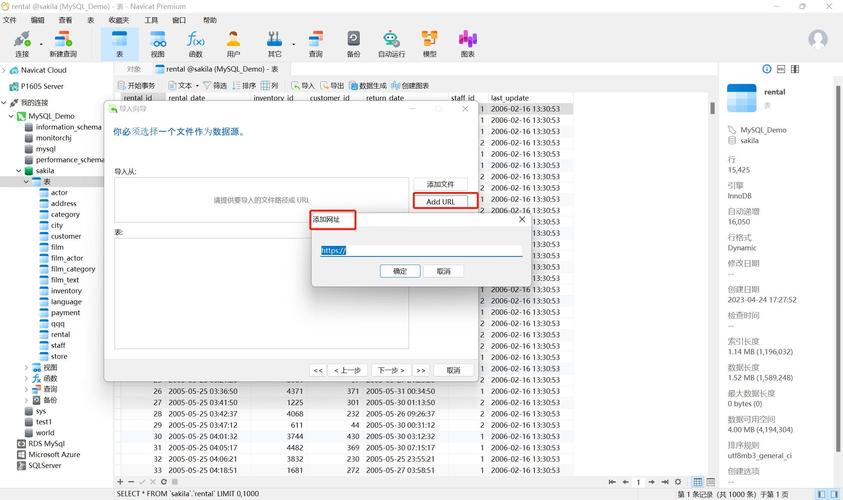

技术方法的选择是导入成功的关键,需根据数据规模和目标数据库特性灵活搭配,对于中小规模数据(几十GB),可直接使用数据库原生工具,如MySQL的LOAD DATA INFILE命令,通过设置LOCAL选项实现本地文件快速导入,或使用pg_dump和pg_restore(PostgreSQL)进行逻辑备份导入,这类方法的优势是简单高效,但面对超大规模数据(TB级)时,需采用分批处理和并行导入策略,将大文件拆分为多个小文件(按行数或大小),通过多线程或分布式任务同时导入,可显著提升速度,具体操作中,可使用GNU Split工具分割文件,结合Python的multiprocessing库或Apache Airflow实现并行调度,针对分布式数据库(如HBase、Cassandra),需利用其批量导入工具(如HBase的BulkLoad工具),通过生成HFile文件直接写入HDFS,避免通过RegionServer写入导致的性能瓶颈。

优化策略贯穿导入全过程,直接影响效率和资源占用,首先是资源调优,根据数据量调整数据库参数,如MySQL可增大innodb_buffer_pool_size(设置为物理内存的70%-80%)、innodb_io_capacity(提升I/O处理能力),PostgreSQL可调整work_mem和maintenance_work_mem优化排序和建表操作,其次是格式优化,选择合适的文件格式能减少解析时间,例如使用列式存储格式(如Parquet)替代CSV,可压缩数据体积并提升读取速度;使用二进制格式(如MySQL的LOAD DATA的二进制选项)能避免字符编码转换开销,最后是索引和约束处理,导入前可临时禁用非唯一索引和外键约束(如MySQL的ALTER TABLE DISABLE KEYS),待数据导入完成后再重建索引,减少写入时的索引维护开销,对于分表分库的场景,需确保数据按分片规则正确路由,可通过自定义分片键或使用中间件(如ShardingSphere)实现数据预分发。

风险控制是保障数据完整性的核心环节,首先是数据校验,导入完成后需通过比对源数据和目标数据的行数、总和、哈希值等关键指标,确保数据一致性,使用SQL的COUNT(*)和SUM()函数进行汇总校验,或通过Python的hashlib库计算文件哈希值,其次是监控和日志记录,在导入过程中实时监控服务器资源(CPU、内存、磁盘I/O、网络带宽)和数据库性能(慢查询、锁等待),记录详细的导入日志(如成功/失败行数、错误信息),便于问题排查,最后是回滚机制,若导入失败,需快速恢复到导入前状态,可通过数据库备份(如全量备份+增量备份)或事务回滚(若支持事务)实现,对于不支持事务的存储引擎(如MySQL的MyISAM),需提前备份表结构或使用临时表导入,确认无误后再替换原表。

相关问答FAQs:

Q1:导入过程中出现内存溢出(OOM)错误,如何解决?

A:内存溢出通常因单次处理数据量过大导致,可通过以下方法解决:① 减小批处理大小,如将每次导入的行数从10万行降至5万行;② 增加服务器内存或优化JVM参数(若使用Java工具);③ 使用流式处理(如Python的csv.reader逐行读取)而非全量加载到内存;④ 检查数据库配置,适当增大sort_buffer_size等会内存分配的参数,避免因临时表占用过多内存。

Q2:如何验证导入数据的完整性和准确性?

A:可采取多维度验证:① 行数比对:对比源文件和目标表的行数,确保无遗漏或重复;② 抽样校验:随机抽取一定比例数据(如1%),检查关键字段(如ID、时间戳)的值是否一致;③ 聚合校验:对数值型字段计算总和、平均值等指标,对比源数据和目标结果;④ 约束检查:执行SELECT COUNT(*) FROM 表名 WHERE 字段 IS NULL等语句,验证唯一性约束、非空约束是否生效;⑤ 工具辅助:使用数据校验工具(如Great Expectations)或自定义脚本,自动化完成全量数据比对。