在当前大数据技术蓬勃发展的时代,Apache Spark作为分布式计算框架的核心代表,已成为企业处理海量数据、实现实时分析与机器学习的重要工具,围绕“招聘Spark”这一主题,企业需要从岗位定位、技能要求、招聘策略到候选人评估等多个维度构建完整体系,以吸引并选拔符合业务需求的Spark技术人才。

招聘Spark岗位的核心需求分析

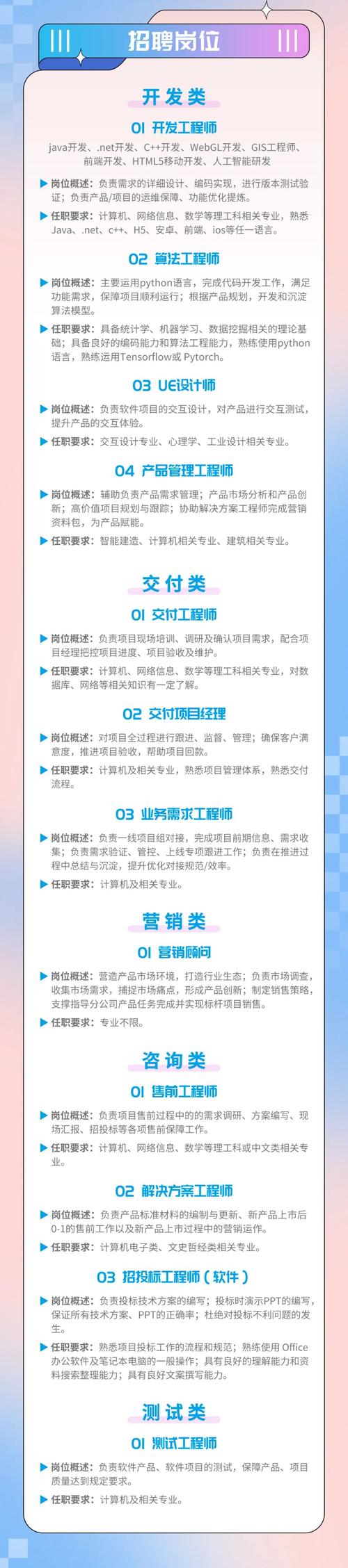

Spark技术岗位通常分为开发工程师、数据工程师、算法工程师(Spark MLlib方向)和平台运维工程师等方向,不同岗位对技能的侧重点存在差异,以最常见的Spark开发工程师为例,其核心职责包括:基于Spark进行数据ETL开发、设计高性能的数据处理流程、优化Spark作业性能、解决分布式环境下的技术难题等,招聘时需明确岗位的技术栈深度与广度,例如是否需要结合Kafka、Flink等实时计算工具,或是否涉及PySpark、Scala等编程语言的工程化实践。

Spark岗位的技能要求拆解

基础理论与编程能力

- Spark核心原理:需掌握Spark架构(Driver、Executor、Cluster Manager)、RDD/DataFrame/Dataset的转换与行动、调度机制(DAG、TaskScheduler)、内存管理(堆内/堆外内存、存储级别)等核心概念。

- 编程语言:Scala(Spark原生语言,需掌握函数式编程、集合操作)或Python(PySpark生态,需熟悉pandas、numpy等库的协同使用),部分企业会要求Java/Scala基础。

- 分布式基础:理解分布式计算原理(如容错机制、数据本地性)、熟悉Linux操作系统、Shell脚本编写。

生态工具与实战经验

- Spark SQL与性能优化:熟练使用DataFrame API、SQL语句,掌握 Catalyst 优化器原理、分区(partitioning)、桶(bucketing)、索引等优化手段,能够处理数据倾斜问题。

- 流处理能力:掌握Spark Streaming(微批处理)或Structured Streaming(流式SQL),了解窗口函数、状态管理等特性,能结合Kafka实现实时数据管道。

- 生态集成:熟悉HDFS、Hive、HBase等存储系统,了解YARN、Kubernetes等资源调度工具,具备与Flink、TensorFlow等工具的集成经验。

高级技能与工程化能力

- 性能调优:从JVM参数(GC调优)、序列化方式(Kryo序列化)、资源分配(executor内存、core配置)等多维度优化Spark作业,能够通过Spark UI定位性能瓶颈。

- 故障排查:掌握常见错误(如OOM、序列化失败、数据倾斜)的排查方法,能够阅读源码定位问题。

- 工程实践:熟悉CI/CD流程(如Jenkins、Airflow)、容器化部署(Docker、K8s),具备大规模集群(百节点以上)运维经验者优先。

业务与软技能

- 业务理解:能够将数据需求转化为Spark技术方案,例如在金融风控、推荐系统中设计特征工程流程。

- 沟通协作:具备跨团队协作能力,能够与数据分析师、算法工程师高效对接,清晰表达技术方案。

- 学习能力:Spark版本迭代快(如3.x的Adaptive Query Execution),需持续关注社区动态,学习新特性。

招聘策略与渠道选择

岗位JD撰写技巧

JD需突出技术亮点与业务价值,“负责日处理PB级数据的Spark集群优化,将ETL任务耗时从8小时压缩至2小时”,而非罗列通用技能,同时明确硬性要求(如3年以上Spark开发经验)和软性要求(如问题解决能力),吸引目标候选人。

招聘渠道组合

- 技术社区:GitHub(关注Spark项目贡献者)、Stack Overflow(活跃回答者)、CSDN/掘金技术博主,精准触达技术深度人才。

- 招聘平台:猎聘、BOSS直聘等平台设置“Spark”“大数据开发”等关键词,结合岗位标签筛选。

- 内推与行业活动:通过技术峰会(如Spark Summit)、Meetup活动拓展人脉,鼓励员工内推(设置推荐奖励机制)。

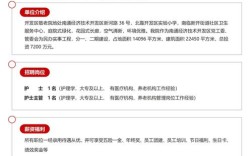

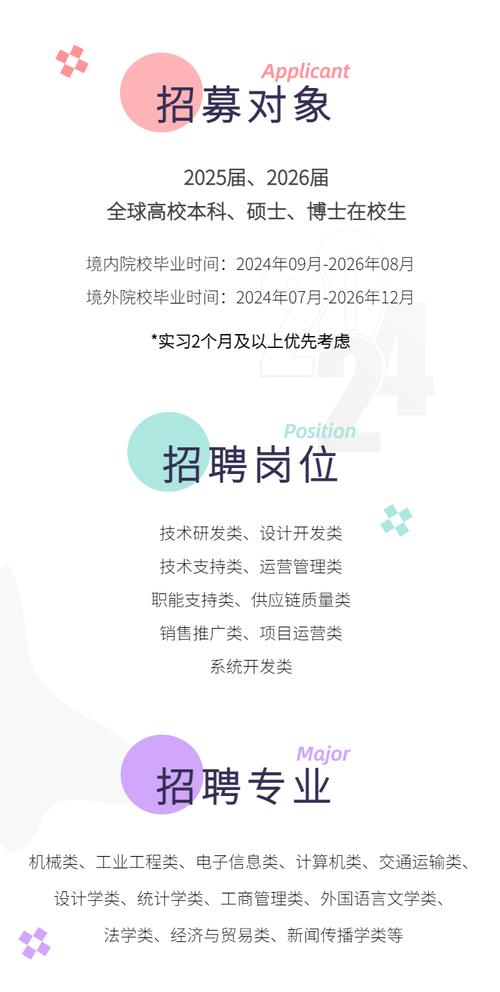

- 高校合作:与开设大数据相关专业的高校合作,通过实习项目储备应届生(需补充Spark原理与项目实践培训)。

面试流程设计

建议采用“技术笔试+技术面试+业务面试+HR面试”四轮流程:

- 笔试:考察Spark基础(如RDD vs DataFrame)、编程题(如用Scala实现WordCount)、调优案例分析(如数据倾斜解决方案)。

- 技术面试:深挖项目经验(如“描述你遇到的最复杂的Spark性能问题及解决过程”),现场编码(如PySpark实现多表关联查询),源码阅读(如“解释DAG的生成过程”)。

- 业务面试:结合公司业务场景设计问题(如“如何用Spark设计电商实时推荐系统的特征计算模块”)。

- HR面试:评估职业稳定性、团队协作意识,避免“纯技术型人才”融入困难。

候选人评估与录用决策

评估时需平衡“技术深度”与“工程经验”,优先选择具备以下特质的候选人:

- 问题解决能力:能够通过日志分析、工具定位问题,而非仅依赖模板化方案。

- 技术视野:了解Spark生态发展趋势(如Spark on K8s、Unified Analytics),具备技术选型判断力。

- 项目匹配度:过往项目经验与公司业务场景高度契合(如金融行业需强一致性保障,互联网行业需高并发处理)。

Spark技术岗位招聘常见挑战与应对

| 挑战 | 应对策略 |

|---|---|

| 高级人才稀缺 | 开放内部培养机制,选拔有潜力的中级工程师参与Spark核心项目,提供导师指导。 |

| 应届生经验不足 | 设计“理论+实践”双考核环节,通过实验室场景模拟(如搭建小型Spark集群)评估基础能力。 |

| 薪资竞争力不足 | 结合技术价值(如Spark优化带来的成本降低)制定薪酬包,提供股票期权等长期激励。 |

相关问答FAQs

Q1: 招聘Spark开发工程师时,应优先考虑Scala还是Python能力?

A1: 需结合业务场景判断:若涉及底层开发(如Spark源码贡献、自定义优化)、高并发实时计算,Scala能力更重要(性能优势、函数式编程特性);若业务侧重快速迭代(如数据分析、原型验证),Python生态(PySpark、MLlib)更易上手,建议在JD中明确“优先掌握Scala”或“Python+Spark SQL即可”,避免候选人技能与岗位需求错配。

Q2: 如何判断候选人是否具备真实的Spark项目经验而非“纸上谈兵”?

A2: 通过“STAR法则”深挖项目细节:

- 情境(Situation):项目规模(数据量、集群节点数)、业务背景(如实时风控、日志分析);

- 任务(Task):候选人在项目中的具体职责(如负责哪部分模块、性能优化目标);

- 行动(Action):技术选型原因(为何用Structured Streaming而非Spark Streaming)、调优手段(如如何发现并解决数据倾斜);

- 结果(Result):量化成果(如作业吞吐量提升%、资源成本降低比例),同时要求候选人现场演示代码片段或解释项目架构图,识别是否存在夸大或虚构经历。