爬取智联招聘招聘信息是一项涉及技术、法律和道德的综合性任务,需要明确目标、选择合适工具、遵循规范,并确保数据使用的合法性,以下从准备工作、技术实现、注意事项及数据应用等方面进行详细说明。

准备工作

在开始爬取前,需明确需求并做好技术储备,确定爬取目标字段,如职位名称、公司名称、薪资范围、工作地点、学历要求、工作经验、发布时间等,这些信息可根据实际需求筛选,分析智联招聘的网页结构,通过浏览器开发者工具(F12)查看目标数据的HTML标签,例如职位名称通常位于<a>标签的title属性或文本内容中,薪资信息可能存在于<span>或<em>标签内,需考虑反爬机制,如IP限制、验证码、动态加载等,提前准备代理IP池、模拟浏览器请求(如使用Selenium或Playwright)以及处理动态渲染的工具。

技术实现步骤

环境搭建

选择合适的编程语言和库,Python是常用选择,主要依赖以下库:

requests:发送HTTP请求,获取网页源码;BeautifulSoup或lxml:解析HTML,提取目标数据;pandas:数据清洗与存储;selenium或playwright:处理动态加载内容;fake-useragent:随机生成User-Agent,模拟真实浏览器。

安装依赖可通过命令:pip install requests beautifulsoup4 pandas selenium fake-useragent。

发送请求与解析网页

针对静态页面,直接使用requests获取源码:

import requests

from bs4 import BeautifulSoup

url = "https://www.zhaopin.com/jobs/search?keyword=Python&city=530"

headers = {"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36"}

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.text, "html.parser")

对于动态加载的内容(如通过Ajax加载的职位列表),需使用Selenium模拟浏览器操作:

from selenium import webdriver

from selenium.webdriver.common.by import By

driver = webdriver.Chrome()

driver.get(url)

# 等待动态加载完成

driver.implicitly_wait(10)

jobs = driver.find_elements(By.CLASS_NAME, "job-title")

for job in jobs:

print(job.text)

driver.quit()

数据提取与存储

通过分析HTML结构,定位目标元素并提取数据,提取职位名称和公司名称:

job_list = soup.find_all("div", class_="job-item")

data = []

for job in job_list:= job.find("a", class_="job-title").text.strip()

company = job.find("a", class_="company-name").text.strip()

salary = job.find("span", class_="salary").text.strip()

data.append([title, company, salary])

将数据存储为CSV文件,便于后续分析:

import pandas as pd

df = pd.DataFrame(data, columns=["职位名称", "公司名称", "薪资"])

df.to_csv("zhaopin_jobs.csv", index=False, encoding="utf-8-sig")

分页与循环爬取

智联招聘通常有多页数据,需构造分页URL或模拟翻页操作,通过观察分页URL规律(如&page=2),使用循环爬取多页:

for page in range(1, 6): # 爬取前5页

page_url = f"{url}&page={page}"

response = requests.get(page_url, headers=headers)

# 解析并存储数据...

注意事项

- 遵守法律法规:爬取数据需遵守《网络安全法》及网站robots协议,避免侵犯他人隐私或商业利益,智联招聘的robots.txt(

https://www.zhaopin.com/robots.txt)明确限制了部分爬取路径,需仔细阅读。 - 反爬应对:若遇到IP封禁,可使用代理IP轮换;出现验证码时,可通过第三方平台(如打码平台)或人工干预解决;对于动态渲染页面,优先使用无头浏览器(如Headless Chrome)。

- 数据清洗:原始数据可能包含冗余信息(如广告、无关标签),需通过正则表达式或字符串处理进行清洗,例如去除薪资中的“面议”或“K”等非数字字符。

- 频率控制:设置合理的请求间隔(如

time.sleep(2)),避免高频请求对服务器造成压力,防止IP被临时封禁。

数据应用场景

爬取的招聘数据可用于多领域分析:

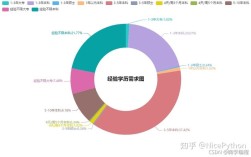

- 就业市场分析:统计特定岗位(如Python工程师)的需求数量、薪资分布、地域差异,为求职者提供参考。

- 企业竞争分析:对比不同公司在同一岗位的招聘要求及薪资水平,了解行业人才竞争态势。

- 趋势预测:结合历史数据,分析热门岗位需求变化趋势,为职业规划或教育机构课程设置提供依据。

以下为Python岗位薪资分布示例(模拟数据):

| 薪资范围(万元/年) | 职位数量 | 占比 |

|---|---|---|

| 8-12 | 120 | 30% |

| 12-18 | 150 | 5% |

| 18-25 | 80 | 20% |

| 25以上 | 50 | 5% |

相关问答FAQs

问题1:爬取智联招聘数据时如何避免被封IP?

解答:避免被封IP需采取多种措施:①使用代理IP池,每次请求更换不同IP;②降低请求频率,设置合理的请求间隔(如3-5秒);③模拟真实浏览器行为,添加随机User-Agent、Referer等请求头;④避免在高峰时段爬取,分散请求时间;⑤若遇到验证码,及时通过打码平台或人工处理,减少无效请求。

问题2:爬取的数据如何用于企业招聘策略优化?

解答:企业可通过分析爬取的招聘数据优化招聘策略:①对比竞品公司的岗位需求及薪资水平,调整自身薪酬体系以吸引人才;②分析目标岗位的技能要求(如Python岗位中“机器学习”“数据分析”等关键词出现频率),优化招聘JD中的技能描述;③统计地域需求分布,针对高需求地区加大招聘力度或设立分支机构;④结合历史数据预测人才需求趋势,提前布局校园招聘或社会招聘计划。