在当今数字化时代,招聘数据已成为企业制定人才战略、求职者规划职业发展的重要参考,爬虫技术作为获取网络数据的高效手段,在招聘数据采集领域发挥着关键作用,通过爬虫技术,企业可以批量抓取各大招聘平台的岗位信息、薪资水平、技能要求等数据,为人才市场分析、薪酬体系设计、招聘策略优化提供数据支撑,爬虫技术的应用也面临着法律法规、技术壁垒、伦理规范等多重挑战,需要从业者全面掌握技术要点,并严格遵守行业准则。

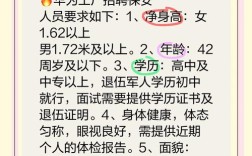

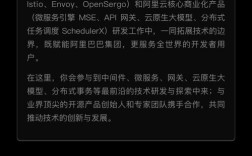

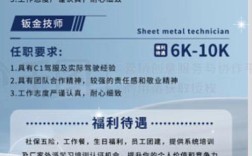

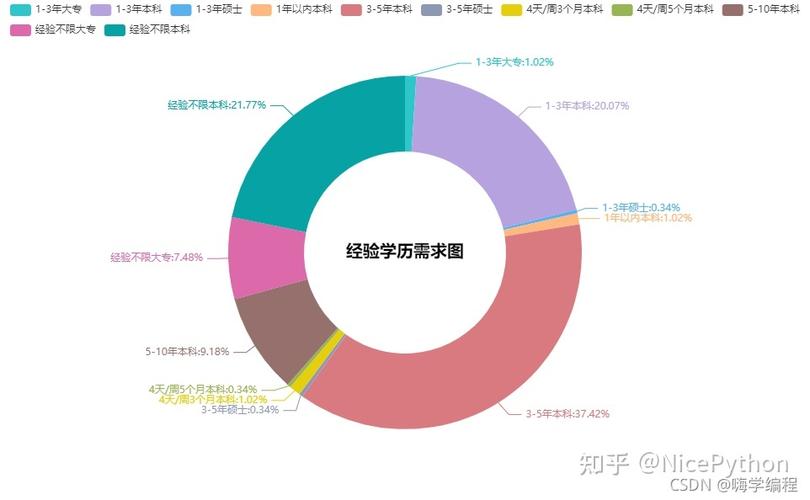

招聘数据爬虫的核心目标是从招聘网站、企业官网、猎头平台等渠道提取结构化数据,常见的数据字段包括职位名称、公司名称、工作地点、薪资范围、学历要求、工作经验、技能标签、公司规模、行业分类、发布时间等,通过爬取智联招聘、前程无忧、BOSS直聘等平台的岗位数据,可以分析不同城市的热门行业需求、技术岗位的薪资分布变化、新兴职业的发展趋势等有价值的信息,这些数据不仅能帮助HR快速了解市场行情,还能为企业人才储备库建设提供动态数据支持。

从技术实现角度看,招聘数据爬虫通常需要经历数据抓取、数据解析、数据清洗与存储三个阶段,数据抓取阶段,开发者需根据目标网站的结构选择合适的爬虫框架,如Python中的Scrapy、BeautifulSoup、Selenium等,静态页面可通过requests库发送HTTP请求获取HTML代码,而动态加载的页面则需要使用Selenium模拟浏览器行为或通过分析接口调用获取JSON数据,BOSS直聘的岗位信息多通过异步加载,需开发者通过浏览器开发者工具定位数据请求接口,构造相应的请求头和参数来获取原始数据。

数据解析阶段,常用的方法有正则表达式、XPath、CSS选择器等,正则表达式适用于提取特定格式的文本,如薪资范围“15k-25k”;XPath和CSS选择器则能精准定位HTML元素中的结构化数据,使用XPath可以快速提取网页中的职位标题、公司名称等信息,对于复杂的嵌套结构,可能需要结合多种解析工具,部分网站采用反爬虫机制,如验证码、IP限制、动态JS加密等,此时需通过代理IP池、验证码识别服务、模拟用户行为等技术手段绕过限制。

数据清洗与存储阶段,需对原始数据进行去重、标准化处理,将“本科及以上”“本科及以上学历”统一为“本科”;将“北京-朝阳区”“北京市朝阳区”标准化为“北京-朝阳区”,清洗后的数据可存储在MySQL、MongoDB等数据库中,或直接导出为CSV、Excel格式进行分析,对于大规模数据采集,还需考虑分布式爬虫架构,如使用Scrapy-Redis实现多节点协同抓取,提高数据采集效率。

招聘数据爬虫的应用必须严格遵守法律法规和伦理规范。《中华人民共和国网络安全法》《数据安全法》《个人信息保护法》明确规定,爬虫不得侵犯他人隐私、不得过度采集数据、不得用于非法用途,爬取求职者的简历信息需获得用户明确授权,企业内部数据未经许可不得对外公开,爬虫行为需尊重目标网站的robots协议,避免对服务器造成过大压力,合理设置请求频率,在实际操作中,建议采用API接口获取数据(若平台提供),或与数据服务商合作,确保数据来源的合法合规性。

招聘数据爬虫的价值体现在多个场景,在企业端,可通过分析历史招聘数据预测未来人才需求变化,优化招聘渠道投入;在薪酬管理方面,可结合市场薪资数据制定具有竞争力的薪酬体系;在职业规划中,求职者可通过行业岗位分布数据了解目标岗位的技能要求和职业发展路径,某互联网公司通过爬取近三年的前端开发岗位数据,发现Vue.js技能需求占比从30%上升至60%,据此调整了技术招聘重点和内部培训方向。

以下是招聘数据爬虫的关键技术要点总结:

| 技术环节 | 常用工具/方法 | 注意事项 |

|---|---|---|

| 目标分析 | 浏览器开发者工具、Postman | 识别数据加载方式(静态/动态) |

| 请求构造 | requests、Selenium、代理IP池 | 设置随机User-Agent,避免被封禁 |

| 数据解析 | BeautifulSoup、XPath、正则表达式 | 处理异常数据,解析效率优化 |

| 反爬应对 | 验证码识别(OCR)、Cookie池、模拟登录 | 遵守robots协议,控制请求频率 |

| 数据存储 | MySQL、MongoDB、CSV文件 | 建立数据索引,支持高效查询 |

| 分布式部署 | Scrapy-Redis、Celery | 节点任务分配,数据去重机制 |

在实际应用中,招聘数据爬虫也面临诸多挑战,招聘平台不断升级反爬虫策略,如增加滑块验证码、行为检测等,要求开发者持续优化技术方案;数据质量问题直接影响分析结果,如岗位描述中的技能标签不统一、薪资数据缺失等,需要通过数据清洗算法和人工校验相结合的方式解决,不同平台的字段定义存在差异,需建立统一的数据标准才能实现跨平台数据整合。

为了充分发挥招聘数据爬虫的价值,企业需建立完善的数据治理体系,包括明确数据采集范围、制定数据质量标准、规范数据使用权限等,人力资源部门可基于爬虫数据构建人才市场洞察报告,定期更新行业薪酬趋势报告;技术研发团队可利用岗位技能需求数据优化招聘画像,提升人岗匹配度,企业应关注数据安全,对敏感数据进行脱敏处理,防止数据泄露风险。

相关问答FAQs:

Q1: 招聘数据爬虫是否违法?如何确保数据采集的合法性?

A1: 招聘数据爬虫的合法性取决于采集目的、数据范围和使用方式,若仅采集公开的岗位信息(如职位名称、薪资范围、公司名称等),且用于企业内部人才分析、市场研究等非商业用途,且遵守目标网站的robots协议,通常不涉及违法,但若采集求职者简历信息、联系方式等个人隐私数据,或用于倒卖数据、恶意竞争等非法行为,则违反《个人信息保护法》等法律法规,确保合法性的关键包括:① 优先使用平台提供的官方API接口;② 仅采集公开非隐私数据;③ 设置合理的爬取频率,避免对服务器造成压力;④ 数据内部使用,不对外公开或售卖。

Q2: 如何应对招聘平台的反爬虫机制?

A2: 应对反爬虫机制需采取综合技术手段:① 使用代理IP池轮换访问地址,避免单一IP高频请求;② 模拟真实浏览器行为,如设置User-Agent、Referer、Cookie等请求头,使用Selenium或Playwright模拟人工操作;③ 处理验证码,可通过OCR技术识别简单验证码,或使用第三方打码平台处理复杂验证码;④ 动态分析接口,通过浏览器开发者工具定位异步加载的数据接口,直接调用API获取数据;⑤ 分布式爬虫架构,多节点协同抓取,降低单节点请求频率;⑥ 定期更新爬虫策略,适应平台反爬虫规则的调整,需注意平衡数据采集效率与网站服务器负载,避免过度爬取影响平台正常运营。