要从网站获取大数据,需要系统性的方法,涵盖数据采集、清洗、存储、分析等全流程,整个过程需结合技术工具、法律法规和伦理规范,确保数据的合法性、有效性和可用性,以下从具体步骤、技术工具和注意事项三个方面展开说明。

明确数据需求与目标

在采集数据前,需先明确业务目标,例如分析用户行为、监测市场趋势、优化产品功能等,不同目标对应的数据类型和采集维度差异很大:若分析用户行为,需关注页面浏览量、点击路径、停留时间等;若监测竞品动态,需采集价格变动、促销活动、用户评价等,目标越清晰,后续数据采集的效率和针对性越高,避免陷入“为采集而采集”的误区。

选择合法合规的数据采集方式

公开API接口

许多网站(如社交媒体、电商平台)提供开放平台API(如Twitter API、淘宝开放平台),允许开发者通过授权获取结构化数据,API接口的优势是数据格式规范、更新及时,且通常有调用频率限制,避免对目标网站造成压力,使用API需注册开发者账号,申请密钥(API Key/Secret),并遵循接口文档的调用规范,例如通过RESTful API发送GET/POST请求,解析返回的JSON或XML格式数据。

网页爬虫技术

对于未提供API的网站,可使用爬虫工具采集数据,常用爬虫工具包括Python库(如Scrapy、BeautifulSoup、Selenium)、八爪鱼等可视化爬虫软件,爬虫的基本流程为:发送HTTP请求(模拟浏览器行为)→ 解析HTML页面(提取目标数据)→ 存储数据(数据库或文件),使用Scrapy框架可定制爬虫规则,设置请求头(User-Agent)模拟真实用户访问,通过XPath或CSS选择器精准定位数据字段(如商品标题、价格、评论)。

第三方数据服务商

部分企业通过购买第三方数据服务获取大数据,如艾瑞咨询、易观分析等市场研究机构提供的行业报告,或数据交易平台(如Kaggle、DataMarket)上的公开数据集,这种方式的优势是数据经过清洗和标注,可直接用于分析,但需注意数据来源的合法性和版权问题。

用户行为埋点

针对自有网站,可通过埋点技术记录用户行为数据,常用工具包括Google Analytics、百度统计、神策数据等,通过在网站前端嵌入JavaScript代码,捕获用户点击、页面停留、转化路径等数据,埋点需提前规划事件模型,明确需采集的字段(如按钮ID、停留时长、设备类型),确保数据与业务目标匹配。

数据采集过程中的技术要点

处理反爬机制

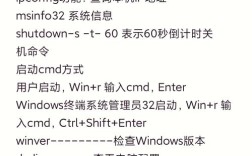

网站通常通过反爬策略保护数据,如IP封禁、验证码、动态加载等,应对措施包括:使用代理IP池轮换访问地址;降低请求频率(如设置随机延时);通过Selenium或Playwright模拟浏览器操作(如处理JavaScript渲染页面);使用OCR识别验证码(如Tesseract库),对于复杂动态页面,需分析XHR请求,直接抓取接口数据而非解析HTML。

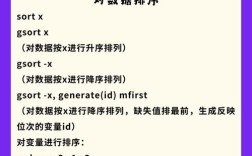

数据清洗与预处理

原始数据往往存在噪声,需通过清洗提升质量,常见操作包括:去重(删除重复记录)、去噪(过滤无意义字符,如HTML标签)、填补缺失值(用均值、众数或插值法填充)、格式标准化(如统一日期格式、货币单位),采集的用户评论中可能包含特殊符号或乱码,需通过正则表达式或字符串处理函数清洗;价格数据可能包含“¥”“,”等字符,需转换为数值型以便分析。

数据存储与管理

大数据需选择合适的存储方案,平衡查询效率、扩展性和成本,常用存储工具包括:

- 关系型数据库(如MySQL、PostgreSQL):适合存储结构化数据(如用户信息、交易记录),支持复杂查询,但扩展性较差。

- NoSQL数据库(如MongoDB、Redis):适合存储非结构化或半结构化数据(如文本、JSON格式评论),支持分布式存储,灵活性强。

- 数据仓库(如Hive、ClickHouse):适合海量数据存储与分析,支持高并发查询,常用于商业智能(BI)场景。

- 文件存储(如CSV、JSON、Parquet):适合小规模数据或临时存储,Parquet列式存储格式可提升大数据查询效率。

存储时需设计合理的数据模型,例如MongoDB可采用嵌套文档存储用户行为数据,MySQL可通过分表分库应对高并发。

数据分析与价值挖掘

数据采集存储后,需通过分析挖掘其价值,常用方法包括:

- 描述性分析:总结数据特征,如通过均值、中位数、频率统计用户平均停留时长、热门商品排名。

- 诊断性分析:探究数据背后的原因,如通过漏斗分析定位用户流失环节,通过相关性分析判断广告投放与转化的关系。

- 预测性分析:构建机器学习模型预测趋势,如用时间序列模型预测销量,用分类模型预测用户流失风险。

- 指导性分析:基于分析结果提出行动建议,如优化页面布局、调整营销策略。

分析工具方面,Python的Pandas、NumPy库适合数据清洗与计算,Scikit-learn、TensorFlow用于机器学习建模;Tableau、Power BI等BI工具支持可视化报表生成,直观展示分析结果。

注意事项与合规要求

- 遵守法律法规:数据采集需符合《网络安全法》《数据安全法》《个人信息保护法》等规定,不得采集敏感信息(如身份证号、密码),需对用户数据脱敏处理(如手机号隐藏中间四位)。

- 尊重网站robots协议:robots.txt是网站告知爬虫哪些页面可爬取的协议,需优先遵守,避免爬取禁止访问的页面。

- 控制采集频率:高频请求可能导致服务器负载过高,甚至被法律追责,需合理设置爬虫间隔,避免对目标网站造成干扰。

- 数据安全:采集的数据需加密存储(如使用AES算法),传输过程采用HTTPS协议,防止数据泄露或篡改。

相关问答FAQs

问题1:使用爬虫采集网站数据时,如何避免被封禁IP?

解答:避免IP封禁需采取多方面措施:①使用代理IP池(如付费代理服务商或免费代理列表)轮换访问IP,避免单一IP高频请求;②设置随机延时(如1-5秒),模拟人类用户操作节奏;③在请求头中添加真实浏览器标识(如User-Agent、Referer),避免被识别为爬虫;④使用分布式爬虫框架(如Scrapy-Redis),将任务分配到多个节点,分散IP压力;⑤遵守目标网站的robots协议,不爬取禁止访问的页面;⑥对于动态验证码,可结合OCR工具或打码平台识别,必要时人工干预,若仍被封禁,需暂停一段时间并更换IP段。

问题2:如何判断采集到的数据质量是否达标?

解答:数据质量可通过以下维度评估:①完整性:检查关键字段(如用户ID、时间戳)的缺失值比例,若缺失率超过10%需分析原因(如采集失败或字段不可用);②准确性:对比人工抽样数据或权威数据源,验证数据是否存在偏差(如价格数据是否与官网一致);③一致性:确保数据格式统一(如日期格式均为“YYYY-MM-DD”,货币单位均为“元”);④时效性:检查数据更新时间,分析业务场景对实时性的要求(如实时监控需延迟在1分钟内,历史分析可接受延迟1天);⑤唯一性:通过主键或唯一标识符检查重复数据,确保每条记录无冗余,若数据质量不达标,需返回清洗环节优化采集或处理逻辑。