在Hadoop分布式文件系统(HDFS)中,创建文件夹是基础且频繁的操作,通常通过Hadoop提供的命令行工具(hadoop fs或hdfs dfs)实现,以下是关于Hadoop创建文件夹命令的详细说明,包括命令语法、参数选项、使用场景及注意事项。

基本命令语法

Hadoop创建文件夹的核心命令为hadoop fs -mkdir或hdfs dfs -mkdir,两者的功能完全一致,hdfs dfs是hadoop fs的别名,推荐使用hdfs dfs以明确操作对象为HDFS,基本语法如下:

hdfs dfs -mkdir [-p] <路径>

-p:可选参数,表示递归创建父目录(若父目录不存在),类似于Linux中的mkdir -p。<路径>:必选参数,指定要创建的文件夹路径,可以是绝对路径(如/user/data)或相对路径(如data),相对路径默认基于用户在HDFS中的 home 目录(通常为/user/<当前用户名>)。

参数选项详解

-

-p参数的使用

若不使用-p,当父目录不存在时,命令会报错(创建/user/data/logs时,若/user/data不存在,则执行失败),使用-p可自动创建所需的父目录,适合复杂目录结构的初始化。

示例:hdfs dfs -mkdir -p /user/hadoop/project/logs

此命令会依次创建

/user、/user/hadoop、/user/hadoop/project和/user/hadoop/project/logs(若这些目录不存在)。 -

路径格式规范

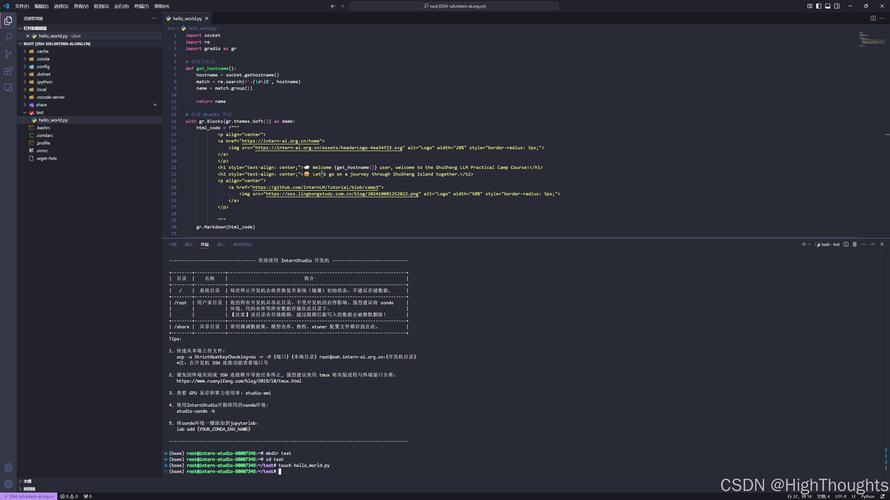

(图片来源网络,侵删)

(图片来源网络,侵删)- HDFS路径需以开头(绝对路径)或基于用户home目录(相对路径)。

- 路径中不能包含空格或特殊字符(如、),若需包含,需用反斜杠

\转义或用引号包裹(如"my folder")。 - 路区分大小写,且支持Unicode字符(但需确保集群配置支持)。

使用场景与示例

-

创建单级目录

在当前用户home目录下创建input文件夹:hdfs dfs -mkdir input

等价于

hdfs dfs -mkdir /user/<用户名>/input。 -

创建多级目录(不使用

-p)

若父目录已存在,可直接创建子目录:hdfs dfs -mkdir /user/hadoop/output

若

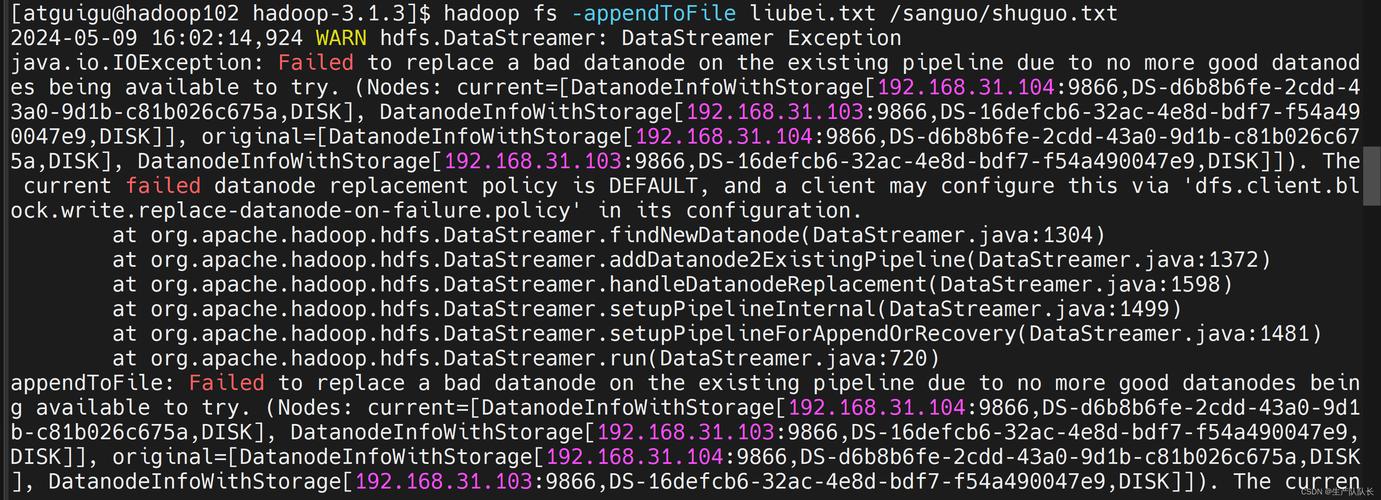

/user/hadoop不存在,命令会报错Failed to create directory /user/hadoop/output。 (图片来源网络,侵删)

(图片来源网络,侵删) -

递归创建多级目录(使用

-p)

一次性创建完整的目录链:hdfs dfs -mkdir -p /data/2023/10/01

此命令无需依赖已存在的父目录,适合初始化数据存储路径。

-

在指定用户目录下创建目录

切换用户后创建目录(需具备相应权限):sudo -u hdfs hdfs dfs -mkdir /user/spark/names

此操作以

hdfs用户身份创建目录,避免权限问题。

权限与注意事项

-

权限要求

- 执行

mkdir的用户需对父目录具备写权限(w)和执行权限(x),用户user1在/user下创建目录时,需/user的权限为rwx(至少wx)。 - 若使用超级用户(如

hdfs或root),可忽略权限限制,但建议避免滥用超级权限。

- 执行

-

常见错误及解决

- 错误1:

mkdir:/user/dataPermission denied

原因:当前用户对/user无写权限。

解决:使用超级用户授权(sudo -u hdfs hdfs dfs -chown -R <用户>:<组> /user/data)或请求管理员分配权限。 - 错误2:

mkdir:/user/dataFile exists

原因:目标目录已存在。

解决:使用-f参数(Hadoop 2.8+支持)忽略错误,或先删除目录(hdfs dfs -rm -r -f /user/data)后重建。 - 错误3:

mkdir:/user/dataNo such file or directory

原因:未使用-p且父目录不存在。

解决:添加-p参数或手动创建父目录。

- 错误1:

-

跨文件系统操作

若路径前缀为file://(本地文件系统)或hdfs://(明确指定HDFS集群),需确保集群名称正确。hdfs dfs -mkdir hdfs://namenode:8020/user/data

其中

namenode为NameNode的主机名或IP。

命令扩展与验证

创建目录后,可通过以下命令验证结果:

-

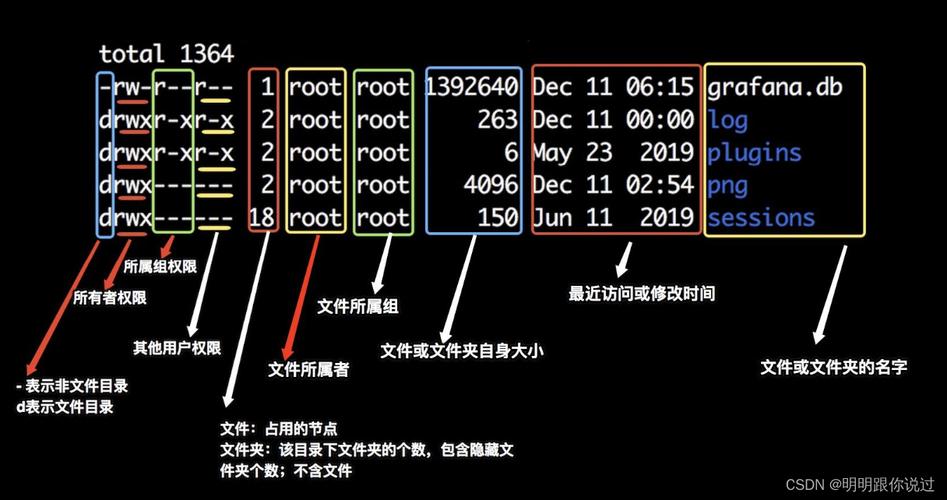

列出目录内容:

hdfs dfs -ls /user/data

若成功,会显示

drwxr-xr-x - <用户> <组> 0 <日期> /user/data,其中d表示目录。 -

查看目录结构:

hdfs dfs -ls -R /user

递归列出

/user下的所有子目录和文件。 -

检查磁盘使用情况:

hdfs dfs -du -s /user/data

显示目录总大小(初始为0,因目录为空)。

相关问答FAQs

问题1:为什么使用hdfs dfs -mkdir时提示“Permission denied”,即使我是文件所有者?”

解答:

HDFS的权限模型与Linux类似,除了文件/目录所有者权限外,还需检查父目录的执行权限(x),若用户user1拥有/user/data的所有权,但/user的权限为r-x(无x),则user1无法进入/user,进而无法在/user/data下创建子目录,解决方法是使用超级用户为/user添加执行权限:

sudo -u hdfs hdfs dfs -chmod +x /user

问题2:如何在Hadoop中批量创建多个目录,并避免重复创建时的错误提示?”

解答:

可通过以下两种方式实现批量创建并处理重复问题:

- 使用

-p参数避免依赖父目录:hdfs dfs -mkdir -p /data/{2023/{01..12},2024/{01..12}}此命令会创建

/data/2023/01至/data/2024/12的所有目录,若部分目录已存在,Hadoop会跳过并继续执行(不会报错)。 - 结合

xargs或循环处理(适用于更复杂的逻辑):echo -e "/data/logs\n/data/tmp\n/user/output" | xargs -I {} hdfs dfs -mkdir -p {}或使用shell循环:

for dir in "/data/logs" "/data/tmp" "/user/output"; do hdfs dfs -mkdir -p "$dir" done

若需忽略已存在目录的错误,可添加

2>/dev/null过滤错误信息:hdfs dfs -mkdir /data/logs 2>/dev/null || true