Linux取数据命令是系统管理和数据处理中的核心工具,通过灵活运用命令行指令,用户可以高效地从文件、进程、网络等源头提取、过滤和转换数据,以下将详细介绍常用命令的功能、语法及实际应用场景,帮助读者掌握数据提取的技巧。

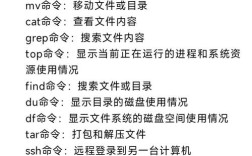

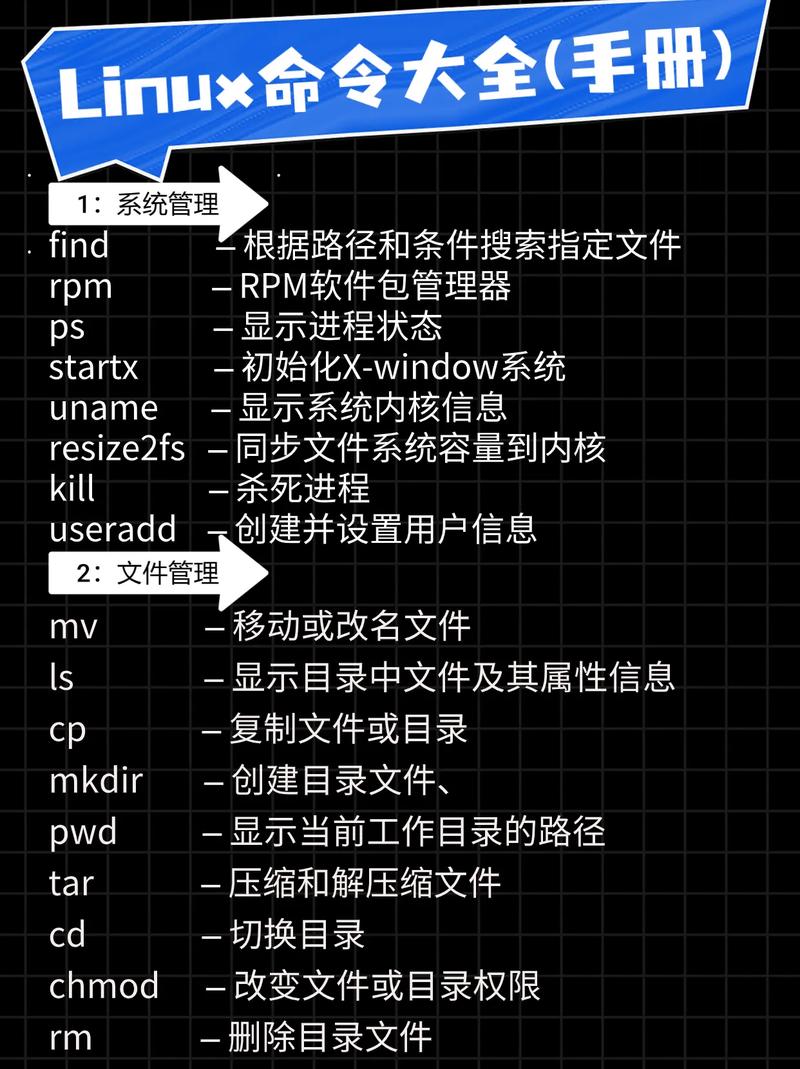

在Linux环境中,数据提取通常涉及读取文件内容、筛选特定信息、处理结构化数据等操作。cat是最基础的文件查看命令,用于显示整个文件内容,例如cat file.txt会直接输出文件的全部文本,但当文件较大时,cat会一次性加载全部内容,可能导致终端卡顿,分页查看命令more和less更为实用:more file.txt支持向下翻页,而less file.txt则支持上下滚动、搜索等交互操作,适合大文件浏览,若仅需查看文件开头或结尾部分,head和tail命令是理想选择,默认情况下,head -n 10 file.txt显示文件前10行,tail -n 5 file.txt显示末尾5行,tail -f还能实时跟踪文件新增内容,常用于监控日志。

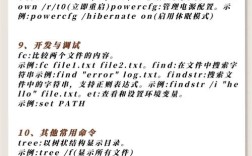

对于需要精确匹配特定模式的数据,grep命令不可或缺,它支持正则表达式,例如grep "error" log.txt会筛选出包含"error"的行,grep -v "warning"则排除包含"warning"的行,结合-i参数可忽略大小写,-r参数可递归搜索目录,若需按列提取数据,cut和awk是强大工具。cut -d: -f1 /etc/passwd以冒号为分隔符提取第一列(用户名),而awk -F: '{print $1,$3}' /etc/passwd不仅能自定义分隔符,还能通过$1、$2引用列,并支持条件判断,如awk '$3>1000 {print}' /etc/passwd筛选UID大于1000的用户。

处理结构化数据时,sort和uniq常配合使用。sort file.txt对文件行进行排序,-n参数按数字排序,-r降序排列;uniq用于去除重复行,需先通过sort排序才能完全去重,例如sort file.txt | uniq -c可统计每行出现次数,若需跨列合并或计算,paste和awk更灵活:paste -d: file1.txt file2.txt按列合并文件,awk '{sum+=$1} END {print sum}' numbers.txt可计算数值总和。

网络数据提取也是常见需求。netstat -tuln显示监听端口,ss -tuln是其现代替代品,性能更优。lsof -i:80查看占用80端口的进程,tcpdump -i eth0 port 80捕获网络数据包,系统状态数据可通过top、htop实时查看进程资源占用,df -h显示磁盘使用情况,free -h查看内存状态。

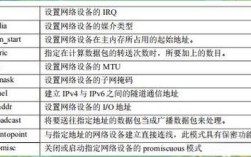

以下是部分命令的参数对比表:

| 命令 | 常用参数 | 功能描述 | 示例 |

|---|---|---|---|

| cat | 无 | 显示文件全部内容 | cat data.txt |

| head | -n 行数 | 显示文件开头指定行 | head -n 20 log.txt |

| tail | -n 行数, -f | 显示文件结尾或实时跟踪 | tail -f access.log |

| grep | -i, -v, -r | 模式匹配,支持正则 | grep "192.168.1" -r /var/log |

| cut | -d 分隔符, -f 列号 | 按列提取数据 | cut -d, -f1 users.csv |

| awk | -F 分隔符, '{print $N}' | 列处理与格式化 | awk -F, '{print $1,$3}' data.csv |

| sort | -n, -r, -k | 排序,支持数字和字段 | sort -k2,2n scores.txt |

| uniq | -c, -d | 去重或统计重复行 | sort file.txt |

| netstat | -tuln | 显示网络连接状态 | netstat -tuln |

实际应用中,命令组合能实现复杂需求,提取日志中错误IP并统计次数:grep "ERROR" log.txt | awk '{print $1}' | sort | uniq -c,若需处理CSV文件,可用awk -F, '{if ($2>100) print $1,$3}' data.csv筛选第二列大于100的记录,对于二进制文件,hexdump -C file.bin可查看十六进制内容,strings file.bin提取可打印字符串。

相关问答FAQs

-

如何从文件中提取特定列的数据?

答:可使用cut或awk命令,以逗号分隔的CSV文件中提取第一列:cut -d, -f1 data.csv;若需提取多列并自定义格式,可用awk -F, '{print $1,$3}' data.csv,其中-F指定分隔符,$1、$3分别表示第一列和第三列。 (图片来源网络,侵删)

(图片来源网络,侵删) -

如何实时监控日志文件并提取特定关键词?

答:结合tail和grep命令可实现,实时监控nginx访问日志并提取包含"404"的行:tail -f /var/log/nginx/access.log | grep "404",若需忽略大小写,可添加-i参数:tail -f access.log | grep -i "error"。