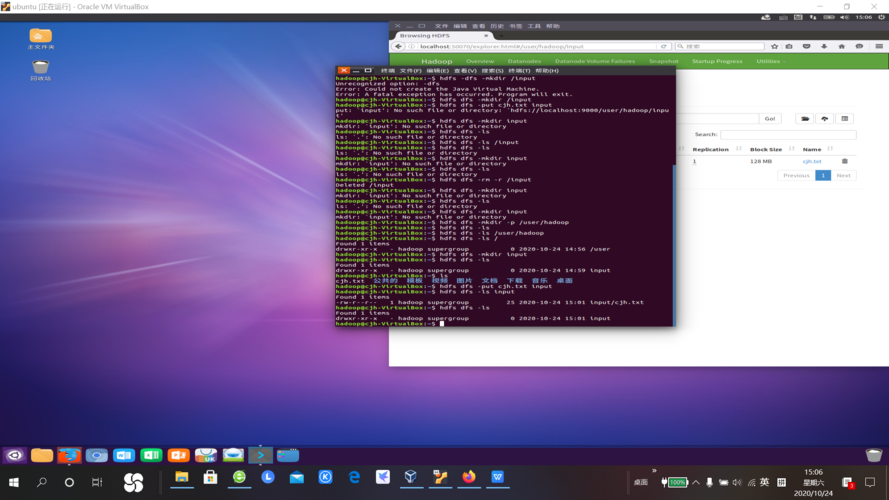

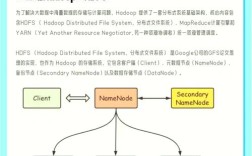

HDFS(Hadoop Distributed File System)作为Hadoop生态的核心组件,提供了分布式文件存储能力,其文件操作命令是用户与HDFS交互的基础,这些命令通过Hadoop Shell实现,语法形式为hadoop fs <command>或hdfs dfs <command>,两者功能基本一致,主要用于文件和目录的创建、删除、查看、移动等操作。

文件与目录操作基础命令

创建目录与文件

- 创建目录:

hadoop fs -mkdir /path/to/directory,可递归创建多级目录(需加-p参数,如hadoop fs -mkdir -p /parent/child)。 - 创建文件:

hadoop fs -touchz /path/to/file,若文件不存在则创建空文件,存在则更新时间戳;也可通过echo "content" | hadoop fs -put - /path/to/file直接写入内容。

查看文件内容

- 查看文件:

hadoop fs -cat /path/to/file,输出文件全部内容到终端,适合小文件;hadoop fs -head /path/to/file查看文件前1KB内容(可通过-n指定行数);hadoop fs -tail /path/to/file查看文件末尾1KB内容(支持-f实时追踪)。 - 查看文件状态:

hadoop fs -stat /path/to/file,显示文件大小、权限、修改时间等信息;hadoop fs -ls -h /path/to/directory以人类可读格式(如KB/MB)列出目录内容,-R可递归显示子目录。

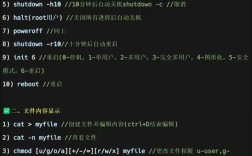

文件与目录的删除

- 删除文件:

hadoop fs -rm /path/to/file,非空文件删除需加-r或-rmr(递归删除);hadoop fs -rmr /path/to/directory(已废弃,建议用-rm -r)。 - 删除空目录:

hadoop fs -rmdir /path/to/empty_directory。

文件上传与下载

- 上传本地文件到HDFS:

hadoop fs -put /local/path /hdfs/path,支持上传目录(需加-r);hadoop fs -copyFromLocal /local/path /hdfs/path功能类似,但put支持从标准输入读取(如echo "data" | hadoop fs -put - /hdfs/file)。 - 下载HDFS文件到本地:

hadoop fs -get /hdfs/path /local/path,下载目录需加-r;hadoop fs -copyToLocal /hdfs/path /local/path功能相同。hadoop fs -appendToFile /local/file /hdfs/file,将本地文件内容追加到HDFS文件末尾。

文件移动与重命名

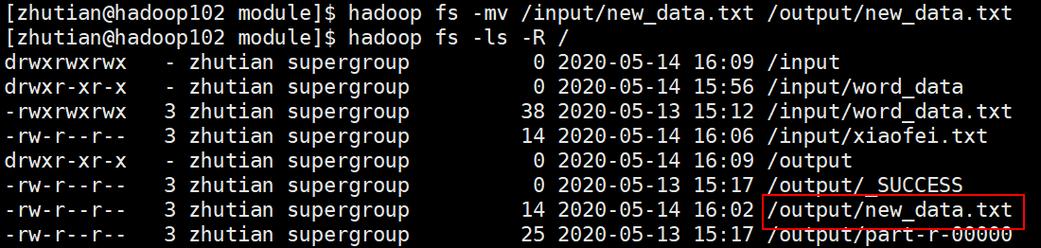

- 移动文件:

hadoop fs -mv /source/path /dest/path,可跨目录移动,也可用于重命名(目标路径与源路径在同一目录时)。 - 复制文件:

hadoop fs -cp /source/path /dest/path,支持递归复制目录(-r)。

文件权限与所有权管理

- 修改权限:

hadoop fs -chmod 755 /path/to/file,权限格式为Linux风格(如755表示所有者读写执行,组和其他用户读执行)。 - 修改所有者:

hadoop fs -chown user:group /path/to/file,需超级用户权限。 - 修改时间戳:

hadoop fs -touch /path/to/file,更新文件的访问和修改时间为当前时间。

文件合并与分块操作

- 合并文件:

hadoop fs -getmerge /hdfs/directory /local/output_file,将HDFS目录下所有文件合并为本地单个文件,-nl参数可在文件间添加换行符。 - 查看文件块信息:

hadoop fs -du -h /path/to/file显示文件大小及占用空间(考虑副本数);hadoop fs -count /path/to/directory统计目录下文件数量、目录数量和总大小。

常用命令操作示例表格

| 命令分类 | 命令格式 | 功能说明 |

|---|---|---|

| 目录操作 | hadoop fs -mkdir -p /dir1/dir2 |

递归创建多级目录 |

| 文件查看 | hadoop fs -cat /file.txt |

查看文件全部内容 |

| 文件删除 | hadoop fs -rm -r /dir |

递归删除目录及其内容 |

| 文件上传 | hadoop fs -put local.txt /hdfs/ |

上传本地文件到HDFS |

| 文件下载 | hadoop fs -get /hdfs/file.txt ./ |

下载HDFS文件到当前目录 |

| 权限修改 | hadoop fs -chmod 644 /file.txt |

设置文件权限为所有者读写,组和其他用户只读 |

| 文件统计 | hadoop fs -count /dir |

统计目录下文件数、目录数和总大小 |

相关问答FAQs

Q1: HDFS中删除大文件时,如何避免因文件过多导致命令执行缓慢?

A: 可使用hadoop fs -rm -r -skipTrash /large_directory,其中-skipTrash参数跳过回收站直接删除,减少移动文件到回收站的时间开销;若文件数量极大,可结合hadoop fs -find命令先筛选目标文件,再批量删除,例如通过脚本循环执行hadoop fs -rm删除特定模式的文件。

Q2: 如何确认HDFS文件是否成功上传且数据完整?

A: 可通过以下步骤验证:1. 使用hadoop fs -ls -h /path/to/file检查文件大小是否与本地一致;2. 使用hadoop fs -checksum /path/to/file获取文件的校验和(如CRC32),与本地文件校验和对比;3. 使用hadoop fs -cat /path/to/file | md5sum计算HDFS文件的MD5值,与本地文件MD5值比对,确保数据无损坏。