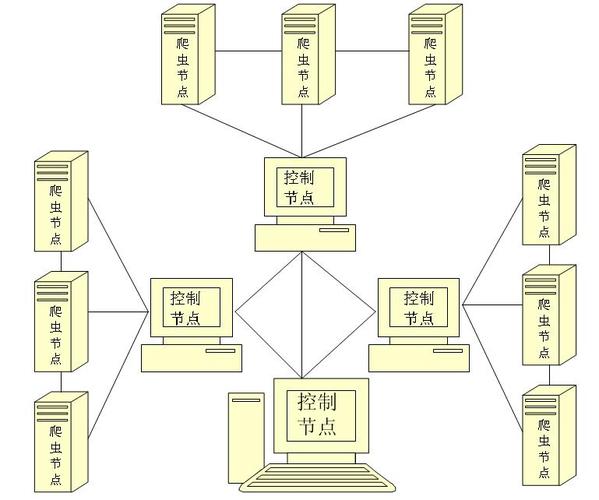

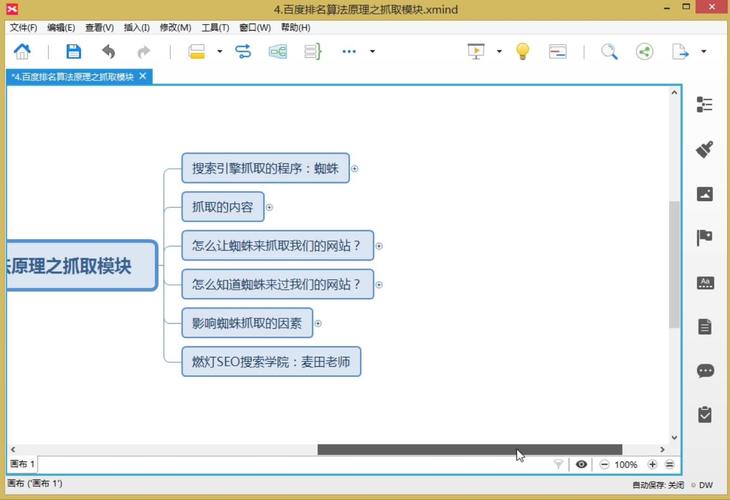

蜘蛛抓取网页的过程,本质上是搜索引擎通过特定的程序(称为蜘蛛或爬虫)自动发现、下载并存储网页内容的技术流程,这一过程是搜索引擎建立索引的基础,类似于传统图书馆中图书管理员收集书籍并编制目录的过程,蜘蛛抓取网页并非随机进行,而是遵循一套复杂的算法和策略,以确保高效、全面地覆盖互联网上的有效信息。

蜘蛛抓取网页的第一步是从一个或多个初始URL开始,这些URL被称为“种子URL”,种子URL通常是人工选择的,包含了一些知名网站、高价值页面或不同领域的代表性网址,蜘蛛将这些URL存入一个称为“待抓取队列”(URL Frontier)的数据结构中,随后按照一定的优先级规则从中取出URL进行抓取,优先级的确定可能基于多种因素,如页面的更新频率、链接数量、域名权重等,热门或频繁更新的页面通常会被优先处理。

当蜘蛛访问一个URL时,它会向目标服务器发送一个HTTP请求,类似于用户在浏览器中输入网址并访问,服务器收到请求后,会返回网页的HTML内容,蜘蛛解析返回的HTML代码,提取其中包含的关键信息,主要包括两部分:一是页面的实际内容(如标题、正文、图片、视频等),二是页面中指向其他URL的链接,提取的内容会被进一步处理,去除HTML标签、JavaScript代码等无关信息,然后进行分词、去重等操作,为后续建立索引做准备,而提取的链接则会被添加到待抓取队列中,形成“抓取-发现新链接-继续抓取”的循环链路。

蜘蛛在抓取过程中需要遵守一定的规则,以避免对目标服务器造成过大压力,同时避免陷入抓取陷阱,这些规则通常通过网站的robots.txt文件来体现,robots.txt是一个位于网站根目录下的文本文件,它向搜索引擎蜘蛛声明了网站中哪些页面可以抓取、哪些页面禁止抓取,一个网站的robots.txt可能包含类似“Disallow: /admin/”的指令,表示蜘蛛不应访问管理员目录下的页面,蜘蛛在抓取前会首先读取并解析robots.txt文件,确保抓取行为符合网站的规定,蜘蛛还会根据HTTP响应头中的信息(如“Cache-Control”指令)来判断是否需要缓存页面内容,或根据“Last-Modified”等字段判断页面是否更新,以避免重复抓取未变化的页面。

为了提高抓取效率,蜘蛛采用了一系列优化策略,DNS缓存、连接池和并行抓取是关键技术,DNS缓存可以减少域名解析的时间消耗;连接池则允许蜘蛛与服务器保持多个持久连接,避免频繁建立和断开连接的开销;并行抓取则让蜘蛛能够同时处理多个URL,大幅提升抓取速度,并行抓取的并发数需要合理控制,过高的并发可能导致服务器响应缓慢甚至拒绝服务,蜘蛛还需要处理动态网页(如通过JavaScript生成的页面),这类页面可能需要模拟浏览器行为执行脚本后才能获取完整内容,这对蜘蛛的技术能力提出了更高要求。

蜘蛛抓取的覆盖范围和效率直接影响搜索引擎的索引质量,为了发现更多新页面,蜘蛛会重点关注页面间的链接关系,尤其是高权重页面指向的链接,因为这些链接往往指向质量较高的内容,蜘蛛也会定期重新抓取已索引的页面,以更新内容变化,确保索引的时效性,对于大型网站,蜘蛛可能会采用“增量抓取”策略,即只抓取自上次访问后发生变化的页面,从而节省资源。

以下是关于蜘蛛抓取网页的相关问答FAQs:

Q1: 蜘蛛抓取网页时,为什么有些页面无法被收录?

A1: 页面无法被收录通常由以下原因造成:一是robots.txt文件禁止了蜘蛛抓取该页面;二是页面存在死链(404错误)或服务器无法访问;三是页面内容重复度过高,被蜘蛛判定为低价值或重复内容;四是页面使用了动态技术(如JavaScript渲染),蜘蛛无法正确解析内容;五是页面权重过低,未被蜘蛛及时发现或抓取优先级较低,页面存在大量垃圾链接或违反搜索引擎规则也可能导致无法收录。

Q2: 如何提高网站页面的抓取效率?

A2: 提高页面抓取效率可以从以下几个方面优化:一是确保robots.txt文件配置正确,既不屏蔽重要页面,又能引导蜘蛛抓取核心内容;二是优化网站结构,采用扁平化的目录层级,减少页面点击深度;三是增加内部链接,确保重要页面能通过其他页面被蜘蛛发现;四是提高页面加载速度,避免因服务器响应慢导致抓取超时;五是定期检查并修复死链,保持网站健康;六是合理设置sitemap.xml文件,主动向蜘蛛提交页面地址,帮助蜘蛛更快发现和抓取内容。