HDFS的cp命令是Hadoop分布式文件系统中最基础且常用的命令之一,其核心功能是在HDFS文件系统内部进行文件或目录的复制操作,与Linux本地文件系统的cp命令类似,HDFS cp允许用户将数据从源路径复制到目标路径,但其在底层实现、跨节点数据传输以及与HDFS分布式特性相关的功能上存在显著差异,本文将详细解析HDFS cp命令的语法、功能特性、使用场景、注意事项以及与其他相关命令的对比,并通过实际案例帮助读者深入理解其应用。

HDFS cp命令的基本语法与功能

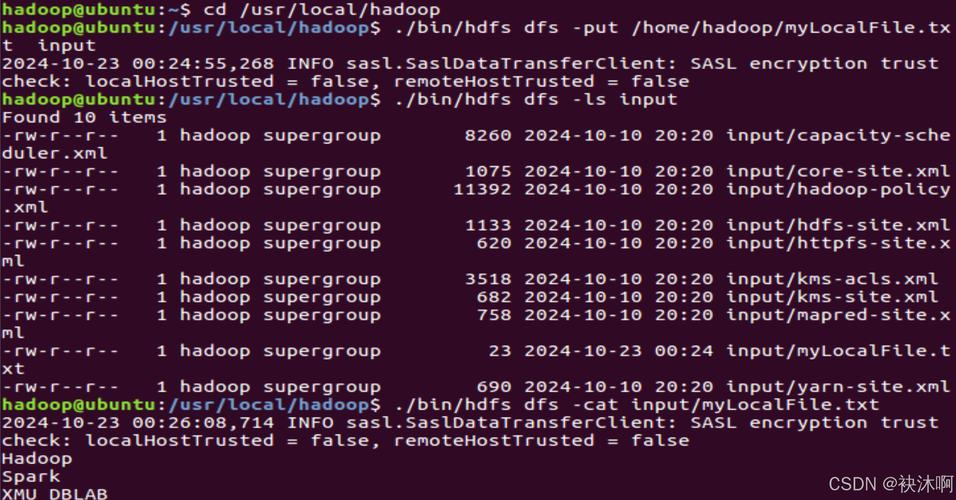

HDFS cp命令的基本语法结构为:hadoop fs -cp [OPTIONS] <src>... <dst>。OPTIONS为可选参数,src表示源文件或目录路径,可以是一个或多个,dst表示目标路径,当源路径为多个时,目标路径必须是一个已存在的目录,否则命令会报错。hadoop fs -cp /input/file1.txt /input/file2.txt /output/会将file1.txt和file2.txt复制到/output目录下;而hadoop fs -cp /input/file1.txt /output/file1_copy.txt则会将file1.txt复制为output目录下的file1_copy.txt。

在功能实现上,HDFS cp命令通过调用HDFS的文件系统API完成复制操作,其核心流程包括:首先验证源路径是否存在,然后检查目标路径的合法性(如是否覆盖已有文件、目录权限等),最后启动数据复制任务,值得注意的是,HDFS cp是“分布式复制”,即如果源文件和目标文件位于不同DataNode节点,数据会通过HDFS的流水线机制(Pipeline)从源节点读取,经过多个中间节点传输到目标节点,而非直接从客户端节点中转,这保证了数据传输的高效性和容错性。

HDFS cp命令的关键特性与参数

HDFS cp命令支持多种参数,以适应不同的使用场景,以下是几个常用参数及其作用:

| 参数 | 全称 | 功能说明 | 示例 |

|---|---|---|---|

-f |

--force |

强制复制,若目标文件已存在则覆盖 | hadoop fs -cp -f /old/file.txt /new/file.txt |

-p |

--preserve |

保留源文件的属性(如权限、时间戳、所有者等) | hadoop fs -cp -p /data/file.log /backup/ |

-r 或 -R |

--recursive |

递归复制目录及其所有子目录和文件 | hadoop fs -cp -r /dir1 /dir2 |

-p参数在数据备份场景中尤为重要,它可以确保复制后的文件与源文件在属性上完全一致,避免因权限或时间戳差异导致的问题,而-r参数是复制目录的必要条件,与Linux的cp -r类似,用于处理包含大量文件的目录结构。

HDFS cp的使用场景与注意事项

HDFS cp命令广泛应用于数据备份、数据迁移、目录整理等场景,在数据处理流程中,经常需要将原始数据从/input目录复制到/processing目录进行处理,此时可通过hadoop fs -cp -r /input /processing快速完成数据复制,当需要对数据进行版本管理时,也可使用cp命令将当前数据快照复制到备份目录,如hadoop fs -cp -p /data/current /data/v20230101。

尽管HDFS cp功能强大,但在使用时仍需注意以下几点:

- 性能问题:对于大文件或大量小文件的复制,HDFS cp的效率可能低于DistCp(分布式复制工具),DistCp通过MapReduce任务实现并行复制,更适合TB级数据的跨集群或异构文件系统迁移。

- 数据一致性:HDFS cp是异步操作,复制过程中若客户端或集群节点异常中断,可能导致目标文件不完整,建议在关键业务场景中结合

hadoop fs -test或hadoop fs -checksum验证文件完整性。 - 权限与配额:复制操作需要用户对源路径有读取权限,对目标路径有写入权限,若目标目录所在文件系统空间配额不足,复制会失败,需提前通过

hadoop fs -count -q检查配额使用情况。

HDFS cp与其他复制命令的对比

除了HDFS cp,Hadoop生态中还有其他复制工具,如DistCp和DistCp2,DistCp(hadoop distcp)专为大规模数据复制设计,支持多源、多目标并行复制,并具备增量复制功能,适用于跨集群数据同步,而HDFS cp更适合小规模数据或单文件/目录的快速复制,其语法更简单,无需额外配置,复制单个10GB的文件,使用hadoop fs -cp可能只需几秒钟,而DistCp因需要启动MapReduce任务,耗时更长但更适合TB级数据。

相关问答FAQs

Q1: HDFS cp命令能否在不同HDFS集群之间复制文件?

A1: 原生HDFS cp命令不支持跨集群复制,其设计仅用于同一HDFS集群内部的文件操作,若需跨集群复制,应使用DistCp工具,并通过-update或overwrite参数控制同步策略。hadoop distcp -update hdfs://cluster1/data hdfs://cluster2/backup可将cluster1的data目录增量复制到cluster2的backup目录。

Q2: 使用HDFS cp复制大文件时,如何监控复制进度?

A2: HDFS cp本身不提供实时进度监控,但可通过以下方式间接观察:1)使用hadoop fs -du -h <target_path>定期检查目标文件大小变化;2)通过YARN Web UI(默认端口8088)查看MapReduce任务进度(若使用DistCp);3)结合hadoop fs -count统计文件数量和块数量,判断复制是否完成,对于超大规模文件,建议使用DistCp并启用-log参数记录复制日志。