HDFS(Hadoop Distributed File System)是Hadoop生态系统中的核心组件,用于存储大规模数据集,其命令行工具hdfs dfs(或hdfs fs)是用户与HDFS交互的主要方式,通过hdfs fs命令,用户可以执行文件和目录的创建、删除、查看、移动等操作,类似于Linux文件系统的命令,但针对分布式环境进行了优化,以下将详细介绍hdfs fs命令的常用功能、语法结构及实际应用场景。

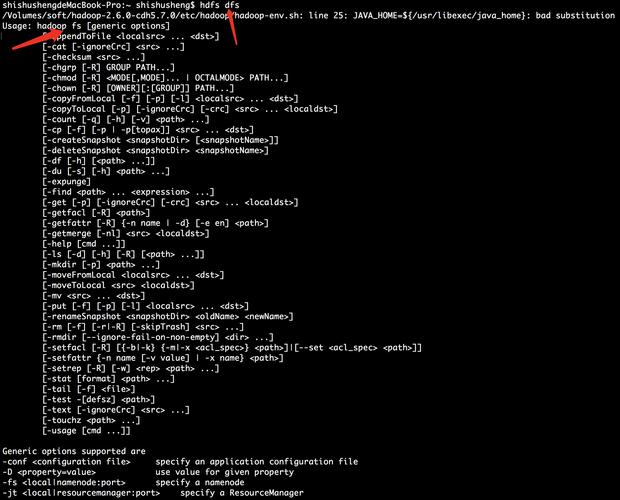

基本语法与通用参数

hdfs fs命令的基本语法为:hdfs fs [generic options] [command] [arguments]。generic options是所有命令共用的参数,如-fs指定文件系统地址(默认为当前HDFS集群),-conf指定配置文件路径,-D用于设置属性(如-D dfs.replication=3设置副本数)。command为具体操作指令,如ls、mkdir等,arguments为操作的目标路径或参数。

常用命令分类及示例

文件与目录管理

- 查看目录内容:

hdfs fs -ls <path>列出指定路径下的文件和目录,类似于Linux的ls命令。hdfs fs -ls /user/hadoop会显示HDFS上/user/hadoop,使用-h参数可显示人类可读的文件大小(如KB、MB),如hdfs fs -ls -h /user/hadoop/input。 - 创建目录:

hdfs fs -mkdir <path>用于创建目录。hdfs fs -mkdir /user/hadoop/output会在HDFS上创建output目录,若需创建多级目录,需使用-p参数,如hdfs fs -mkdir -p /user/hadoop/data/2023。 - 删除文件或目录:

hdfs fs -rm <path>删除文件,-r或-rmr可递归删除目录及其内容。hdfs fs -rm -r /user/hadoop/output会删除output目录及其所有子文件,需注意,删除操作不可逆,HDFS默认不提供回收站功能(需启用trash配置)。 - 移动或重命名文件:

hdfs fs -mv <src> <dst>用于移动文件或重命名。hdfs fs -mv /user/hadoop/input/file1.txt /user/hadoop/output/将file1.txt移动到output目录下,若目标路径与源路径仅文件名不同,则实现重命名功能。 - 复制文件:

hdfs fs -cp <src> <dst>复制文件或目录。hdfs fs -cp /user/hadoop/input/file1.txt /user/hadoop/backup/将文件复制到backup目录,若需递归复制目录,需使用-r参数。

操作

- 查看文件内容:

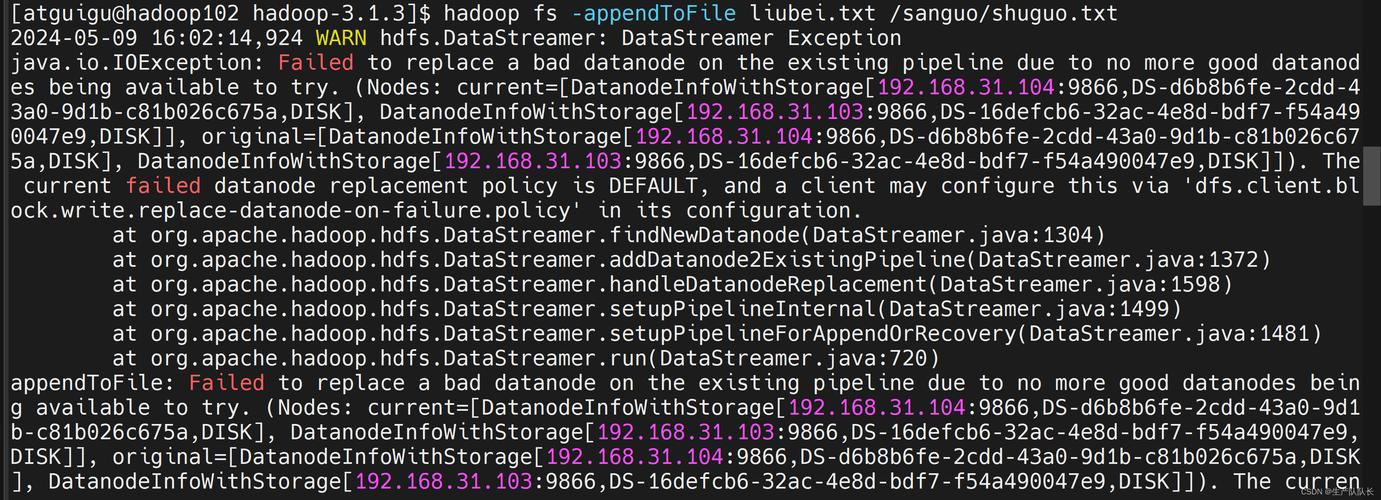

hdfs fs -cat <path>用于显示文件内容,类似于Linux的cat命令。hdfs fs -cat /user/hadoop/input/file1.txt会打印文件内容,对于大文件,可结合-head或-tail查看部分内容,如hdfs fs -head -n 100 /user/hadoop/input/file1.txt显示前100行。 - :

hdfs fs -appendToFile <localSrc> <hdfsDst>将本地文件内容追加到HDFS文件中。hdfs fs -appendToFile local.txt /user/hadoop/output/file1.txt会将本地local.txt追加到HDFS的file1.txt末尾,若目标文件不存在,则会创建新文件。 - 获取文件:

hdfs fs -get <hdfsSrc> <localDst>将HDFS文件下载到本地文件系统。hdfs fs -get /user/hadoop/output/file1.txt ./会将文件下载到当前本地目录,使用-getmerge可合并多个HDFS文件并下载到本地,如hdfs fs -getmerge /user/hadoop/input/* ./merged.txt。 - 上传文件:

hdfs fs -put <localSrc> <hdfsDst>将本地文件上传到HDFS。hdfs fs -put local.txt /user/hadoop/input/上传文件,若需上传目录,需使用-r参数。

文件系统信息与维护

- 查看磁盘使用情况:

hdfs fs -du <path>显示目录或文件的大小及占用空间。hdfs fs -du -h /user/hadoop会以人类可读格式显示/user/hadoop目录下各子文件的大小总和,结合-s参数可汇总显示总大小,如hdfs fs -du -s -h /user/hadoop。 - 检查文件完整性:

hdfs fs -checksum <path>用于验证文件的校验和。hdfs fs -checksum /user/hadoop/input/file1.txt会显示文件的MD5校验和,用于确保文件传输或存储的完整性。 - 设置文件权限:

hdfs fs -chmod <mode> <path>修改文件或目录的权限。hdfs fs -chmod 755 /user/hadoop/output将权限设置为rwxr-xr-x,HDFS权限模型与Linux类似,但仅支持所有者、组和其他用户的读/写/执行权限。 - 设置文件所有者:

hdfs fs -chown [-R] [owner][:group] <path>修改文件所有者或所属组。hdfs fs -chown hadoop:hadoop /user/hadoop/output将output目录的所有者改为hadoop用户,所属组改为hadoop组,使用-R可递归修改子文件和目录。

高级操作与注意事项

- 分布式文件系统操作:

hdfs fs命令支持跨集群操作,通过-fs hdfs://namenode:port指定不同的HDFS集群。hdfs fs -fs hdfs://namenode:8020 -ls /可连接到指定NameNode的HDFS集群。 - 文件块管理:HDFS将大文件分割为默认128MB的块(可通过

dfs.blocksize配置),用户可通过hdfs fs -count <path>查看文件块数量,如hdfs fs -count -h /user/hadoop/input显示文件数、目录数及总大小。 - 性能优化:对于大文件操作,建议使用

-D dfs.blocksize=256m调整块大小以减少NameNode负载;批量操作时,可结合-f参数覆盖已存在文件,避免交互式确认。

命令使用场景示例

以下是一个典型数据处理流程中使用hdfs fs命令的示例:

- 创建输入目录:

hdfs fs -mkdir -p /user/hadoop/input - 上传本地数据:

hdfs fs -put local_data.csv /user/hadoop/input/ - 查看文件列表:

hdfs fs -ls -h /user/hadoop/input - 执行MapReduce任务后,查看输出目录:

hdfs fs -ls /user/hadoop/output - 下载结果文件:

hdfs fs -get /user/hadoop/output/result.txt ./

相关操作命令速查表

| 命令 | 功能描述 | 示例 |

|---|---|---|

hdfs fs -ls |

列出目录内容 | hdfs fs -ls /user/hadoop |

hdfs fs -mkdir |

创建目录 | hdfs fs -mkdir -p /user/hadoop/data |

hdfs fs -rm -r |

递归删除目录 | hdfs fs -rm -r /user/hadoop/output |

hdfs fs -put |

上传本地文件到HDFS | hdfs fs -put local.txt /input/ |

hdfs fs -get |

下载HDFS文件到本地 | hdfs fs -get /input/file.txt ./ |

hdfs fs -cat |

查看文件内容 | hdfs fs -cat /input/file.txt |

hdfs fs -du -h |

查看目录大小(人类可读格式) | hdfs fs -du -h /user/hadoop |

hdfs fs -chmod |

修改文件权限 | hdfs fs -chmod 644 /input/file.txt |

FAQs

Q1: 如何在HDFS中查找包含特定关键词的文件?

A1: 可通过hdfs fs -cat结合Linux管道和grep命令实现。hdfs fs -cat /user/hadoop/input/*.txt | grep "error"会在HDFS的input目录下所有.txt文件中搜索包含“error”的行,若需查找文件名,可使用hdfs fs -ls | grep "keyword"。

Q2: HDFS删除的文件能恢复吗?如何启用回收站功能?

A2: 默认情况下,HDFS删除的文件不可恢复,但可通过启用回收站功能实现临时恢复,在core-site.xml中配置fs.trash.interval(如360,单位为分钟,表示文件在回收站保留6小时),执行删除命令时使用-movetoTrash参数(如hdfs fs -rm -movetoTrash /user/hadoop/file.txt),文件会被移至用户主目录下的.Trash/Current路径,可通过hdfs fs -cp /user/hadoop/.Trash/Current/file.txt /user/hadoop/恢复。