HDFS(Hadoop Distributed File System)作为Hadoop生态的核心组件,其命令行工具(hdfs dfs命令)是用户与分布式文件系统交互的主要接口,深入理解这些命令的源码实现,有助于开发者掌握HDFS的底层工作机制,优化操作效率,甚至进行二次开发,本文将从命令入口、核心逻辑及源码结构三个维度展开分析。

命令入口与参数解析

HDFS命令的入口类是org.apache.hadoop.hdfs.tools.DFSAdmin,而用户常用的hdfs dfs命令实际通过org.apache.hadoop.fs.FsShell类实现,当用户执行hdfs dfs -ls /时,程序会通过GenericOptionsParser解析命令行参数,将-ls识别为操作类型,作为目标路径,源码中,FsShell的run()方法是命令调用的核心,它通过switch语句根据操作类型(如-ls、-put、-get)分发到不同的处理方法。ls()方法负责处理列目录操作,其内部会调用DistributedFileSystem实例的listStatus()方法,最终通过RPC协议向NameNode发送请求。

核心命令的源码实现逻辑

以-put命令为例,其源码实现在FsShell的copyFromLocal()方法中,该方法首先验证本地文件路径和HDFS目标路径的合法性,然后通过FileSystem.getConf()获取HDFS配置,创建FSDataOutputStream输出流,核心逻辑在于利用FileSystem.copyFromLocalFile()方法,该方法内部会根据文件大小选择上传策略:小文件直接通过FSDataInputStream读取并写入HDFS;大文件则采用ChunkedBlockUploader分块上传,每个块默认大小为64MB(可配置),通过Pipeline机制将数据块并行写入多个DataNode,源码中,DFSOutputStream类负责管理数据块的分片、校验和计算(如CRC32)以及与DataNode的通信,确保数据传输的可靠性和容错性。

源码结构与关键类

HDFS命令的源码结构围绕org.apache.hadoop.fs和org.apache.hadoop.hdfs.client包展开,关键类及其职责如下表所示:

| 类名 | 所在包 | 核心职责 |

|---|---|---|

FsShell |

org.apache.hadoop.fs |

命令行解析与分发,实现用户交互逻辑 |

DistributedFileSystem |

org.apache.hadoop.hdfs.client |

提供HDFS文件系统操作接口,如listStatus()、mkdirs() |

DFSClient |

org.apache.hadoop.hdfs.client |

封装RPC通信,与NameNode和DataNode交互 |

DFSOutputStream |

org.apache.hadoop.hdfs.client |

管理数据写入,包括分块、校验和、Pipeline通信 |

NameNode |

org.apache.hadoop.hdfs.server |

维护文件系统元数据,处理客户端请求 |

DataNode |

org.apache.hadoop.hdfs.server |

存储实际数据块,处理读写请求 |

在-mkdir命令执行时,DistributedFileSystem.mkdirs()会调用NameNodeRpcServer.mkdirs(),NameNode在内存中更新文件树元数据,并记录操作日志(EditLog),同时向DataNode发送创建目录的指令,源码中,FSNamesystem类是NameNode的核心,负责管理命名空间和块映射关系。

源码中的容错与性能优化

HDFS命令的源码中融入了大量容错机制,以-get命令为例,copyToLocal()方法在下载文件时会校验本地文件的校验和,若与HDFS存储的校验和不匹配,则触发重新下载。DFSInputStream实现了“读短路”(Short-circuit Read)优化,允许客户端直接从DataNode读取数据,绕过NameNode,减少网络开销,源码中,DomainSocket类实现了本地通信,进一步提升小文件读取性能。

相关问答FAQs

Q1: 为什么HDFS命令中-put大文件时会比小文件慢?

A: -put命令在处理大文件时会采用分块上传策略,每个块需要创建Pipeline、计算校验和、等待DataNode确认,这些操作会引入额外开销,而小文件可能因块大小配置(默认128MB)导致仅占用一个块,减少了分块和Pipeline建立的次数,大文件上传时网络抖动或DataNode负载较高也可能影响速度,可通过调整dfs.blocksize参数优化块大小,或使用-Ddfs.client.use.datanode.hostname=true绕过DNS解析来提升性能。

Q2: 如何通过源码定位HDFS命令执行失败的原因?

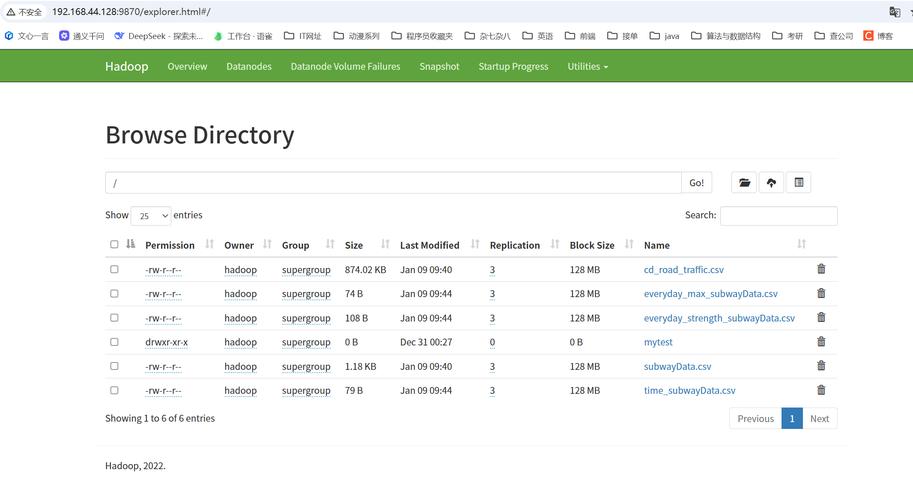

A: 首先通过命令行日志(如hdfs dfs -ls 2>&1 | grep ERROR)定位错误类型,若为RPC通信失败,可查看DFSClient源码中的getNamenode()方法,检查RPC超时配置(hadoop.rpc.timeout);若为DataNode写入失败,则检查DFSOutputStream的processDatanodeError()方法,分析DataNode返回的异常信息,可通过启用HDFS调试日志(log4j.logger.org.apache.hadoop.hdfs=DEBUG)跟踪详细调用链,结合NameNode和DataNode的Web UI(如http://namenode:9870/dfshealth.html)查看块状态和节点健康情况,进一步定位问题根源。