在当前大数据技术快速发展的背景下,Apache Kudu凭借其高吞吐、低延迟的实时数据存储能力,成为许多企业构建实时数仓和OLAP场景的核心组件,随着业务需求的不断升级,掌握Kudu开发技术的专业人才在招聘市场上备受青睐,企业对Kudu开发工程师的技能要求也逐渐向复合型、实战型方向转变。

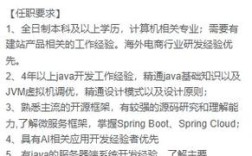

Kudu开发岗位的招聘通常围绕技术栈深度、工程实践能力和业务理解能力展开,从技术栈来看,候选人需熟练掌握Java或C++开发语言,这是Kudu底层开发的核心语言;需具备Hadoop生态体系的实践经验,包括HDFS、YARN、MapReduce等组件的协同工作原理,以及Spark、Flink等计算引擎与Kudu的集成开发能力,在实时数仓架构中,工程师需要设计Kudu表结构以支持高并发写入和复杂查询,优化数据分区策略(如范围分区、哈希分区)和副本分布方案,确保数据读写性能满足业务SLA要求,对Kudu的底层存储机制(如列式存储、内存管理、事务处理)的理解也是加分项,这有助于在遇到性能瓶颈时快速定位问题,比如通过调整tablet数量、优化MemStore flush策略等方式提升系统稳定性。

工程实践能力方面,企业重点关注候选人的问题排查和优化经验,Kudu集群在高负载下可能出现tablet不平衡、RPC超时、数据不一致等问题,招聘时通常会考察候选人是否具备使用Kudu Manager工具、日志分析、性能监控(如Prometheus+Grafana)进行故障排查的能力,在生产环境中遇到Kudu写入延迟升高的情况,候选人需要能够从网络带宽、磁盘I/O、MemStore内存使用等多个维度分析原因,并通过调整并发度、增加缓存等手段进行优化,熟悉CI/CD流程、容器化部署(如Docker、Kubernetes)的候选人更受青睐,因为现代大数据平台普遍倾向于采用云原生架构,Kudu集群的自动化运维和弹性扩缩容能力已成为企业刚需。

业务理解能力则是区分资深工程师与初级开发者的关键,Kudu开发并非单纯的技术实现,需要结合业务场景进行设计,在金融风控场景中,需设计支持高吞吐、低延迟的实时特征存储表,确保风控规则引擎能够快速获取最新数据;在物联网场景中,则需解决海量时序数据的写入与高效查询问题,可能需要结合Kudu的倒排索引或外部列索引功能,招聘时会考察候选人是否具备将业务需求转化为技术方案的能力,比如通过合理设计主键、预分区、列裁剪等手段,在保证数据一致性的同时最大化查询性能。

软技能同样不容忽视,Kudu开发往往需要与数据开发、算法、运维等多个团队协作,因此良好的沟通能力、文档编写能力和项目管理能力也是企业重点考察的方向,在需求评审阶段,工程师需要清晰阐述技术方案的优劣;在项目推进过程中,需通过详细的开发文档和测试报告确保团队协作效率。

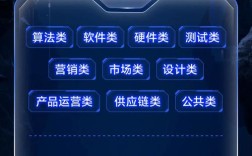

以下是Kudu开发岗位常见技能要求的总结:

| 技能类别 | 具体要求 |

|---|---|

| 编程语言 | 熟练掌握Java或C++,了解多线程、网络编程等基础 |

| 大数据生态 | 熟悉Hadoop、Spark、Flink,掌握Kudu与Spark SQL/Flink SQL的集成开发 |

| Kudu核心技术 | 理解存储架构、事务模型、高可用机制,能独立进行表设计、性能调优和故障排查 |

| 运维与监控 | 掌握Kudu集群部署、扩缩容,熟悉Prometheus、Grafana等监控工具的使用 |

| 云原生技术 | 了解Docker、Kubernetes,具备容器化部署和自动化运维经验 |

| 业务场景 | 有实时数仓、OLAP、物联网等场景的Kudu落地经验者优先 |

相关问答FAQs

Q1:Kudu开发工程师与Hadoop开发工程师的主要区别是什么?

A1:Kudu开发工程师专注于实时数据存储层的开发与优化,重点在于Kudu的架构设计、性能调优及与实时计算引擎的集成,强调低延迟、高并发的数据处理能力;而Hadoop开发工程师更侧重于分布式文件系统(HDFS)、MapReduce、YARN等组件的通用大数据处理,通常处理的是批量或离线场景的数据任务,Kudu开发需要更深入的理解存储引擎底层机制,而Hadoop开发则更偏向于生态组件的应用和分布式计算逻辑的实现。

Q2:如何快速提升Kudu开发能力以适应招聘需求?

A2:通过官方文档和源码深入学习Kudu的架构原理,包括TabletServer、Master、事务日志等核心组件的工作机制;搭建本地Kudu集群进行实践操作,尝试创建不同表结构、写入测试数据并分析查询性能,掌握常见问题的排查方法;参与开源社区或实际项目,例如使用Kudu+Spark构建实时数仓场景,积累实战经验;关注行业案例,学习企业在生产环境中如何优化Kudu集群性能,如通过调整内存配置、分区策略等方式提升系统吞吐量。