在HBase中批量导入数据是大数据处理场景下的常见需求,通常涉及高效地将大量数据从外部数据源(如HDFS、本地文件、其他数据库等)加载到HBase表中,以下是关于HBase命令批量导入数据的详细说明,包括常用方法、操作步骤、注意事项及示例。

HBase批量导入数据的核心目标是提高数据加载效率,减少对集群性能的影响,常用的批量导入方法主要包括使用HBase提供的ImportTsv工具、通过MapReduce作业批量导入、使用BulkLoad机制以及借助第三方工具(如Sqoop、DataX等)。BulkLoad方式因其高效率和对集群负载影响小而成为生产环境的首选,而ImportTsv则适用于从TSV文件直接导入的场景。

使用ImportTsv工具批量导入数据

ImportTsv是HBase自带的一个命令行工具,用于将TSV(制表符分隔值)格式的数据导入到HBase表中,其基本原理是将数据文件解析为KeyValue格式,然后通过HBase的API写入表中,操作步骤如下:

-

准备数据文件:确保数据文件为TSV格式,每行代表一条记录,包含行键(RowKey)、列族(Column Family)、列限定符(Column Qualifier)和时间戳(Timestamp,可选),字段之间用制表符分隔。

rowkey1 cf1:col1 value1 rowkey1 cf1:col2 value2 rowkey2 cf2:col1 value3 -

执行导入命令:使用

hbase org.apache.hadoop.hbase.mapreduce.ImportTsv命令,基本语法为: (图片来源网络,侵删)

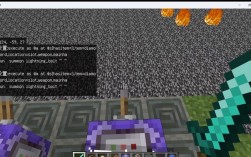

(图片来源网络,侵删)hbase org.apache.hadoop.hbase.mapreduce.ImportTsv -Dimporttsv.columns="HBASE_ROW_KEY,cf1:col1,cf1:col2" -Dimporttsv.bulk_output=hdfs://namenode:8080/output_path tableName input_path

参数说明:

-Dimporttsv.columns:指定列的映射关系,HBASE_ROW_KEY表示行键,后续为列族:列限定符。-Dimporttsv.bulk_output:指定临时输出路径,用于生成HFile文件(若不指定,则直接写入HBase表,效率较低)。tableName:目标HBase表名。input_path:输入数据文件路径(支持HDFS或本地路径)。

-

直接导入或生成HFile:若未指定

bulk_output,数据会直接写入HBase表,适合小数据量;若指定,则会生成HFile文件,需通过load_table命令导入表中(见BulkLoad部分)。

使用BulkLoad机制批量导入数据

BulkLoad通过直接生成HFile文件并移动到HBase表对应的RegionServer存储目录中,避免了通过WAL(Write-Ahead Log)写入数据,从而大幅提升导入速度,降低集群负载,操作步骤如下:

-

生成HFile文件:可通过MapReduce作业或

ImportTsv工具生成HFile文件,以MapReduce为例,需自定义TableMapper和TableReducer,其中Reducer的输出格式为HFileOutputFormat2,代码示例如下: (图片来源网络,侵删)

(图片来源网络,侵删)Configuration conf = HBaseConfiguration.create(); Job job = Job.getInstance(conf, "BulkLoadExample"); job.setMapperClass(TableMapper.class); job.setReducerClass(TableReducer.class); job.setOutputKeyClass(ImmutableBytesWritable.class); job.setOutputValueClass(Put.class); FileOutputFormat.setOutputPath(job, new Path("hdfs://namenode:8080/hfile_output")); job.setOutputFormatClass(HFileOutputFormat2.class); HFileOutputFormat2.configureIncrementalLoad(job, table, tableDesc); -

加载HFile到HBase表:生成HFile文件后,使用

completebulk_load命令将其导入表中:hbase org.apache.hadoop.hbase.mapreduce.LoadIncrementalHFiles hdfs://namenode:8080/hfile_output tableName

执行前需确保HBase表已创建,且HFile文件的目录结构与HBase表的列族匹配。

使用MapReduce批量导入数据

对于复杂的数据转换逻辑,可通过MapReduce作业批量导入数据,基本流程为:

- 自定义Mapper:读取输入数据(如HDFS上的文件),解析后生成

Put对象。 - 配置TableMapReduceUtil:设置输入输出格式、Mapper和Reducer类。

- 提交作业:将MapReduce作业提交到Hadoop集群,数据通过HBase API写入表中。

批量导入的注意事项

- 数据格式一致性:确保导入数据的格式与HBase表结构(列族、列限定符)匹配,避免数据解析错误。

- Region预分区:导入前可对HBase表进行预分区,避免导入过程中Region分裂导致性能下降。

- 集群资源管理:大数据量导入时,需适当调整MapReduce作业的资源配置(如Map和Reduce任务数、内存等),避免资源耗尽。

- 错误处理:导入过程中可能出现数据格式错误、RegionServer宕机等问题,需通过日志监控和重试机制保障数据一致性。

- 性能优化:BulkLoad方式性能最优,建议优先使用;直接写入表的方式适合小数据量或实时性要求高的场景。

批量导入性能对比

| 方法 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|

| ImportTsv直接导入 | 简单易用,无需额外代码 | 速度较慢,对集群压力大 | 小数据量,快速测试 |

| ImportTsv生成HFile | 可结合BulkLoad,效率较高 | 需额外步骤生成HFile | 中等数据量,结构化数据导入 |

| BulkLoad | 速度快,集群负载低 | 需生成HFile,流程稍复杂 | 大数据量,生产环境批量导入 |

| MapReduce导入 | 灵活,支持复杂数据转换 | 开发复杂,依赖MapReduce框架 | 需要数据预处理或复杂逻辑的场景 |

相关问答FAQs

Q1: 使用BulkLoad导入数据时,如何处理HFile文件与现有数据的冲突?

A1: BulkLoad导入的HFile文件会直接追加到HBase表中,若行键(RowKey)与现有数据重复,HBase会保留新导入的数据(即覆盖旧数据),若需避免覆盖,可在生成HFile时对RowKey进行唯一性处理,或在导入前对目标表进行清空(需谨慎操作),可通过设置HBase表的VERSIONS参数保留多版本数据,冲突时通过时间戳或版本号控制数据覆盖逻辑。

Q2: 批量导入过程中出现“RegionTooBusyException”错误,如何解决?

A2: “RegionTooBusyException”通常表明RegionServer处理请求的压力过大,可通过以下方式解决:1)降低导入并发度,如减少MapReduce的Map任务数或分批导入数据;2)增加RegionServer的内存配置,调整hbase.regionserver.handler.count参数以提升处理能力;3)对HBase表进行预分区,分散Region负载;4)使用BulkLoad替代直接写入,减少RegionServer的压力,若问题持续,需检查集群资源(如CPU、内存、磁盘IO)是否充足。